Informática

Seguridad IP (Internet Protocol)

SEGURIDAD IP

GENERALIDADES, ARQUITECTURA, AUTENTIFICACIÓN, GESTION DE CLAVES Y PROTOCOLOS DE INTERNET

PROTECCION DE LA INFORMACION

JUNIO 2005

INDICE DE CONTENIDOS

INDICE DE CONTENIDOS

………………………………………………………………………………………… 1

DESCRIPCION DEL TRABAJO ELABORADO

………………………………………………………………………………………… 2

PROCESO DEL TRABAJO ELABORADO

………………………………………………………………………………………… 3

GENERALIDADES

………………………………………………………………… 4 - 6

ARQUITECTURA

………………………………………………………………… 7 - 13

AUTENTIFICACION

………………………………………………………………… 14 - 16

GESTION DE CLAVES

………………………………………………………………… 17 - 24

PROTOCOLOS DE INTERNET

Descripción de los protocolos TCP/IP

………………………………………………………… 25 - 28

IPSec: El estándar de Seguridad IP

………………………………………………………… 29 - 40

CONCLUSIONES

………………………………………………………………………………………… 41

BIBLIOGRAFIA Y RECURSOS DE INTERNET

………………………………………………………………………………………… 42 - 43

DESCRIPCION DEL TRABAJO ELABORADO

Para la realización de este trabajo hemos seguido la línea que se nos especificaba en los requisitos del mismo, es decir, comenzamos con una visión general de la red TCP/IP explicando como nace y su posterior desarrollo, todo esto lo explicamos en el primer apartado, el de generalidades, que nos podría servir de breve introducción a nuestro trabajo, a continuación entraremos a estudiar la arquitectura que lo compone, la autentificación, la gestión de claves y los protocolos, en este ultimo nos centraremos en los protocolos de seguridad IP.

En el primer apartado, generalidades realizamos un recorrido que comienza en los años 60, con la asociación de diversas universidades de Estados Unidos y otros organismos de investigación, y su estudio de las nuevas tecnologías. Este fue el primer paso, para la consecución de la primera red de comunicación, ARPANET, en 1969. Este experimento continuó con la mejora de los protocolos que la componían, y en 1974 Cerf y Kahn desarrollan el Protocolo de Internet IP, y el Protocolo de Transmisiones TCP. A partir de este momento, el crecimiento de esta red fue exponencial, en tres años se triplico en número de computadoras. Este crecimiento ha sido continuo hasta nuestros días, ya que en los años noventa, TCP/IP llegó al mundo comercial, y se estableció como el software de red más disponible universalmente.

Una vez situados en el contexto histórico, nos adentraremos en la arquitectura que compone este protocolo IP, y en donde se engloba. Para ello explicaremos las diversas capas que componen el protocolo TCP/IP: física, enlace de datos, de red IP, de transporte TCP y UDP, y de aplicación. Sin olvidarnos del empaquetado que sufren los datos en su transporte. Haremos mención a los encaminadores y sus topologías, y en especial el de IP.

Una vez entendida la arquitectura que compone el protocolo TCP/IP, y el papel que juega IP, entraremos en el ámbito de la seguridad, y en primer lugar, en el de la autentificación, consiste en saber quien es quien, un aspecto muy importante en este tipo de redes, para ello explicaremos como se utilizan los identificadores de usuario (ID) y las contraseñas que identifica a estos. Además, alertaremos del peligro que existe debido a la posibilidad que existe de que un usuario no autorizado capte dichas contraseñas. Explicaremos una tecnología de autentificación, muy eficaz, la message digest y especificaremos los tipos de ataques de autentificación que podemos sufrir.

En este apartado, Gestión de Claves hemos comprobado que la seguridad de un algoritmo descansa en la clave. Por lo que esta es de gran importancia. Hablaremos de varios protocolos encargados de la gestión de claves, como el de dos fases, IKE, que aprovechando la infraestructura de intercambio de mensajes del protocolo ISAKMP proporciona un canal autentico y seguro entre dos usuarios cualesquiera conectados a INTERNET. Y daremos un ejemplo en Windows 2000.

El ultimo punto, Protocolos, realizaremos un análisis de los protocolos que componen TCP/IP, clasificándolos según a la capa que pertenecen, tal y como se aclaró en el segundo punto, y a continuación se explicara el protocolo de seguridad IP, el IPSec. En este ultimo apartado nos centraremos en tres protocolos, el AH, ESP y el IKE, el protocolo de control. Además de exponer los diversos servicios de seguridad que ofrece IPSec, y las diversas aplicaciones prácticas que se dan en la actualidad.

PROCESO DEL TRABAJO

Como ya hemos especificado con anterioridad, hemos seguido la línea marcada por las especificaciones del profesor, y hemos comenzado desde un nivel de abstracción mayor hacia los detalles de la seguridad IP. Así que comenzamos con las generalidades, este apartado nos sitúa en el marco social-económico en el que se desarrolla la arquitectura TCP/IP, y la información la hemos obtenido del libro: La biblia de TCP/IP.

El siguiente apartado es el referente a la arquitectura del protocolo IP, y de la arquitectura a la que pertenece, TCP/IP, de igual forma hemos obtenido la información del libro ya mencionado: La biblia de TCP/IP y de otro libro de gran interés: TCP/IP arquitectura, protocolos e implementación con IPv6 y seguridad de IP.

A continuación nos adentramos en el concepto de la autentificación, y su gran importancia dentro de redes tan amplias como las que se pueden formar con TCP/IP, la información de este apartado la hemos obtenido del libro: TCP/IP arquitectura, protocolos e implementación con IPv6 y seguridad de IP.

En el penúltimo lugar se encuentra la gestión de claves, para este apartado nos hemos basado de varias páginas Web:

-

www.walc03.ula.ve/talleres/practicas/Practica5.doc

-

http://usuarios.lycos.es/cipsecurity

-

http://www.ugr.es/~aquiran/cripto/informes

Y de diversos libros: Criptografía y Seguridad en Computadores y Seguridad y protección de la información.

Para la realización del apartado referente a los protocolos relacionados con la Seguridad IP, hemos enfocado nuestro estudio desde dos puntos de vista, uno mas general, en el que hemos descrito el conjunto de protocolos que forman parte de una arquitectura TCP/IP, en donde hemos explicado los problemas que conlleva el nivel de red, IP. La información de este apartado la hemos obtenido en gran parte del libro: REDES IP. Alta velocidad y calidad de servicio en redes IP

En la segunda parte de este apartado, nos hemos centrado en el estandar IPSec, que incorpora servicios de seguridad en IP y que responde a la necesidad creciente de garantizar un nivel de seguridad imprescindible para las comunicaciones entre empresas y el comercio electrónico. La información referente a este apartado, la hemos obtenido de diversas páginas web:

-

CONEXIONES IPSec EN MULTIPLES PLATAFORMAS.

http://www.depeca.uah.es/wwwnueva/docencia/ING-TELECO/proyectos/trabajos/grupo4/presentacion_IPsec_archivos/frame.htm

-

Análisis del protocolo IPSec: El estándar de seguridad IP

http://www.tid.es/presencia/publicaciones/comsid/esp/23/04.pdf

GENERALIDADES

A finales de los años 60, la Agencia de proyectos avanzados de investigación del Departamento de Defensa de los Estados Unidos o ARPA, posteriormente llamada DARPA, comenzó una asociación con universidades de los Estados Unidos y otros organismos de investigación para investigar sobre nuevas tecnologías de comunicación de datos.

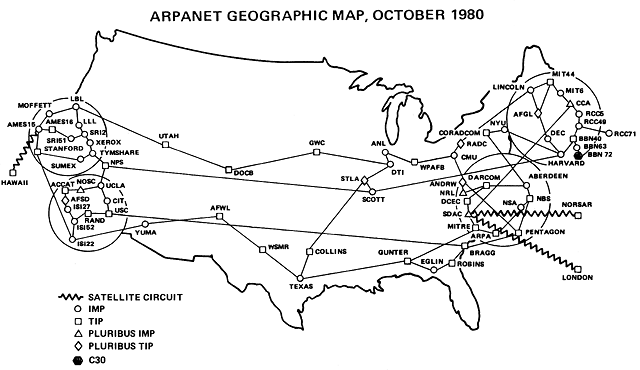

Entre los participantes construyeron la Red de la agencia de proyectos avanzados de investigación. (ARPANET - Advance Research Projects Agency Network), la primera red de comunicación de paquetes. En 1969 comenzó a funcionar una versión experimental de ARPANET con cuatro nodos.

Mapa geográfico de ARPANET en 1980.

El experimento fue un éxito y a partir de ahí evoluciono hasta cubrir los Estados Unidos de costa a costa. En 1975, la agencia de comunicaciones para la defensa (DCA - Defense Communications Agency) asumió la responsabilidad del funcionamiento de la red, que aun era considerada una red de investigación.

Los protocolos iniciales de ARPANET eran lentos y solían sufrir frecuentes problemas. En 1974, Cerf y Kahn propusieron el diseño de un nuevo núcleo de protocolos. El diseño de Cerf y Kahn supuso los siguientes desarrollos del Protocolo de Internet (IP) y del Protocolo de control de transmisiones (TCP). A partir de 1980, se tardo 3 años en convertir los host de ARPANET, que eran menos de 100, al nuevo grado de protocolos.

La versatilidad de los nuevos protocolos se comprobó en 1978 en una demostración en la que un terminal desde un automóvil, que conducía por una autopista de California, transmitía datos por Radio paquetes a un nodo SRI internacional, cruzando el continente mediante ARPANET, y después a través de una red por satélite a un host en Londres.

A principios de los años 80, ARPANET contaba con más de 300 computadoras y se había convertido en un valioso recurso para sus usuarios. En 1984, la ARPANET original se dividió en dos partes. Una se siguió llamando ARPANET y se dedico a la investigación y desarrollo. La otra se llamo MILNET y se convirtió en una red militar no clasificada.

En 1982, el Departamento de defensa de los Estados Unidos (DOD) decidió adoptar un único conjunto de protocolos de comunicaciones según los protocolos de ARPANET y creo la Red de datos para la defensa (DDN - Defense Data Network) como entidad padre que aunaba sus redes operativas distribuidas.

En 1983, el Departamento de defensa adopto el grupo de protocolos TCP/IP como su estándar. La aceptación de TCP/IP se difundió hacia otros departamentos de defensa, creando un gran mercado de tecnología.

TCP/IP tiene algunas características únicas que justifican su durabilidad. La arquitectura que emplea agrupa bancos de redes, creando una red mayor llamada Internet. Para un usuario, una Internet aparece simplemente como una red compuesta por todos los host conectados a cualquiera de los nodos que la forman.

Los protocolos de TCP/IP se diseñaron para ser independientes del hardware del host o de su sistema operativo, así como las tecnologías de los medios y de los enlaces de datos. Se requería que los protocolos fuesen robustos, sobreviviendo a altas tasas de error en la red y con capacidad de encaminamiento adaptativo trasparente en el caso de que se perdiesen nodos o enlaces.

Cuando el Departamento de defensa de los Estados Unidos y otras agencia gubernativas impusieron como requisito los protocolos de TCP/IP en las compras de los computadores, los fabricantes se enfrentaron a la necesidad de implementar TCP/IP para competir en los concursos del gobierno.

El departamento de defensa de los Estados Unidos promovió la disponibilidad de TCP/IP financiando a Bolt, Beranek y Newman (BBN) para la implementación de TCP/IP para Unix y a la universidad de California en Berkeley para incorporar el código de BBN en el sistema operativo Unix 4.2 de la distribución de software de Berkeley (BSD). Este sistema operativo y sus sucesores se han migrado a muchas plataformas hardware. Mas tarde, TCP/IP se incorporo a Unix Sistema V de AT&T.

En los años noventa, TCP/IP llego al mundo comercial. Es el software de red más disponible universalmente. Ha habido un rápido progreso al integrar TCP/IP junto con los servidores LAN y los sistemas operativos de sobremesa.

La INTERNET

La facilidad para agrupar las redes de TCP/IP combinado con una política de puertas abiertas que permitía a las redes de investigación, académicas y comerciales conectarse a ARPANET, hizo crecer la superred llamada Internet. Durante los años 80, ARPANET se mantenía como red troncal de esta creciente red.

Gracias a las características de los protocolos TCP/IP, el crecimiento de Internet era continuado y sin pausa. Internet se convirtió en la mayor red del mundo, contando básicamente con redes del gobierno, de investigación militar y académica y redes comerciales, cada una con cientos de subredes. En 1985 se incorporo una nueva red troncal, la red de la Nacional Sciencie Foundaation (NSFNET) para disponer de enlaces de alta velocidad para centros de investigación y súper computación.

Con la ayuda del gobierno crecieron una gran cantidad de proveedores de servicios regionales en todas las zonas de los Estados Unidos. Las universidades y laboratorios de investigación se conectaban al proveedor regional más cercano, que a su vez, se conectaba a la red troncal.

Internet se extendió por todo el globo, apareciendo proveedores por todos los países del mundo. En 1994, había millones de computadoras interconectadas e Internet estaba preparada para el mercado comercial. La Nacional Sciencie Foundation (NFS) dio su apoyo y los proveedores de servicios de los Estados Unidos se conectaron en unos grandes centros de conmutación distribuidos por todo el país.

La INTERNIC

Durante muchos años el departamento de defensa mantenía un importante papel de coordinación en Internet. Su Centro de información de red de la DDN (DDN NIC) proporcionaba servicios a los usuarios, administradores de host, coordinadores de lugares y administradores de red.

En el verano de 1993, las fundaciones de apoyo a los usuarios civiles de Internet pasaron a la Nacional Sciencie Foundation, que financia dos agencias:

-

Servicios de registro de InterNIC, situada en Network Solutions, Inc., Rendón, Virginia.

-

Servicios de directorio y base de datos de InterNIC, por AT&T.

Se han establecido centros de registro adicionales en otros países. Los centros de registro coordinan los nombres y direcciones de las computadoras TCP/IP.

Los servicios de directorio y base de datos de InterNIC funcionan como fuente de las normas de Internet y otros documentos de información. Todos los documentos son gratuitos.

ARQUITECTURA

Introducción

TCP/IP se diseño para un entorno que resultaba bastante poco usual en los años 70 pero que ahora es bastante habitual. El protocolo TCP/IP debía conectar equipos de distintos fabricantes, debía ser capaz de ejecutarse en diferentes tipos de medios y enlaces de datos, debía unir conjuntos de redes en una única Internet, de forma que todos sus usuarios pudiesen acceder a un conjunto de servicios genéricos.

Estos requisitos conformaron la arquitectura del protocolo. La necesidad de independencia de la tecnología del medio y la conexión automática a una red en crecimiento, condujo a la decisión de transmitir los datos por una Internet troceándolos en piezas y encaminando cada pieza como una unidad independiente.

Las funciones que garantizan una transmisión de datos fiable se situaron en los host origen y destino. Por ello, los fabricantes de encaminadotes podían centrar sus esfuerzos en mejorar el rendimiento y mantenerse en las nuevas tecnologías de comunicaciones.

Al hacerlo así, los protocolos de TCP/IP consiguieron escalarse muy bien, ejecutándose en sistemas que iban desde las grandes computadoras hasta el PC. De hecho, un útil subconjunto de administración de red se traslada a dispositivos de la red “sin inteligencia”, como los puentes, multiplexores y conmutadores.

Estructura en capas

Para conseguir un intercambio fiable de datos entre computadoras, se deben llevar a cabo muchos procedimientos separados:

-

Empaquetar los datos

-

Determinar el camino que deben seguir.

-

Transmitirlos por el medio físico.

-

Regular la tasa de transferencia de acuerdo con el ancho de banda disponible y la capacidad del receptor para absorber los datos.

-

Ensamblar los datos entrantes para que se mantengan en la secuencia correcta y no haya pérdida de trozos.

-

Comprobar los datos entrantes para ver si hay trozos repetidos.

-

Notificar al emisor que los datos se han recibido correctamente.

-

Entregar los datos a la aplicación correcta. Manejar evento de errores y problemas.

El resultado es que el software de comunicaciones es complejo. Con un modelo en capas resulta más sencillo agrupar funciones relacionadas e implementar el software de comunicaciones de forma modular.

La estructura seleccionada para los protocolos TCP/IP proviene de requisitos que evolucionaron en las comunidades académicas y de defensa. IP hace lo necesario para agrupar distintos tipos de redes en Internet. TCP proporciona transferencia fiable de datos.

El modelo de comunicaciones de datos OSI se vio influido fuertemente por el diseño de TCP/IP. Las capas de OSI y la terminología de OSI se han convertido en una parte estándar de la cultura de las comunicaciones de datos.

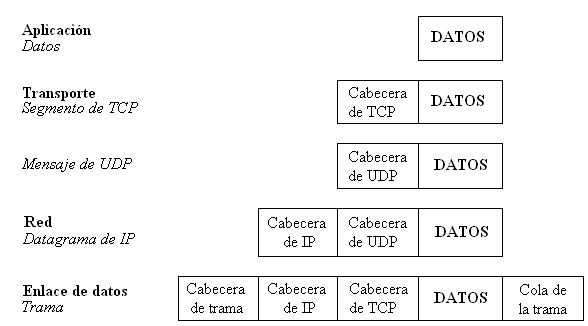

A continuación se explica de forma superficial lo que ocurre en cada una de las capas:

Capa física: La capa física trata con el medio físico, los conectores, el control de señales eléctricas representadas en unos (1) y ceros (0) binarios. Por ejemplo, las tarjetas de interfaz de red de Ethernet y Token-Ring y los cables implementan las funciones de la capa física.

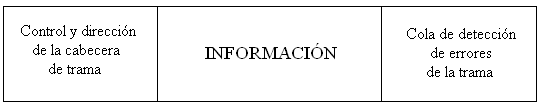

Capa de enlace de datos: Se lleva a cabo la organización de unidades de datos llamadas tramas. Cada trama tiene una cabecera que incluye una dirección e información de control y una cola que se usa para la detención de errores.

La cabecera de una trama de Red de área local (LAN) contiene las direcciones físicas del origen y el destino, identificando las tarjetas de interfaz de red del origen y el destino de la LAN. La cabecera de una trama que se transmite por una Red de área extensa (WAN) contiene un identificador de circuito en su campo de dirección.

Formato de trama.

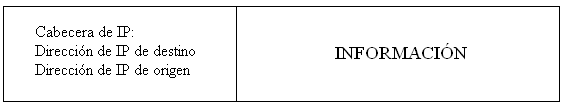

Capa de Red: IP. IP realiza funciones en la capa de Red, IP encamina datos entre sistemas. Los datos pueden atravesar un enlace único o enviarse por múltiples enlaces a través de Routers, los datos se transportan en unidades de bits llamados datagramas. Un datagrama contiene una cabecera de IP que contiene información de direcciones de la capa 3 (Transporte), los encaminadores examinan la dirección de destino de la cabecera IP, para dirigir los datagramas al destino.

La capa de IP se denomina no orientada a conexión ya que cada datagrama se encamina de manera independiente e IP no garantiza la entrega fiable, ni secuencia de los mismos. IP sólo encamina su tráfico sin tener en cuenta la relación entre las aplicaciones a las que pertenece un determinado datagrama.

Datagrama de IP

Capa de Transporte: TCP. El Protocolo de Control de Transmisión realiza labores en la capa de transporte, debido a que proporciona a las aplicaciones servicios de conexión fiable de datos, por lo tanto, es un protocolo orientado a conexión. TCP dispone de los mecanismos que garantizan que los datos se entregan sin errores, sin omisiones y en secuencia.

Una aplicación, como la de transferencia de archivos, transmite datos a TCP. TCP le añade una cabecera creando una unidad denominada segmento. TCP envía los segmentos pasándoselos a su nivel inferior Capa 3 (IP) quien los encamina a su destino. Del otro lado TCP acepta los segmentos entrantes de IP, determina la aplicación de destino y traslada los datos a la aplicación en el orden en que fueron enviados.

Capa de Transporte: UDP. Una aplicación envía un mensaje independiente a otra aplicación mediante el Protocolo de Datagramas de Usuario (UDP). UDP añade una cabecera creando una unidad denominada datagrama de UDP o mensaje de UDP. UDP traslada los mensajes de UDP salientes a IP. UDP acepta mensajes de UDP entrantes de IP y determina la aplicación de destino. UDP es un servicio de comunicaciones no orientado a conexión que suele usarse en aplicaciones de búsquedas simples en bases de datos.

Capa de Aplicación: El Protocolo de Control de Transmisión incluye una variedad de servicios como; Telnet, FTP, WEB, Correo, IRC, Vídeo Conferencia entre otros.

Empaquetado de datos para su transmisión

El término genérico para la información junto con una cabecera apropiada de una capa es Unidad de datos del protocolo (PDU). Por ejemplo, un segmento TCP es una PDU de la capa de transporte y un datagrama de IP es una PDU de la capa de red. La siguiente figura muestra como se empaquetan los datos para su transmisión:

Empaquetado de datos para su transmisión.

Descripción general del protocolo

Aunque no se han normalizado formalmente las interfaces textuales de las interfaces de usuario para la transferencia de archivos, el Terminal virtual, las noticias ni la traducción de nombre a dirección del Sistema de nombres de dominio, la mayoría de los fabricantes suelen ofrecer un conjunto de comandos, copia de las interfaces de usuario del Unix de la distribución de software de Berkeley. Para los usuarios que trabajen en el modo textual en dos tipos de host distintos resulta muy útil que las interfaces del usuario permanezcan casi iguales al cambiarse de sistema.

Existen muchas interfaces graficas de usuario (GUI) para los sistemas Windows y Macintosh. Aunque difieren en los detalles, siguen las convenciones del sistema operativo y normalmente se pueden usar sin un entrenamiento especial.

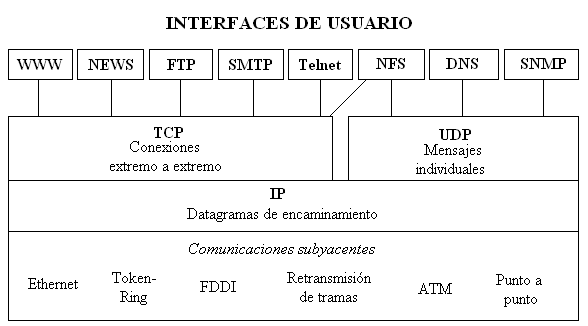

Componentes del conjunto de protocolos TCP/IP.

Los clientes de World Wide Web, noticias, transferencia de archivos (FTP), correo electrónico y Terminal virtual (telnet) se comunican con sus servidores mediante conexiones fiables de TCP. La mayoría de los clientes de archivos de NFS intercambian mensajes de UDP con sus servidores, aunque algunas implementaciones de NFS se pueden ejecutar tanto sobre UDP como sobre TCP.

Las búsquedas de directorio del Sistema de nombres de dominio utilizan mensajes de UDP. Las estaciones de administración del protocolo simple de gestión de red (SNMP) obtienen información de los dispositivos de red mediante mensajes de UDP.

Encaminadores y topología

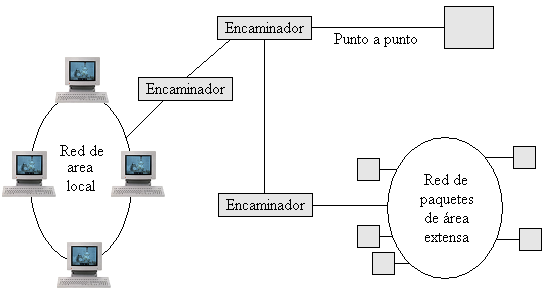

El conjunto de protocolos de TCP/IP se pueden utilizar en LAN y WAN independientes o en complejas Internet creadas por la unión de muchas redes. Cualquier host con TCP/IP se puede comunicar con otro por LAN, con una línea punto a punto o una red de paquetes de área extensa.

Las redes se pueden interconectar en una Internet con encaminadores de IP.

Interconexión de redes con encaminadores.

Los modernos productos de encaminamiento disponen de múltiples ranuras de interfaz hardware configurables según la necesidad de conexión del usuario: Ethernet, Token-Ring, Interfaz de datos distribuidos por fibra (FDDI), conexión punto a punto sincronía, retransmisión de tramas u otros.

La Internet se puede construir con cualquier mezcla de topologías. Sin embargo, cuando la Internet tiene una estructura coherente, a los encaminadores les resulta mas sencillo realizar su trabajo eficientemente y reaccionar rápidamente a fallos en cualquier lugar de la red, cambiando los caminos de los datagramas para evitar los puntos conflictivos. Un diseño lógico y fácil de entender ayuda a los administradores de red a diagnosticar, localizar y reparar fallos en red.

El robusto y competitivo mercado de encaminadores de IP ha promovido la arquitectura de TCP/IP. Los fabricantes de encaminadores implantan rápidamente las nuevas tecnologías de LAN y de WAN, ampliando las opciones de conectividad de sus clientes. La relación precio/rendimiento de un encaminador se ha reducido continuadamente durante los últimos años.

Encaminamiento de IP

El software de IP se ejecuta en host y en encaminadotes de IP. Si el destino de un datagrama no esta en el mismo enlace que el host origen, el IP de host dirige el datagrama a un encaminador local. Si el encaminador no esta directamente conectado con el enlace de destino, hay que enviar el datagrama a otro encaminador. Este proceso continua hasta que se alcanza el enlace de destino.

IP encamina hacia lugares remotos buscando la red de destino en una tabla de encaminamiento. Una tabla de entrada de encaminamiento identifica el encaminador del siguiente salto que debe seguir el tráfico para conseguir llegar a su destino.

En una Internet estática y pequeña, las tablas de encaminamiento se pueden crear y mantener manualmente. En Internet mayores los encaminadotes mantienen sus propias tablas actualizadas intercambiando información unos con otros. Los encaminadotes pueden descubrir dinámicamente:

-

Si se ha añadido una red a la Internet.

-

Que el camino a un destino ha fallado y que ya no se puede alcanzar dicho destino.

-

Se ha añadido un nuevo encaminador a la Internet. Este encaminador proporciona un camino mas corto a ciertos lugares.

No existe una única norma para el intercambio de información entre encaminadotes. La libertad de elección del protocolo ha estimulado la competencia y por tanto ha conseguido una gran mejora en estos protocolos.

Las funciones de red bajo el control de una organización se denomina Sistema Autónomo (AS - Autonomous System). Una organización puede elegir el protocolo de intercambio de información de encaminamiento que desee su propio Sistema autónomo. El protocolo de intercambio de información de encaminamiento dentro de un sistema autónomo se denomina Protocolo interior de pasarela (IGP - Interior Gateway Protocol). El Protocolo de información de encaminamiento (RIP - Routing Information Protocol) es un estándar muy usado del protocolo de pasarela interior. RIP es muy popular por su sencillez y su gran disponibilidad. Sin embargo el nuevo protocolo Primero el camino abierto más corto (OSPF) dispone de un conjunto más rico de funciones.

Arquitectura de TCP

TCP se implanta en host. La entidad TCP en cada extremo de una conexión debe asegurar que los datos se entregan a su aplicación local de forma:

-

Precisa.

-

En secuencia.

-

Completa.

-

Libre de duplicados.

El mecanismo básico para conseguirlo se ha utilizado desde el inicio de las comunicaciones de datos. El TCP emisor:

-

Numera los segmentos.

-

Fija un temporizador.

-

Transmite el segmento.

El TCP receptor tiene que mantener informado al emisor del número de datos correctos recibidos mediante una confirmación (ACK). Si no llega el ACK para un segmento dentro del plazo del temporizador, TCP reenvía el segmento. Esta estrategia se denomina retransmisión con confirmación positiva. A veces la retransmisión puede causar que se entreguen en segmentos repetidos al TCP receptor.

El TCP receptor debe reordenar los segmentos entrantes en el orden correcto, descartando los repetidos. TCP entrega los datos a la aplicación en orden, sin perdida de trozos.

Arquitectura de UDP

UDP se implanta en los host. UDP no promete ni garantizar la entrega y es responsabilidad de las aplicaciones que intercambian la información que confirme si los datos han llegado correctamente.

Una aplicación que quiere enviar datos con UDP traslada un bloque de datos a UDP. UDP simplemente añade una cabecera a dicho bloque y lo transmite. Una aplicación que participa en una comunicación de UDP puede enviar y recibir mensajes y datagramas de usuario en cualquier momento. Es responsabilidad de los clientes y de los servidores que utilizan UDP mantener un registro de cualquier relación entre los datagramas de usuario intercambiados.

CONCEPTOS DE SEGURIDAD

AUTENTIFICACIÓN

TCP/IP se comporta muy bien en el establecimiento de comunicaciones entre computadoras de una LAN, a través de una red de puntos o incluso globalmente. Pero la conectividad alcanza un nuevo interés en cuanto a la seguridad de la información.

Los temas básicos de seguridad en un entorno de red son los mismos que se encuentran en un host central.

-

Autentificación de los usuarios.

-

Integridad, es decir, asegurar que los datos no han cambiado.

-

Confidencialidad, es decir, evitar que nadie pueda observar la información.

Autentificación

Un aspecto importante de la seguridad de las computadoras es saber quien es quien. En el pasado se confiaba en los identificadores de usuario (ID) y en las contraseñas para identificar a los usuarios interactivos. Se confiaba en el campo “From:” de un mensaje de correo para identificar al emisor. Pero las contraseñas se pueden capturar mediante una escucha silenciosa y el correo electrónico se puede falsificar.

Si se van a realizar transacciones serias sobre redes de TCP/IP, se necesita algún mecanismo para identificar de forma fiable al emisor. La identificación fiable de un emisor se autentificación.

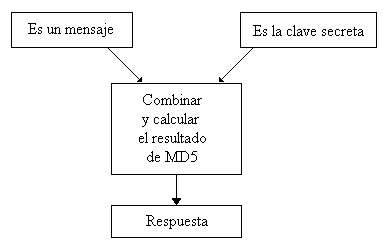

Uso de la clasificación de mensajes.

Una tecnología de autentificación sencilla, pero eficaz, utiliza clasificación de mensajes (message digest). Una clasificación de mensajes es el cálculo que se realiza con un mensaje usando clave secreta. La clasificación de mensajes 5 (MD5) se usa mucho actualmente.

El Challenge Handshake muestra una forma de uso de la clasificación de mensajes. Como ocurre en la autentificación convencional, un usuario da su contraseña registrada en un host. Sin embargo, la contraseña no se envía nunca por la red. En lugar de ello el sistema del usuario realiza un calculo MD5 utilizando la contraseña como clave secreta.

El usuario envía un identificador de usuario al host.

El host envía un mensaje aleatorio al usuario.

El host y el sistema del usuario realizan un cálculo MD5 del mensaje aleatorio y la contraseña secreta del usuario.

El sistema del usuario envía la respuesta al host.

El host compara las respuestas. Si el sistema del usuario envía la respuesta correcta, se autentifica al usuario.

También se pueden usar MD5 y una clave secreta para detectar si han cambiado los datos durante la transmisión.

Se realiza un calculo MD5 con los datos y la clave secreta.

Se envía al otro extremo los datos y mensaje clasificado.

El otro extremo realiza un calculo MD5 de los datos y la clave secreta.

El otro extremo compara la respuesta con el mensaje clasificado. Si coinciden, significa que los datos no han cambiado.

Para evitar que un intruso lea y utilicen los datos, estos deben ir cifrados. La manera clásica de hacerlo es que el emisor y el receptor estén de acuerdo en la clave secreta. Los datos se cifran antes de enviarse usando esta clave. A menudo se añade una clasificación de mensaje de manera que el receptor pueda comprobar que el mensaje recibido se corresponde exactamente con el emitido.

Este es el método tradicional de cifrado simétrico. El cifrado simétrico usa la misma clave para cifrar y para descifrar los datos. Los dos usuarios deben conocer y guardar la clave secreta. Las desventajas son:

-

Por seguridad, se necesita clave distinta para cada par de entidades que se comunican.

-

Es difícil actualizar las claves.

Ataques de autentificación

Consisten en la suplantación de una persona con autorización por parte del atacante. Se suele realizar de dos formas: obteniendo el nombre y contraseña del atacado o suplantando a la víctima una vez ésta ya ha iniciado una sesión en su sistema. Para realizar ataques de este tipo se utilizan varias técnicas:

-

Simulación de identidad: Es una técnica para hacerse con el nombre y contraseña de usuarios autorizados de un sistema. El atacante instala un programa que recrea la pantalla de entrada al sistema, cuando el usuario intenta entrar en él teclea su login y password, el programa los captura y muestra una pantalla de “error en el acceso” al usuario. El usuario vuelve a teclear su login y password, entrando esta vez sin problemas. El usuario cree que en el primer intento se equivocó al teclear, sin embargo, su login y password han sido capturados por el atacante.

-

Looping: El intruso usualmente utiliza algún sistema para obtener información e ingresar en otro, que luego utiliza para entrar en otro, y así sucesivamente. Este proceso se llama looping y tiene como finalidad hacer imposible localizar la identificación y la ubicación del atacante, de perderse por la red.

Entre el origen físico y el sistema que finalmente se utilice para realizar una fechoría puede estar plagado de muchos sistemas intermedios, rebasando las fronteras de varios países, dificultando aún más su localización.

-

Spoofing (engaño): Este tipo de ataques (sobre protocolos) suele implicar un buen conocimiento del protocolo en el que se va a basar el ataque. Consiste en sustituir la fuente de origen de una serie de datos (por ejemplo, un usuario) adoptando una identidad falsa para engañar a un firewall o filtro de red. Los ataques Spoofing más conocidos son el IP Spoofing, el Web Spoofing y el fake-mail.

-IP Spoofing: Consiste en sustituir una IP. El atacante logra identificarse con una IP que no es la suya, con lo que a ojos del atacado, el agresor es una tercera persona, que nada tiene que ver en el asunto, en vez de ser el atacante real.

-Web Spoofing: El atacante crea un sitio Web (falso) similar al que la víctima desea entrar. Los accesos a este sitio están dirigidos por el atacante, permitiéndole monitorizar todas las acciones de la víctima: datos, contraseñas, números de tarjeta de créditos, etc. El atacante también es capaz de modificar cualquier dato que se esté transmitiendo entre el servidor original y la víctima o viceversa.

-Fake-mail: Es otra forma de Spoofing y consiste en el envío de e-mails con remitente falso. Aquí el atacante envía E-Mails en nombre de otra persona con cualquier motivo y objetivo. Muchos de estos ataques se inician utilizando la Ingeniería Social para hacerse con el nombre y contraseña de una víctima.

-

Utilización de Backdoors (puertas traseras): Las puertas traseras son trozos de código en un programa que permiten a quien los conocen saltarse los métodos usuales de autentificación para realizar ciertas tareas. Habitualmente son insertados por los programadores del sistema para agilizar la tarea de probar código durante la fase de desarrollo. No es por tanto un método de suplantación, si no de saltarse los controles de autentificación o, como su nombre indica, entrar por la “puerta de atrás”.

Son fallas de seguridad que se mantienen, voluntariamente o no, una vez terminado el producto ya que cualquiera que conozca el agujero o lo encuentre en su código podrá saltarse los mecanismos de control normales.

GESTIÓN DE CLAVES

IPsec no especifica un sistema automático de gestión de claves de cifrado concreto. Para cumplir con normas, una implementación IPsec ha de soportar:

-

Claves compartidas previamente

-

Internet Key Exchange (IKE, RFC 2401)

Conceptos previos:

- ISAKMP (Internet Security Association and Key Management Protocol )

Es un marco conceptual para la autenticación y el intercambio de claves. Define formatos de datos, la mecánica del protocolo de intercambio de claves y la negociación de una SA , ademas es independiente de cualquier tecnología de claves. Incluye protocolos como OAKLEY e IKE (en diferentes partes del marco).

- OAKLEY

Es un protocolo que establece una clave compartida de forma segura entre dos partes. Usa intercambio de claves Diffie-Hellman. Encaja en el marco propuesto por ISAKMP para establecer asociaciones de seguridad (SA) IPsec. El protocolo establece una SA ISAKMP y una vez esta está establecida, mecanismos más ligeros para establecer más SAs. RFC 2412

- IKE (Internet Key Exchange)

Es un diseño específico dentro del marco ISAKMP. Se apoya también en OAKLEY (claves seguras). Tiene dos fases:

-

Fase 1: Establecimiento de un canal cifrado y autenticado (SA). Usa Diffie-Hellman.

-

Los resultados de la fase 1 (para cada extremo):

-

Identidad de la otra parte

-

Prueba de validez de esa identidad

-

Clave adecuada para AH y ESP, obtenida con seguridad

-

Fase 2: Establecimiento de una o más SAs de aplicación

- Complemento: creación de un certificado con openssl

-

>Creación de clave (pública y privada) y mensaje de petición de certificado: openssl req -new > new.cert.csr

-

>Eliminación de fase de descifrado: openssl rsa -in privkey.pem -out new.cert.key

-

>Creación de certificado fimado: openssl x509 -in new.cert.csr -out new.cert.cert \-req -signkey new.cert.key -days 365

-

>Vista del certificado en formato legible: openssl x509 -in new.cert.cert -text

(Proceso descrito en la FAQ de Apache-SSL)

El intercambio de claves

El intercambio de claves puede realizarse mediante dos mecanismos de administración:

-

manual

-

automatico

-

Manual

En ambientes pequeños se puede usar el método manual, donde el usuario configura manualmente cada sistema con su propia clave así como con las claves de otros sistemas. Se pueden usar claves para cada enrutador, o para el firewall que conecta un sistema a Internet en cuyo caso se puede seleccionar qué tráfico encriptar y cuál no.

-

Automático

ð SKIP o Administración Simple de Claves para Protocolos Internet: Realiza la distribución de claves a nivel de paquetes soportando una transferencia segura en base al sistema de dos claves de Diffie-Hellman.

ð ISAKMP (Asociación de Seguridad Internet y Protocolo de Administración de Claves) combinada con Oakley fue elegida como norma para IPv6 y opcional para IPv4.

ISAKMP no establece las claves de una sesión, tarea que en este caso asume Oakley al permitir diferentes métodos de autenticación incluyendo variantes con desconocimiento (repudio) o no desconocimiento (no repudio) de la recepción de un mensaje, así como la negociación de los atributos de la SA. La flexibilidad en los métodos de autenticación facilita no sólo el establecimiento de VPNs (Redes Privadas Virtuales) sino incluso el acceso a la red de una empresa por parte de trabajadores a domicilio.

Hoy en día la norma ha sido renombrada como IKE o Intercambio de Claves Internet. En IKE, en realidad, al par ISAKMP/Oakley se incorpora un técnica conocida como SKEME para un intercambio más versátil de las claves.

Una vez que un host reconoce la identidad del otro y viceversa, los intercambios de información bajo IKE se realizan por medio de mensajes.

En las operaciones con IKE los host generan un valor que los identifica: un cookie. Los cookies tienen una extensión de 8 bytes. Un cookie así formado no sólo identifica un host sino que permite identificar y rechazar mensajes inválidos sin necesidad de recurrir al encriptado con la consiguiente carga de ciclos de máquina.

El intercambio de claves provisto por IKE se realiza en dos fases. La fase 1 puede verse como la generación de una clave maestra y subsidiarias, mientras que en la fase 2 se derivan de las anteriores las claves que se usarán para la transferencia de datos.

Claves provistas por IKE

(Internet Key Exchange. RFC 2409 o tambien llamado ISAKMP/Oakley)

IKE es un protocolo de dos fases para el establecimiento de un canal auténtico y seguro entre dos usuarios (Peers). Este protocolo utiliza la infraestructura de mensajes del protocolo ISAKMP para el intercambio de mensajes.

Permite VPN entre servidores y clientes para compartir información cifrada. Las máquinas debe de estar de acuerdo en cómo van a intercambiar y securizar la información mediante la formación de SA (Security Association) antes de que el intercambio tenga lugar. Las máquinas deben de estar de acuerdo de cómo van a cifrar y descifrar los datos enviados.

Para hacer esto, usamos una combinación del protocolo ISAKMP y el protocolo de generación de claves. El protocolo ISAKMP es el gestor centralizado de la SA entre el cliente y servidor, mientras que el protocolo Oakley genera y gestiona las claves de cifrado utilizadas para securizar la información.

El proceso ISAKMP/Oakley es llevado a cabo en dos fases. Cada fase utiliza los esquemas de cifrado y autenticación acordados durante el proceso inicial de negociación.

Operativamente la fase 1 puede verse como la generación de una clave maestra y subsidiarias, mientras que en la fase 2 se derivan de las anteriores las claves que se usarán para la transferencia de datos.

Fase 1:

En esta fase se establece el intercambio de claves autenticadas. Hay cuatro métodos diferentes de autenticación: firma digital, dos variantes con encriptado de clave pública y clave precompartida.

Las diferencias aparecen en la determinación de la clave maestra.

A) Firma Digital: trabaja bajo el algoritmo de combinación Diffie-Hellman en forma similar al sistema de claves públicas, aunque son los propios hosts los que generan sus propias claves (pública y privada). Se basa en el valor secreto compartido de Diffie-Hellman aplicado a la concatenación de números aleatorios generados por ambas partes que se usan una única vez y se conocen como nonces o ad-hoc.

El algoritmo Diffie-Hellman

En 1976 W. Diffie y M.E. Hellman encontraron un algoritmo de intercambio de claves de forma segura. Para ello es necesario encontrar un sistema de cifrado computacionalmente fácil de forma que el descifrado sea computacionalmente difícil, a menos que se disponga de la clave.

Algoritmo de ejemplo

Paso 1: El usuario A elige una clave pública Apub y el usuario B elige una clave pública Bpub.

Paso 2: El usuario A elige una clave privada Apriv y el usuario B elige una clave privada Bpriv.

Paso 3: A partir de las claves públicas el usuario A calcula Atx=(Bpub^Apriv) % Apub y se lo envía a B, mientras que B calcula Btx=(Bpub^Bpriv) % APub y se lo envía a A.

Paso 4: Finalmente los usuarios A y B pueden calcular una clave conocida por ambos.

Aclave = (Btx^Apriv) % Apub

Bclave = (Atx^Bpriv) % Apub

donde CA = CB = C.

Ejemplo práctico

Supongamos un usuario A con clave pública Apub=7 y clave privada Apriv=9, y un usuario B con clave pública Bpub=5 y clave privada Bpriv=11.

El usuario A calcula Atx=(Bpub^Apriv) % Apub = 5^9 % 7 = 6 y lo envía al usuario B.

El usuario B calcula Btx=(Bpub^Bpriv) % APub = 5^11 % 7 = 3 y lo envía al usuario A.

Los usuarios A y B calculan la clave:

- Aclave = (Btx^Apriv) % Apub = 3^9 % 7 = 6

- Bclave = (Atx^Bpriv) % Apub = 6^11 % 7 = 6

(Negociación ISAKMP SA).

En esta fase uno, las parejas negocian la Security Association que será usada para cifrar y autenticar en la fase dos. Fase uno implica una gran carga de trabajo o CPU del sistema, por lo tanto se ejecuta infrecuentemente (se suele establecer la SA, y no se vuelve a renovar hasta que ésta se haya roto o desaparecido por time-out). La negociación de SA incluye el método de cifrado, de autenticación y claves. Así ésta SA es utilizada en la negociación de fase 2. La fase primera es usada para proteger la identidad de dos máquinas conectadas.

1. El primer paso en la fase uno consiste en la negociación de los cuatro parámetros constituyentes de una SA.

a. Algoritmo de cifrado: DES, 3DES, AES, CAST

b. Algoritmo hash: MD5 ó SHA1.

c. Método de autenticación (RADIUS, LDAP, Tacacs+)

d. Grupo de Diffie-Hellman.

2. El segundo paso es el intercambio de clave pública de Diffie-Hellman.

Aquí, la información básica necesaria para generar la clave secreta compartida es intercambiada, entonces el servicio Oakley genera la clave maestra en cada máquina utilizada para el paso de autenticación.

3. Las máquinas intentan autenticar el intercambio de Diffie-Hellman. La clave maestra es utilizada para autenticar la identidad de las máquinas. La información de identidad es “hasheada” y cifrada para protegerla, usando las claves generadas del intercambio de Diffie-Hellman.

4. Si la autenticación ocurre, entonces iniciamos la fase dos.

Podemos encontrar dos modos de fase uno:

-

Modo agresivo, se intercambian tres paquetes

-

Main mode, 6 paquetes son intercambiados.

B) Encriptado de Clave Pública: Se basa en la aplicación de una función hash a la concatenación de ambos nonces con la concatenación de ambos cookies.

C) Claves Precompartidas: Aplica la clave precompartida a la concatenación de los nonces.

La autenticación con firma digital se basa en que el intercambio se autentica firmando un hash que ambos hosts pueden obtener.

Gracias al encriptado la autenticación con encriptado de claves públicas ofrece una notable ventaja respecto de la autenticación con firma digital. Esto no es sólo por la doble barrera interpuesta a un hacker (intercambio Diffie-Hellman y encriptado) sino también porque cada host puede reconstruir en forma independiente cada lado del intercambio.

Sin embargo, el encriptado tradicional con claves públicas agrega un considerable overhead ya que hay que realizar dos operaciones de encriptado con una clave pública y otras dos de desencriptado de una clave privada.

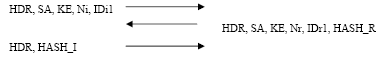

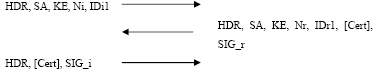

A continuación se muestran unos diagramas de cada metodo de autentificación:

1. Autenticación con claves pre-compartidas (Pre-shared Keys).

Emisor Receptor

2. Autenticación mediante firmas digitales (Digital Signatures).

Emisor Receptor

3. Autenticación mediante clave pública 1.

Emisor Receptor

4. Autenticación mediante clave pública 2.

Emisor Receptor

- HDR: Cabecera ISAKMP.

- HDR*: Cabecera cifrada

- HASH: Función Hash.

- KE: Valor público Diffie-Hellman.

- SA: Asociación de seguridad.

- Ni y Nr: Valor temporal (Nonce payload).

- [Cert] y SIG: Certificado y firma digital.

- ID: Identificador.

- PubK: Clave pública.

- [ ] : Opcional.

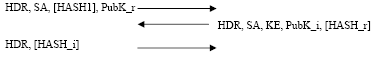

Fase 2:

Esta fase define las SAs y las claves del IPSec. (Negociación IPSEC SA) Una vez establecidos los distintos parámetros iniciales (SA) y aprovechando la seguridad de la fase 1, se inicia un modo rápido (Quick Mode) dónde se vuelven a negociar asociaciones de seguridad (SA) con el objetivo de evitar ataques de reutilización (Replay) de los datagramas de la fase 1 por un atacante.

Emisor Receptor

La SA negociada en fase 1 es usada por las parejas para negociar una SA para cifrar el tráfico IPSEC. Las claves pueden ser modificadas tantas veces como sean necesarias durante el tiempo que dure la conexión realizándose la fase dos. La fase dos proporciona protección adicional refrescando las claves para asegurar la fiabilidad de las SAs y prevenir ataques man-in-the-middle.

1. El primer paso en fase dos es la negociación de la política

a. Protocolo IPSEC: ESP, AH, ESP+AH

b. El algoritmo hash: MD5 ó SHA1

Cuando las dos máquinas han llegado a un acuerdo, dos SAs se establecen, una para comunicaciones entrantes y otras para comunicaciones salientes.

2. Oakley refresca las claves, y una nueva clave secreta o compartida es generada para autenticar y cifrar.

3. Las SAs y claves son transferidas mediante el protocolo IPSEC y la comunicación se realiza.

Si por alguna causa la SA desaparece (un corte de línea, timeout) ésta volverá a generarse de nuevo. Muchas veces, por motivos de seguridad, se hace una regeneración de la SA, para avitar que un intruso pueda apoderarse de datos sensibles.

Resumen:

Esta combinación de algoritmos permite mantener una comunicación auténtica y privada entre dos usuarios (Peers), el problema principal radica en su complejidad, ya que pese a ser muy flexible (permite distintos métodos de autenticación y utilización de firmas digitales) es difícil su implementación práctica.

Además deja sin resolver el problema de comunicaciones seguras entre varios usuarios, ya que realizar este algoritmo entre todos ellos resulta en un alto coste de intercambio de datagramas. De esta forma para grupos (multicast o anycast) se debe utilizar un esquema dónde un servidor de claves (que debemos suponer seguro) sincroniza la clave común a todos los componentes del grupo.

Se utiliza un protocolo de dos fases para el intercambio de claves denominado IKE, que aprovechando la infraestructura de intercambio de mensajes del protocolo ISAKMP proporciona un canal autentico y seguro entre dos usuarios cualesquiera conectados a INTERNET.

EJEMPLO EN WINDOWS 2000:

IPSEC de Windows 2000 utiliza los siguientes protocolos de seguridad:

-

Protocolo de administración de claves y asociación de seguridad Internet

-

Protocolo de generación de claves Oakley

-

Encabezado de autentificación

-

Carga de seguridad de encapsulacion

El protocolo de administración de claves y asociación de seguridad Internet

Antes de trasmitir paquetes IP de un equipo a otro, se ha de definir una asociación de seguridad entre las dos partes que utilizan IPsec. ISAKMP define como establecer SA.

Oakley

Es un protocolo de generación de claves que implementa el calculo DH del intercambio de claves. Oakley permite confidencialidad directa perfecta (PFS) y de este modo asegura la protección de datos aunque una sola clave sea violada (permite acceso solo a los datos de esta clave). La clave nunca se utiliza para calcular claves adicionales.

El encabezado de autentificación

AH proporciona autentificación, integridad y anti-repetición para el paquete entero (ambos el encabezado de IP y la información incluida en el paquete), AH firma el paquete entero. AH utiliza algoritmo HMAC para firmar el paquete.

Carga de seguridad de encapsulacion (ESP)

La carga de seguridad de encapsulacion (ESP) proporciona confidencialidad utilizando el algoritmo DES-CBC.

ISAKMP centraliza la administración de asociación de seguridad, reduciendo el tiempo de conexión. Oakley genera y administra las claves autentificadas para asegurar la información. Para asegurar una comunicación segura y con éxito, ISAKMP/Oakley realiza una operación de dos fases:

-

Intercambio de clave

-

Proteccion de la información

Intercambio de clave

Durante la fase incivil, los dos equipos establecen la primera SA, denominada ISAKMP SA. Oakley proporciona protección de identidad durante este intercambio, permitiendo una discreción absoluta. Asi, se ayuda a evitar los tipos de ataque de red mas comunes que se centran en las identidades intrusas.

El proceso de negociación de seguridad durante esta fase comprende:

1.- El algoritmo de cifrado: DES, 3DES, 40bitDES o ninguno.

-

El algoritmo de integridad: MD% o SHA.

-

El metodo de autentificación: el certificado con la clave publica, la clave compartida previamente o Kerberos V5(predeterminado para Windows 2000).

-

El grupo Diffie-Hellman-

2.- Intercambio de información clave tiene como resultado que cada equipo disponga de la información necesaria para generar la clave compartida secreta (clave principal) para la ISAKMP SA.

3.- Autentificación. Los equipos que intentan autenticar el intercambio de información clave. Si se produce un error en la autentificación, no se podra proceder con la comunicaron. Se utiliza la clave principal, junto con los algoritmos negociados en el Paso 1. Independientemente del metodod de autentificación utilizado, la carga de identidad esta protegida contra las modificacion e interpretación.

El interlocutor inicial envia una lista de niveles de seguridad en potencia a los interlocutores de respuesta. El interlocutor de respuesta no puede modificar la oferta, en todo caso, el interlocutor inicial rechazara el mensaje del interlocutor que responde. Luego el interlocutor de respuesta envia un mensaje que acepta o rechaza la oferta y envia un mensaje que indica que no se ha elegido ninguna oferta, y el proceso comienza de nuevo.

Proteccion de la información

Los mensajes de negociación que se intercambian, se vuelven a enviar de manera automatica 5 veces. Después de 3 segundos, se establece un SA Transferible, si las directivas activas permiten establecer comunicaciones inseguras en los equipos sin IPSec. Si se recibe una respuesta, ISAKMP antes de finalizar el ciclo, se elimina la SA transferible y se inicia la negociación de la SA estándar. El proceso de reintento de mensaje automatico es casi identico al proceso descrito en la negociación del intercambio clave, con una excepcion: si este proceso llega a finalizar por cualquier razon durante la segunda o mas importante negociación de la misma ISAKMP SA, se intenta una nueva negociación de ISAKMP SA. Si se recibe un mensaje durante la fase de proteccion de la información sin establecer ISAKMP SA, se rechaza.

PROTOCOLOS

Como ya hemos mencionado con anterioridad, a finales de los años setenta, el Departamento de Defensa de los Estados Unidos creó la red ARPANET para poder investigar la comunicación de paquetes. En 1982 se especificó un nuevo conjunto de protocolos para ARPANET, que fue denominado TCP/IP. Actualmente TCP/IP se considera el conjunto de protocolos abiertos, no específicos de un fabricante determinado, soportado por la mayoría de los fabricantes en los sistemas operativos más extendidos.

En este apartado vamos a realizar un estudio sobre dos aspectos de la seguridad IP:

-

Los protocolos que forman parte de la familia TCP/IP que permiten la comunicación entre cualquier red o fabricante, denominada internet.

-

El estándar de seguridad IP, que recibe el nombre de IPSec.

PROTOCOLOS:

DESCRIPCIÓN GENERAL DE LOS PROTOCOLOS TCP/IP

Para una primera aproximación mostramos el modelo general de los protocolos TCP/IP con algunas de las aplicaciones normalizadas que las utiliza:

| NFS |

| Enviado por: | El remitente no desea revelar su nombre |

| Idioma: | castellano |

| País: | España |