Tecnología

Los inventos de la historia

Imprenta, nombre utilizado para designar diferentes procesos para reproducir palabras, imágenes o dibujos sobre papel, tejido, metal y otros materiales. Estos procesos, que a veces reciben el nombre de artes gráficas, consisten en esencia en obtener muchas reproducciones idénticas de un original por medios mecánicos, por lo que el libro impreso ha sido bautizado como el primer producto en serie.

La historia de la imprenta, que por su propia naturaleza es la mejor documentada de todas las historias, es prácticamente idéntica a la de la impresión en relieve, o impresión tipográfica (impresión desde una superficie elevada). Históricamente, la mayor parte de la obra impresa se ha producido con este método totalmente mecánico. Sin embargo, las técnicas de impresión modernas cada vez se basan más en los procesos de tipo fotomecánico y químico.

Técnicas antiguas

La utilización de las piedras para sellar quizá sea la forma más antigua conocida de impresión. De uso común en la antigüedad en Babilonia y otros muchos pueblos, como sustituto de la firma y como símbolo religioso, los artefactos estaban formados por sellos y tampones para imprimir sobre arcilla, o por piedras con dibujos tallados o grabados en la superficie. La piedra, engastada a menudo en un anillo, se coloreaba con pigmento o barro y se prensaba contra una superficie elástica y dúctil a fin de conseguir su impresión.

La evolución de la imprenta desde el método sencillo del tampón hasta el proceso de imprimir en prensa parece que se produjo de forma independiente en diferentes épocas y en distintos lugares del mundo. Los libros que se copiaban a mano con tinta aplicada con pluma o pincel constituyen una característica notable de las civilizaciones egipcia, griega y romana. Estos manuscritos también se confeccionaban en los monasterios medievales y tenían gran valor. En la antigua Roma, los editores de libros comerciales lanzaron ediciones de hasta 5.000 ejemplares de ciertos manuscritos coloreados, como los epigramas del poeta romano Marcial. Las tareas de copia corrían a cargo de esclavos ilustrados.

Impresión en Oriente

Ya en el siglo II d.C. los chinos habían desarrollado e implantado con carácter general el arte de imprimir textos. Igual que con muchos inventos, no era del todo novedoso, ya que la impresión de dibujos e imágenes sobre tejidos le sacaba al menos un siglo de ventaja en China a la impresión de palabras.

Dos factores importantes que influyeron favorablemente en el desarrollo de la imprenta en China fueron la invención del papel en 105 d.C. y la difusión de la religión budista en China. Los materiales de escritura comunes del antiguo mundo occidental, el papiro y el pergamino, no resultaban apropiados para imprimir. El papiro era demasiado frágil como superficie de impresión y el pergamino, un tejido fino extraído de la piel de animales recién desollados, resultaba un material caro. El papel, por el contrario, es bastante resistente y económico. La práctica budista de confeccionar copias de las oraciones y los textos sagrados favorecieron los métodos mecánicos de reproducción.

Los primeros ejemplos conocidos de impresión china, producidos antes de 200 d.C., se obtuvieron a base de letras e imágenes talladas en relieve en bloques de madera. En 972 se imprimieron de esta forma los Tripitaka, los escritos sagrados budistas que constan de más de 130.000 páginas. Un inventor chino de esta época pasó de los bloques de madera al concepto de la impresión mediante tipos móviles, es decir, caracteres sueltos dispuestos en fila, igual que en las técnicas actuales. Sin embargo, dado que el idioma chino exige entre 2.000 y 40.000 caracteres diferentes, los antiguos chinos no consideraron útil dicha técnica, y abandonaron el invento. Los tipos móviles, fundidos en moldes, fueron inventados independientemente por los coreanos en el siglo XIV, pero también los consideraron menos útiles que la impresión tradicional a base de bloques.

Impresión en Occidente

La primera fundición de tipos móviles de metal se realizó en Europa hacia mediados del siglo XV; se imprimía sobre papel con una prensa. El invento no parece guardar relación alguna con otros anteriores del Extremo Oriente: ambas técnicas se diferencian mucho en cuanto a los detalles. Mientras que los impresores orientales utilizaban tintas solubles en agua, los occidentales emplearon desde un principio tintas diluidas en aceites. En Oriente, las impresiones se conseguían sencillamente oprimiendo el papel con un trozo de madera contra el bloque entintado. Los primeros impresores occidentales en el valle del Rin utilizaban prensas mecánicas de madera cuyo diseño recordaba el de las prensas de vino. Los impresores orientales que utilizaron tipos móviles los mantenían unidos con barro o con varillas a través de los tipos.

Los impresores occidentales desarrollaron una técnica de fundición de tipos de tal precisión que se mantenían unidos por simple presión aplicada a los extremos del soporte de la página. Con este sistema, cualquier letra que sobresaliera una fracción de milímetro sobre las demás, podía hacer que las letras de su alrededor quedaran sin imprimir. El desarrollo de un método que permitiera fundir letras con dimensiones precisas constituye la contribución principal del invento occidental.

Los fundamentos de la imprenta ya habían sido utilizados por los artesanos textiles europeos para estampar los tejidos, al menos un siglo antes de que se inventase la impresión sobre papel. El arte de la fabricación de papel, que llegó a Occidente durante el siglo XII, se extendió por toda Europa durante los siglos XIII y XIV. Hacia mediados del siglo XV, ya existía papel en grandes cantidades. Durante el renacimiento, el auge de una clase media próspera e ilustrada aumentó la demanda de materiales escritos. La figura de Martín Lutero y de la Reforma, así como las subsiguientes guerras religiosas, dependían en gran medida de la prensa y del flujo continuo de impresos.

Johann Gutenberg, natural de Maguncia (Alemania), está considerado tradicionalmente como el inventor de la imprenta en Occidente. La fecha de dicho invento es el año 1450. Ciertos historiadores holandeses y franceses han atribuido este invento a paisanos suyos, aduciendo abundantes pruebas. Sin embargo, los libros del primer impresor de Maguncia, y en concreto el ejemplar conocido como la Biblia de Gutenberg, sobrepasa con mucho en belleza y maestría a todos los libros que supuestamente le precedieron. El gran logro de Gutenberg contribuyó sin duda de forma decisiva a la aceptación inmediata del libro impreso como sustituto del libro manuscrito. Los libros impresos antes de 1501 se dice que pertenecen a la era de los incunables.

En el periodo comprendido entre 1450 y 1500 se imprimieron más de 6.000 obras diferentes. El número de imprentas aumentó rápidamente durante esos años. En Italia, por ejemplo, la primera imprenta se fundó en Venecia en 1469, y hacia 1500 la ciudad contaba ya con 417 imprentas. En 1476 se imprimió un gramática griega con tipografía totalmente griega en Milán y en Soncino se imprimió una biblia hebrea en 1488. En 1476 William Caxton llevó la imprenta a Inglaterra; en España, Arnaldo de Brocar compuso la Biblia Políglota Complutense en seis tomos entre 1514 y 1517 por iniciativa del Cardenal Cisneros; en 1539 Juan Pablos fundó una imprenta en la Ciudad de México, introduciendo esta técnica en el Nuevo Mundo. Stephen Day, un cerrajero de profesión, llegó a la Bahía de Massachusetts en Nueva Inglaterra en 1628 y colaboró en la fundación de Cambridge Press.

Los impresores del norte de Europa fabricaban sobre todo libros religiosos, como biblias, salterios y misales. Los impresores italianos, en cambio, componían sobre todo libros profanos, por ejemplo, los autores clásicos griegos y romanos redescubiertos recientemente, las historias de los escritores laicos italianos y las obras científicas de los eruditos renacentistas. Una de las primeras aplicaciones importantes de la imprenta fue la publicación de panfletos: en las luchas religiosas y políticas de los siglos XVI y XVII, los panfletos circularon de manera profusa. La producción de estos materiales ocupaba en gran medida a los impresores de la época. Los panfletos tuvieron también una gran difusión en las colonias españolas de América en la segunda mitad del siglo XVIII.

Prensas de imprimir

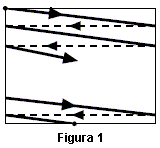

La máquina que se utiliza para transferir la tinta desde la plancha de impresión a la página impresa se denomina prensa. Las primeras prensas de imprimir, como las del siglo XVI e incluso anteriores, eran de tornillo, pensadas para transmitir una cierta presión al elemento impresor o molde, que se colocaba hacia arriba sobre una superficie plana. El papel, por lo general humedecido, se presionaba contra los tipos con ayuda de la superficie móvil o platina. Las partes superiores de la imprenta frecuentemente iban sujetas al techo y una vez que el molde se había entintado, la platina se iba atornillando hacia abajo contra el mismo. La prensa iba equipada con raíles que permitían expulsar el molde, volviendo a su posición original, de modo que no fuera necesario levantar mucho la platina. Sin embargo, la operación resultaba lenta y trabajosa; estas prensas sólo producían unas 250 impresiones a la hora, y sólo imprimían una cara cada vez.

En el siglo XVII se añadieron muelles a la prensa para ayudar a levantar rápidamente la platina. Hacia 1800 hicieron su aparición las prensas de hierro, y por aquellas mismas fechas se sustituyeron los tornillos por palancas para hacer descender la platina. Las palancas eran bastante complicadas; primero tenían que hacer bajar la platina lo máximo posible, y al final tenían que conseguir el contacto aplicando una presión considerable. Aunque las mejores prensas manuales de la época sólo producían unas 300 impresiones a la hora, las prensas de hierro permitían utilizar moldes mucho más grandes que los de madera, por lo que de cada impresión se podía obtener un número mucho mayor de páginas. La impresión de libros utilizaba cuatro, ocho, dieciséis y más páginas por pliego.

Durante el siglo XIX, las mejoras incluyeron el desarrollo de la prensa accionada por vapor; la prensa de cilindro, que utiliza un rodillo giratorio para prensar el papel contra una superficie plana; la rotativa, en la que tanto el papel como la plancha curva de impresión van montados sobre rodillos y la prensa de doble impresión, que imprime simultáneamente por ambas caras del papel. Los periódicos diarios de gran tirada exigen utilizar varias de estas prensas tirando al mismo tiempo el mismo producto. En 1863 el inventor norteamericano William A. Bullock patentó la primera prensa de periódicos alimentada por bobina, capaz de imprimir los periódicos en rollos en vez de hojas sueltas. En 1871 el impresor Richard March Hoe perfeccionó la prensa de papel continuo; su equipo producía 18.000 periódicos a la hora.

Ilustración de libros

Durante siglos, los dibujantes trabajaban en libros ilustrados a mano; con la llegada de la imprenta, los artistas grababan sus creaciones en madera o metal, lo cual permitía a los impresores renacentistas reproducir en sus imprentas tanto imágenes como textos. Entre los artistas famosos del renacimiento que produjeron ilustraciones para libros se hallan el italiano Andrea Mantegna y los alemanes Alberto Durero y Hans Holbein el Joven. La amplia reproducción de sus trabajos influyó de manera notable el desarrollo del arte renacentista.

Tipos, prensas de acero y máquinas tipográficas

Hasta el siglo XIX se habían ido creando algunas tipografías de gran belleza y se había perfeccionado el oficio de la imprenta. Hacia 1800, sin embargo, los avances en el mundo de la impresión hicieron hincapié en aumentar la velocidad. Charles, tercer conde de Stanhope, introdujo la primera prensa de imprimir construida totalmente de acero. En 1803, los hermanos Henry y Sealy Fourdrinier instalaron en Londres su primera máquina de fabricar papel; producía una bobina de papel continuo capaz de hacer frente a una demanda en constante crecimiento. Más tarde, en 1814 Friedrich König inventó la prensa accionada por vapor, revolucionando toda la industria de la impresión. En 1817, Fco. Xavier Mina, liberal español que organizó una expedición para apoyar la lucha de los patriotas mexicanos por su independencia, llevó a México la primera imprenta de acero, en la que imprimió sus periódicos y proclamas. Se considera la primera imprenta que hubo en el estado de Texas, entonces territorio de Nueva España. En la actualidad se encuentra en el Museo del Estado.

Las grandes ediciones que publicaban aumentaron aún más en 1829 al aparecer los estereotipos, que permiten fabricar duplicados de planchas de impresión ya compuestas. En 1886 los equipos de composición se perfeccionaron, permitiendo reducir drásticamente el tiempo necesario para componer un libro en comparación con las labores manuales. Por último, la fotografía ha venido a contribuir al desarrollo de los modernos procesos de fotomecánica.

En la década de los cincuenta aparecieron las primeras máquinas de fotocomposición, que producían imágenes fotográficas de los tipos en vez de fundirlos en plomo. Estas imágenes se fotografían con una cámara de artes gráficas a fin de producir unos negativos en película que sirven para obtener las planchas litográficas. Los avances en la tecnología de planchas en los años cincuenta y sesenta, junto con la fotocomposición, pusieron fin a un reinado de 500 años de la tipografía como principal proceso de impresión. La composición tipográfica con tipos de fundición prácticamente ha desaparecido, pero el huecograbado sigue utilizándose de forma habitual. La mayoría de las planchas en relieve se fabrican en la actualidad por procesos fotomecánicos directos.

Los ordenadores o computadoras que se utilizan hoy como máquinas de oficina pueden producir imágenes listas para impresión, reduciendo el tiempo y los costes de los principales procesos de imprenta. Las computadoras se utilizan de forma habitual para crear dibujos, definir tipos, digitalizar y retocar imágenes y fundir todos estos elementos en un único trozo de película o directamente sobre la plancha de imprimir.

Teléfono, instrumento de comunicación, diseñado para la transmisión de voz y demás sonidos hasta lugares remotos mediante la electricidad, así como para su reproducción. El teléfono contiene un diafragma que vibra al recibir el impacto de ondas de sonido. Las vibraciones (movimiento ondulatorio) se transforman en impulsos eléctricos y se transmiten a un receptor que los vuelve a convertir en sonido.

En el lenguaje coloquial, la palabra `teléfono' también designa todo el sistema al que va conectado un aparato de teléfono; un sistema que permite enviar no sólo voz, sino también datos, imágenes o cualquier otro tipo de información que pueda codificarse y convertirse en energía eléctrica. Esta información viaja entre los distintos puntos conectados a la red. La red telefónica se compone de todas las vías de transmisión entre los equipos de los abonados y de los elementos de conmutación que sirven para seleccionar una determinada ruta o grupo de ellas entre dos abonados.

Evolución

En 1854, el inventor francés Charles Bourseul planteó la posibilidad de utilizar las vibraciones causadas por la voz sobre un disco flexible o diafragma, con el fin de activar y desactivar un circuito eléctrico y producir unas vibraciones similares en un diafragma situado en un lugar remoto, que reproduciría el sonido original. Algunos años más tarde, el físico alemán Johann Philip Reis inventó un instrumento que transmitía notas musicales, pero no era capaz de reproducir la voz humana. En 1877, tras haber descubierto que para transmitir la voz sólo se podía utilizar corriente continua, el inventor estadounidense de origen inglés Alexander Graham Bell construyó el primer teléfono capaz de transmitir y recibir voz humana con toda su calidad y su timbre.

Teléfono magnético de Bell

El conjunto básico del invento de Bell estaba formado por un emisor, un receptor y un único cable de conexión. El emisor y el receptor eran idénticos y contenían un diafragma metálico flexible y un imán con forma de herradura dentro de una bobina. Las ondas sonoras que incidían sobre el diafragma lo hacían vibrar dentro del campo del imán. Esta vibración inducía una corriente eléctrica en la bobina, que variaba según las vibraciones del diafragma. La corriente viajaba por el cable hasta el receptor, donde generaba fluctuaciones de la intensidad del campo magnético de éste (véase Magnetismo), haciendo que su diafragma vibrase y reprodujese el sonido original.

En los receptores de los teléfonos modernos, el imán es plano como una moneda y el campo magnético que actúa sobre el diafragma de hierro es de mayor intensidad y homogeneidad. Los transmisores modernos llevan un diafragma muy fino montado debajo de un rejilla perforada. En el centro del diafragma hay un pequeño receptáculo relleno de gránulos de carbono. Las ondas sonoras que atraviesan la rejilla provocan un vaivén del receptáculo. En el movimiento descendente, los gránulos quedan compactados y producen un aumento de la corriente que circula por el transmisor.

Partes del aparato telefónico

El aparato telefónico consta de un transmisor, un receptor, un dispositivo marcador, una alarma acústica y un circuito supresor de efectos locales. Si se trata de un aparato de dos piezas, el transmisor y el receptor van montados en el auricular, el timbre se halla en la base y el elemento de marcado y el circuito supresor de efectos locales pueden estar en cualquiera de las dos partes, pero, por lo general, van juntos. Los teléfonos más complejos pueden llevar un micrófono y un altavoz en la pieza base, aparte del transmisor y el receptor en el auricular. En los teléfonos portátiles, el cable del auricular se sustituye por un enlace de radio entre el auricular y la base, aunque sigue teniendo un cable para la línea. Los teléfonos celulares suelen ser de una sola pieza, y sus componentes en miniatura permiten combinar la base y el auricular en un elemento manual que se comunica con una estación remota de radio. No precisan línea ni cables para el auricular.

Los teléfonos antiguos usaban un único dispositivo como transmisor y receptor. Sus componentes básicos eran un imán permanente con un cable enrollado que lo convertía en electroimán y un fino diafragma de tela y metal sometido a la fuerza de atracción del imán. La fuerza de la voz, en cuanto ondas de sonido, provocaban un movimiento del diafragma, que a su vez generaba una minúscula corriente alterna en los cables del electroimán. Estos equipos eran capaces de reproducir la voz, aunque tan débilmente que eran poco más que un juguete.

La invención del transmisor telefónico de carbono por Emile Berliner constituye la clave en la aparición del teléfono útil. Consta de unos gránulos de carbono colocados entre unas láminas metálicas denominadas electrodos, una de las cuales es el diafragma, que transmite variaciones de presión a dichos gránulos. Los electrodos conducen la electricidad que circula a través del carbono. Las variaciones de presión originan a su vez una variación de la resistencia eléctrica del carbono. A través de la línea se aplica una corriente continua a los electrodos, y la corriente continua resultante también varía. La fluctuación de dicha corriente a través del transmisor de carbono se traduce en una mayor potencia que la inherente a la onda sonora original. Este efecto se denomina amplificación, y tiene una importancia crucial. Un transmisor electromagnético sólo es capaz de convertir energía, y siempre producirá una energía eléctrica menor que la que contiene una onda sonora.

El equivalente eléctrico del imán permanente es una sustancia plástica denominada electreto. Al igual que un imán permanente produce un campo magnético permanente en el espacio, un electreto genera un campo eléctrico permanente en el espacio. Tal como un conductor eléctrico que se mueve en el seno de un campo magnético induce una corriente, el movimiento de un electrodo dentro de un campo eléctrico puede producir una modificación del voltaje entre un electrodo móvil y otro estacionario en la parte opuesta del electreto. Aunque este efecto se conocía de antiguo, fue sólo una curiosidad de laboratorio hasta la aparición de materiales capaces de conservar una carga electrostática durante años. Los transmisores telefónicos se basan actualmente en este efecto, en vez de en la resistencia sensible a la presión de los gránulos de carbono, ya que se consigue con un micrófono de electretos muy pequeño, ligero y económico. Los micrófonos de electretos se basan en los transistores para la amplificación requerida.

Dado que el transmisor de carbono no resulta práctico a la hora de convertir energía eléctrica en presión sonora, los teléfonos fueron evolucionando hacia receptores separados de los transmisores. Esta disposición permite colocar el transmisor cerca de los labios para recoger el máximo de energía sonora, y el receptor en el auricular, lo cual elimina los molestos ruidos de fondo. El receptor sigue siendo un imán permanente con un arrollamiento de hilo conductor, pero ahora lleva un diafragma de aluminio sujeto a una pieza metálica. Los detalles del diseño han experimentado enormes mejoras, pero el concepto original continúa permitiendo equipos sólidos y eficaces.

La alarma acústica de los teléfonos se suele denominar timbre, referencia al hecho de que durante la mayor parte de la historia de este equipo la función de alarma la proporcionaba un timbre eléctrico. La creación de un sustituto electrónico para el timbre, capaz de generar un sonido agradable a la vez que distintivo a un coste razonable, constituyó una tarea sorprendentemente ardua. Para muchas personas, el sonido del timbre sigue siendo preferible al de un zumbador electrónico. Sin embargo, dado que el timbre mecánico exige un cierto volumen físico para resultar eficaz, la tendencia hacia equipos cada vez menores impone el uso de alarmas electrónicas en la mayoría de los teléfonos. La sustitución progresiva del timbre permitirá asimismo cambiar, en un futuro próximo, el método actual de activación de la alarma —corriente alterna de 90 voltios (V) y 20 hercios (Hz) a la línea— por técnicas de voltajes menores, más compatibles con los teléfonos transistorizados. Algo similar se está produciendo con el esquema de marcado de los teléfonos.

El marcado telefónico ya ha sufrido toda una evolución a lo largo de su historia. Existen dos formas de marcado, el de pulso y el de multifrecuencia o tono.

El disco de marcado tiene un diseño mecánico muy ingenioso; consta de los números 1 al 9 seguidos del 0, colocados en círculo debajo de los agujeros de un disco móvil y perforado. Se coloca el dedo en el agujero correspondiente al número elegido y se hace girar el disco en el sentido de las agujas del reloj hasta alcanzar el tope y a continuación se suelta el disco. Un muelle obliga al disco a volver a su posición inicial y, al mismo tiempo que gira, abre un conmutador eléctrico tantas veces como gire el disco, para marcar el número elegido; en el caso del 0 se efectúan 10 aperturas, ya que es el último número del disco. El resultado es una serie de pulsos de llamada en la corriente eléctrica que circula entre el aparato telefónico y la centralita. Cada pulso tiene una amplitud igual al voltaje suministrado por la pila, generalmente 50 V, y dura unos 45 ms (milisegundos, milésimas de segundo). Los equipos de la centralita cuentan estos pulsos y determinan el número que se desea marcar.

Los pulsos eléctricos producidos por el disco giratorio resultan idóneos para el control de los equipos de conmutación paso-a-paso de las primeras centrales de conmutación automáticas. Sin embargo, el marcado mecánico constituye una de las fuentes principales de costes de mantenimiento, y el proceso de marcado por disco resulta lento, sobre todo en el caso de números largos. La disponibilidad de la amplificación barata y fiable que trajo el transistor aconsejó el diseño de un sistema de marcado basado en la transmisión de unos tonos de potencia bastante pequeña, en vez de los pulsos de marcado de gran potencia. Cada botón de un teclado de multifrecuencia controla el envío de una pareja de tonos. Se utiliza un esquema de codificación `2 de 7' en el que el primer tono corresponde a la fila de una matriz normal de 12 botones y el segundo a la columna (4 filas más 3 columnas necesitan 7 tonos).

Actualmente, la mayoría de los teléfonos llevan botones en vez de disco de marcado. Dado que el sistema de tonos se comercializaba opcionalmente con un coste adicional, en las centrales se siguen recibiendo pulsos o multitonos. Como un usuario que compra un equipo puede disponer de una línea que no admite señales de multifrecuencia, los teléfonos de botones disponen generalmente de un conmutador que permite seleccionar el envío de pulsos o tonos.

Hay un elemento funcional importante del teléfono que resulta invisible para el usuario: el circuito supresor de efectos locales. Las personas controlan el tono de voz al hablar y ajustan en consonancia el volumen, fenómeno que se denomina `efecto local'. En los primeros teléfonos, el receptor y el transmisor del equipo iban conectados directamente entre sí y a la línea. Esto hacía que el usuario oyera su propia voz a través del receptor con mucha más intensidad que cuando no lo tenía pegado a la oreja. El sonido era mucho más fuerte que el normal porque el micrófono de carbono amplifica la energía sonora al mismo tiempo que la convierte de acústica a eléctrica. Además de resultar desagradable, esto obligaba al usuario a hablar con mayor suavidad, dificultando la escucha por parte del receptor.

El circuito supresor original contenía un transformador junto con otros componentes cuyas características dependían de los parámetros eléctricos de la línea telefónica. El receptor y el transmisor iban conectados a diferentes `puertos del circuito' (en este caso, diferentes arrollamientos del transformador), no entre sí. El circuito supresor transfiere energía del transmisor a la línea (aunque parte también a otros componentes), sin que nada pase al receptor. Así se elimina la sensación de que uno grita en su propia oreja.

Circuitos y centrales

La llamada telefónica se inicia en la persona que levanta el auricular y espera el tono de llamada. Esto provoca el cierre de un conmutador eléctrico. El cierre de dicho conmutador activa el flujo de una corriente eléctrica por la línea de la persona que efectúa la llamada, entre la ubicación de ésta y el edificio que alberga la centralita automática, que forma parte del sistema de conmutación. Se trata de una corriente continua que no cambia su sentido de flujo, aun cuando pueda hacerlo su intensidad o amplitud. La central detecta dicha corriente y devuelve un tono de llamada, una combinación concreta de dos notas para que resulte perfectamente detectable, tanto por los equipos como por las personas.

Una vez escuchado el tono de llamada, la persona teclea una serie de números mediante los botones del auricular o del equipo de base. Esta secuencia es exclusiva de otro abonado, la persona a quien se llama. El equipo de conmutación de la central elimina el tono de llamada de la línea tras recibir el primer número y, una vez recibido el último, determina si el número con el que se quiere contactar pertenece a la misma central o a otra diferente. En el primer caso, se aplican una serie de intervalos de corriente de llamada a la línea. La corriente de llamada es corriente alterna de 20 Hz, que fluye en ambos sentidos 20 veces por segundo. El teléfono del usuario tiene una alarma acústica que responde a la corriente de llamada, normalmente mediante un sonido perceptible. Cuando se responde al teléfono levantando el auricular, comienza a circular una corriente continua por su línea que es detectada por la central. Ésta deja de aplicar la corriente de llamada y establece una conexión entre la persona que llama y la llamada, que es la que permite hablar.

En los primeros teléfonos, la corriente estaba generada por una batería. El circuito local tenía, además de la batería y el transmisor, un arrollamiento de transformador, que recibe el nombre de bobina de inducción; el otro arrollamiento, conectado a la línea, elevaba el voltaje de la onda sonora. Las conexiones entre teléfonos eran de tipo manual, a cargo de operadores que trabajaban en centralitas ubicadas en las oficinas centrales de conmutación.

A medida que se fueron desarrollando los sistemas telefónicos, las conexiones manuales empezaron a resultar demasiado lentas y laboriosas. Esto fue el detonante para la construcción de una serie de dispositivos mecánicos y electrónicos que permitiesen las conexiones automáticas (véase Electrónica). Los teléfonos modernos tienen un dispositivo electrónico que transmite una serie de pulsos sucesivos de corriente o varios tonos audibles correspondientes al número marcado. Los equipos electrónicos de la central de conmutación se encargan de traducir automáticamente la señal y de dirigir la llamada a su destino.

La tecnología de estado sólido ha permitido que estas centrales puedan procesar las llamadas a una velocidad de una millonésima de segundo, por lo que se pueden procesar simultáneamente grandes cantidades de llamadas. El circuito de entrada convierte, en primer lugar, la voz de quien llama a impulsos digitales. Estos impulsos se transmiten entonces a través de la red mediante sistemas de alta capacidad, que conectan las diferentes llamadas en base a operaciones matemáticas de conmutación computerizadas. Las instrucciones para el sistema se hallan almacenadas en la memoria de una computadora. El mantenimiento de los equipos se ha simplificado gracias a la duplicidad de los componentes. Cuando se produce algún fallo, entra automáticamente en funcionamiento una unidad de reserva para manejar las llamadas. Gracias a estas técnicas, el sistema puede efectuar llamadas rápidas, tanto locales como a larga distancia, determinando con rapidez la ruta más eficaz.

Actualmente, no existe en Estados Unidos ni en Inglaterra ningún teléfono atendido de forma manual. Todos los abonados son atendidos por centrales automáticas. En este tipo de central, las funciones de los operadores humanos las realizan los equipos de conmutación. Un relé de corriente de línea de un circuito ha sustituido el cuadro de conexión manual de luz de la centralita y un conmutador de cruce hace las funciones de los cables. Dado que ahora es cuando los ordenadores empiezan a estar en condiciones de entender comandos hablados, casi un siglo después de las primeras centrales automáticas, se sigue utilizando el visor para mostrar el número marcado. Los registros de entrada almacenan este número y luego lo transmiten a la central de conmutación, que a su vez activa el conmutador de cruce para completar la llamada o dirigirla a un conmutador de mayor nivel para el tratamiento pertinente.

Telefonía transoceánica

El servicio telefonía transoceánica se implantó comercialmente en 1927, pero el problema de la amplificación frenó el tendido de cables telefónicos hasta 1956, año en que entró en servicio el primer cable telefónico submarino transoceánico del mundo, que conectaba Terranova y Escocia.

Telefonía por onda portadora

Utilizando frecuencias superiores al rango de voz, que va desde los 4.000 hasta varios millones de ciclos por segundo, o hercios, se pueden transmitir simultáneamente hasta 13.200 llamadas telefónicas por una misma conducción. Las técnicas de telefonía por onda portadora también se utilizan para enviar mensajes telefónicos a través de las líneas normales de distribución sin interferir con el servicio ordinario. Debido al crecimiento de tamaño y complejidad de los sistemas, se utilizan los amplificadores de estado sólido, denominados repetidores, para amplificar los mensajes a intervalos regulares.

Cable coaxial

El cable coaxial, que apareció en 1936, utiliza una serie de conductores para soportar un gran número de circuitos. El cable coaxial moderno está fabricado con tubos de cobre de 0,95 cm de diámetro. Cada uno de ellos lleva, justo en el centro del tubo, un hilo fino de cobre sujeto con discos plásticos aislantes separados entre sí unos 2,5 cm. El tubo y el hilo tienen el mismo centro, es decir, son coaxiales. Los tubos de cobre protegen la señal transmitida de posibles interferencias eléctricas y evitan pérdidas de energía por radiación. Un cable, compuesto por 22 tubos coaxiales dispuestos en anillos encastrados en polietileno y plomo, puede transportar simultáneamente 132.000 mensajes.

Fibras ópticas

Los cables coaxiales se están sustituyendo progresivamente por fibras ópticas de vidrio. Los mensajes se codifican digitalmente en impulsos de luz y se transmiten a grandes distancias. Un cable de fibra puede tener hasta 50 pares de ellas, y cada par soporta hasta 4.000 circuitos de voz. El fundamento de la nueva tecnología de fibras ópticas, el láser, aprovecha la región visible del espectro electromagnético, donde las frecuencias son miles de veces superiores a las de la radio y, por consiguiente, pueden transportar un volumen mucho mayor de información. El diodo emisor de luz (LED), un dispositivo más sencillo, puede resultar adecuado para la mayoría de las funciones de transmisión.

Un cable de fibra óptica, el TAT 8, transporta más del doble de circuitos transatlánticos que los existentes en la década de 1980. Formando parte de un sistema que se extiende desde Nueva Jersey hasta Inglaterra y Francia, puede transmitir hasta 50.000 conversaciones a la vez. Este tipo de cables sirven también de canales para la transmisión a alta velocidad de datos informáticos, siendo más segura que la que proporcionan los satélites de comunicaciones (véase Comunicación vía satélite). Otro avance importante en las telecomunicaciones, el TAT 9, un cable de fibra con mucha mayor capacidad, entró en funcionamiento en 1992 y puede transmitir simultáneamente 75.000 llamadas.

Reemisor de microondas

En este método de transmisión, las ondas de radio que se hallan en la banda de frecuencias muy altas, y que se denominan microondas, se remiten de estación a estación. Dado que la transmisión de microondas exige un camino expedito entre estación emisora y receptora, la distancia media entre estaciones repetidoras es de unos 40 km. Un canal de relé de microondas puede transmitir hasta 600 conversaciones telefónicas.

Telefonía por satélite

En 1969 se completó la primera red telefónica global en base a una serie de satélites en órbitas estacionarias a una distancia de la Tierra de 35.880 km. Estos satélites van alimentados por células de energía solar. Las llamadas transmitidas desde una antena terrestre se amplifican y se retransmiten a estaciones terrestres remotas. La integración de los satélites y los equipos terrestres permite dirigir llamadas entre diferentes continentes con la misma facilidad que entre lugares muy próximos. Gracias a la digitalización de las transmisiones, los satélites de la serie global Intelsat pueden retransmitir simultáneamente hasta 33.000 llamadas, así como diferentes canales de televisión.

Un único satélite no serviría para realizar una llamada, por ejemplo, entre Nueva York y Hong Kong, pero dos sí. Incluso teniendo en cuenta el coste de un satélite, esta vía resulta más barata de instalar y mantener por canal que la ruta equivalente utilizando cables coaxiales tendidos por el fondo del mar. En consecuencia, para grandes distancias se utilizan en todo lo posible los enlaces por satélite.

Sin embargo, los satélites presentan una desventaja importante. Debido a la gran distancia hasta el satélite y la velocidad limitada de las ondas de radio, hay un retraso apreciable en las respuestas habladas. Por eso, muchas llamadas sólo utilizan el satélite en un sentido de la transmisión (por ejemplo, de Nueva York hacia San Francisco) y un enlace terrestre por microondas o cable coaxial en el otro sentido. Un enlace vía satélite para ambos sentidos resultaría irritante para dos personas conversando entre Nueva York y Hong Kong, ya que apenas podrían efectuar interrupciones, cosa muy frecuente en las conversaciones, y además se verían afectadas por el gran retraso (más de un segundo) en la respuesta de la otra persona.

La mayoría de las grandes ciudades están hoy enlazadas por una combinación de conexiones por microondas, cable coaxial, fibra óptica y satélites. La capacidad de cada uno de los sistemas depende de su antigüedad y el territorio cubierto (los cables submarinos están diseñados de forma muy conservadora y tienen menor capacidad que los cables de superficie), pero, en general, se pueden clasificar de la siguiente forma: la digitalización simple a través de un par paralelo proporciona decenas de circuitos por par; la coaxial permite cientos de circuitos por par y miles por cable; las microondas y los satélites dan miles de circuitos por enlace y la fibra óptica permite hasta decenas de miles de circuitos por fibra. La capacidad de cada tipo de sistema ha ido aumentando notablemente desde su aparición debido a la continua mejora de la ingeniería.

Teléfonos y radiodifusión

Los equipos de telefonía de larga distancia pueden transportar programas de radio y televisión a través de grandes distancias hasta muchas estaciones dispersas para su difusión simultánea. En algunos casos, la parte de audio de los programas de televisión se puede transmitir mediante circuitos de cables a frecuencias audio o a las frecuencias de portadora utilizadas para transmitir las conversaciones telefónicas. Las imágenes de televisión se transmiten por medio de cables coaxiales, microondas y circuitos de satélites.

Videoteléfono

El primer videoteléfono de dos vías fue presentado en 1930 por el inventor estadounidense Herbert Eugene Ives en Nueva York. El videoteléfono se puede conectar a una computadora para visualizar informes, diagramas y esquemas en lugares remotos. Permite así mismo celebrar reuniones cara a cara de personas en diferentes ciudades y puede actuar de enlace entre centros de reuniones en el seno de una red de grandes ciudades. Los videoteléfonos ya están disponibles comercialmente y se pueden utilizar en líneas nacionales para llamadas cara a cara. Funciones análogas también existen ya en los ordenadores o computadoras equipadas a tal fin.

Comunicación móvil celular

Los teléfonos celulares, que se utilizan en los automóviles, aviones y trenes de pasajeros, son en esencia unos radioteléfonos de baja potencia. Las llamadas pasan por los transmisores de audio colocados dentro de pequeñas unidades geográficas llamadas células. Dado que las señales de cada célula son demasiado débiles para interferir con las de otras células que operan en las mismas frecuencias, se puede utilizar un número mayor de canales que en la transmisión con radiofrecuencia de alta potencia. La modulación en frecuencia de banda estrecha es el método más común de transmisión y a cada mensaje se le asigna una portadora exclusiva para la célula desde la que se transmite (véase Frecuencia modulada).

Correo de voz

El correo de voz permite grabar los mensajes recibidos para su posterior reproducción en caso de que la llamada no sea atendida. En las versiones más avanzadas de correo de voz, el usuario puede grabar un mensaje que será transmitido más adelante a lo largo del día.

El correo de voz se puede adquirir en la compañía telefónica como un servicio de conmutación o mediante la compra de un contestador automático. Por lo general, es un equipo telefónico ordinario dotado de funciones de grabación, reproducción y detección automática de llamada. Si la llamada entrante se contesta en cualquier teléfono de la línea antes de que suene un número determinado de veces, el contestador no actúa. Sin embargo, cumplido el número de llamadas, el contestador automático procede a descolgar y reproduce un mensaje grabado previamente, informando que el abonado no puede atender la llamada en ese momento e invitando a dejar un mensaje grabado.

El dueño del contestador automático es avisado de la presencia de mensajes grabados mediante una luz o un pitido audible, pudiendo recuperar más tarde el mensaje. La mayoría de los contestadores automáticos y todos los servicios de operadora permiten así mismo al usuario recuperar los mensajes grabados desde un lugar alejado marcando un código determinado cuando haya obtenido respuesta de su equipo.

Tendencias tecnológicas

La sustitución de los cables coaxiales transoceánicos por cables de fibra óptica continúa en la actualidad. Los avances de la tecnología de circuitos integrados y de los semiconductores han permitido diseñar y comercializar teléfonos que no sólo producen calidad de voz de alta fidelidad, sino que ofrecen toda una serie de funciones como números memorizados, desvío de llamadas, espera de llamadas e identificación del número que llama.

Radio, sistema de comunicación mediante ondas electromagnéticas que se propagan por el espacio. Debido a sus características variables, se utilizan ondas radiofónicas de diferente longitud para distintos fines; por lo general se identifican mediante su frecuencia. Las ondas más cortas poseen una frecuencia (número de ciclos por segundo) más alta; las ondas más largas tienen una frecuencia más baja (menos ciclos por segundo).

El nombre del pionero alemán de la radio Heinrich Hertz ha servido para bautizar al ciclo por segundo (hercio, Hz). Un kilohercio (kHz) son 1.000 ciclos por segundo, 1 megahercio (MHz) es 1 millón de ciclos por segundo y 1 gigahercio (GHz) 1 billón de ciclos por segundo. Las ondas de radio van desde algunos kilohercios a varios gigahercios. Las ondas de luz visible son mucho más cortas. En el vacío, toda radiación electromagnética se desplaza en forma de ondas a una velocidad uniforme de 300.000 kilómetros por segundo.

Las ondas de radio se utilizan no sólo en la radiodifusión, sino también en la telegrafía inalámbrica, la transmisión por teléfono, la televisión, el radar, los sistemas de navegación y la comunicación espacial. En la atmósfera, las características físicas del aire ocasionan pequeñas variaciones en el movimiento ondulatorio, que originan errores en los sistemas de comunicación radiofónica como el radar. Además, las tormentas o las perturbaciones eléctricas provocan fenómenos anormales en la propagación de las ondas de radio.

Las ondas electromagnéticas dentro de una atmósfera uniforme se desplazan en línea recta, y como la superficie terrestre es prácticamente esférica, la comunicación radiofónica a larga distancia es posible gracias a la reflexión de las ondas de radio en la ionosfera. Las ondas radiofónicas de longitud de onda inferior a unos 10 m, que reciben los nombres de frecuencias muy alta, ultraalta y superalta (VHF, UHF y SHF), no se reflejan en la ionosfera; así, en la práctica, estas ondas muy cortas sólo se captan a distancia visual. Las longitudes de onda inferiores a unos pocos centímetros son absorbidas por las gotas de agua o por las nubes; las inferiores a 1,5 cm pueden quedar absorbidas por el vapor de agua existente en la atmósfera limpia.

Los sistemas normales de radiocomunicación constan de dos componentes básicos, el transmisor y el receptor. El primero genera oscilaciones eléctricas con una frecuencia de radio denominada frecuencia portadora. Se puede amplificar la amplitud o la propia frecuencia para variar la onda portadora. Una señal modulada en amplitud se compone de la frecuencia portadora y dos bandas laterales producto de la modulación. La frecuencia modulada (FM) produce más de un par de bandas laterales para cada frecuencia de modulación, gracias a lo cual son posibles las complejas variaciones que se emiten en forma de voz o cualquier otro sonido en la radiodifusión, y en las alteraciones de luz y oscuridad en las emisiones televisivas.

Transmisor

Los componentes fundamentales de un transmisor de radio son un generador de oscilaciones (oscilador) para convertir la corriente eléctrica común en oscilaciones de una determinada frecuencia de radio; los amplificadores para aumentar la intensidad de dichas oscilaciones conservando la frecuencia establecida y un transductor para convertir la información a transmitir en un voltaje eléctrico variable y proporcional a cada valor instantáneo de la intensidad. En el caso de la transmisión de sonido, el transductor es un micrófono; para transmitir imágenes se utiliza como transductor un dispositivo fotoeléctrico.

Otros componentes importantes de un transmisor de radio son el modulador, que aprovecha los voltajes proporcionales para controlar las variaciones en la intensidad de oscilación o la frecuencia instantánea de la portadora, y la antena, que radia una onda portadora igualmente modulada. Cada antena presenta ciertas propiedades direccionales, es decir, radia más energía en unas direcciones que en otras, pero la antena siempre se puede modificar de forma que los patrones de radiación varíen desde un rayo relativamente estrecho hasta una distribución homogénea en todas las direcciones; este último tipo de radiación se usa en la radiodifusión.

El método concreto utilizado para diseñar y disponer los diversos componentes depende del efecto buscado. Los criterios principales de una radio en un avión comercial o militar, por ejemplo, son que tenga un peso reducido y que resulte inteligible; el coste es un aspecto secundario y la fidelidad de reproducción carece totalmente de importancia. En una emisora comercial de radio, sin embargo, el tamaño y el peso entrañan poca importancia, el coste debe tenerse en cuenta y la fidelidad resulta fundamental, sobre todo en el caso de emisoras FM; el control estricto de la frecuencia constituye una necesidad crítica. En Estados Unidos, por ejemplo, una emisora comercial típica de 1.000 kHz posee un ancho de banda de 10 kHz, pero este ancho sólo se puede utilizar para modulación; la frecuencia de la portadora propiamente dicha se tiene que mantener exactamente en los 1.000 kHz, ya que una desviación de una centésima del 1% originaría grandes interferencias con emisoras de la misma frecuencia, aunque se hallen distantes.

Osciladores

En una emisora comercial normal, la frecuencia de la portadora se genera mediante un oscilador de cristal de cuarzo rigurosamente controlado. El método básico para controlar frecuencias en la mayoría de las emisoras de radio es mediante circuitos de absorción, o circuitos resonantes, que poseen valores específicos de inductancia y capacitancia (véase Unidades eléctricas; Resonancia) y que, por tanto, favorecen la producción de corrientes alternas de una determinada frecuencia e impiden la circulación de corrientes de frecuencias distintas. De todas formas, cuando la frecuencia debe ser enormemente estable se utiliza un cristal de cuarzo con una frecuencia natural concreta de oscilación eléctrica para estabilizar las oscilaciones. En realidad, éstas se generan a baja potencia en una válvula electrónica y se amplifican en amplificadores de potencia que actúan como retardadores para evitar la interacción del oscilador con otros componentes del transmisor, ya que tal interacción alteraría la frecuencia. El cristal tiene la forma exacta para las dimensiones necesarias a fin de proporcionar la frecuencia deseada, que luego se puede modificar ligeramente agregando un condensador al circuito para conseguir la frecuencia exacta. En un circuito eléctrico bien diseñado, dicho oscilador no varía en más de una centésima del 1% en la frecuencia. Si se monta el cristal al vacío a temperatura constante y se estabilizan los voltajes, se puede conseguir una estabilidad en la frecuencia próxima a una millonésima del 1%.

Los osciladores de cristal resultan de máxima utilidad en las gamas denominadas de frecuencia muy baja, baja y media (VLF, LF y MF). Cuando han de generarse frecuencias superiores a los 10 MHz, el oscilador maestro se diseña para que genere una frecuencia intermedia, que luego se va duplicando cuantas veces sea necesario mediante circuitos electrónicos especiales. Si no se precisa un control estricto de la frecuencia, se pueden utilizar circuitos resonantes con válvulas normales a fin de producir oscilaciones de hasta 1.000 MHz, y se emplean los klistrones reflex para generar las frecuencias superiores a los 30.000 MHz. Los klistrones se sustituyen por magnetrones cuando hay que generar cantidades de mayor potencia.

Modulación

La modulación de la portadora para que pueda transportar impulsos se puede efectuar a nivel bajo o alto. En el primer caso, la señal de frecuencia audio del micrófono, con una amplificación pequeña o nula, sirve para modular la salida del oscilador y la frecuencia modulada de la portadora se amplifica antes de conducirla a la antena; en el segundo caso, las oscilaciones de radiofrecuencia y la señal de frecuencia audio se amplifican de forma independiente y la modulación se efectúa justo antes de transmitir las oscilaciones a la antena. La señal se puede superponer a la portadora mediante modulación de frecuencia (FM) o de amplitud (AM).

La forma más sencilla de modulación es la codificación, interrumpiendo la onda portadora a intervalos concretos mediante una clave o conmutador para formar los puntos y las rayas de la radiotelegrafía de onda continua.

La onda portadora también se puede modular variando la amplitud de la onda según las variaciones de la frecuencia e intensidad de una señal sonora, tal como una nota musical. Esta forma de modulación, AM, se utiliza en muchos servicios de radiotelefonía, incluidas las emisiones normales de radio. La AM también se emplea en la telefonía por onda portadora, en la que la portadora modulada se transmite por cable, y en la transmisión de imágenes estáticas a través de cable o radio.

En la FM, la frecuencia de la onda portadora se varía dentro de un rango establecido a un ritmo equivalente a la frecuencia de una señal sonora. Esta forma de modulación, desarrollada en la década de 1930, presenta la ventaja de generar señales relativamente limpias de ruidos e interferencias procedentes de fuentes tales como los sistemas de encendido de los automóviles o las tormentas, que afectan en gran medida a las señales AM. Por tanto, la radiodifusión FM se efectúa en bandas de alta frecuencia (88 a 108 MHz), aptas para señales grandes pero con alcance de recepción limitado.

Las ondas portadoras también se pueden modular variando la fase de la portadora según la amplitud de la señal. La modulación en fase, sin embargo, ha quedado reducida a equipos especializados.

El desarrollo de la técnica de transmisión de ondas continuas en pequeños impulsos de enorme potencia, como en el caso del radar, planteó la posibilidad de otra forma nueva de modulación, la modulación de impulsos en tiempo, en la que el espacio entre los impulsos se modifica de acuerdo con la señal.

La información transportada por una onda modulada se devuelve a su forma original mediante el proceso inverso, denominado demodulación o detección. Las emisiones de ondas de radio a frecuencias bajas y medias van moduladas en amplitud. Para frecuencias más altas se utilizan tanto la AM como la FM; en la televisión comercial de nuestros días, por ejemplo, el sonido va por FM, mientras que las imágenes se transportan por AM. En el rango de las frecuencias superaltas (por encima del rango de las ultraaltas), en el que se pueden utilizar anchos de banda mayores, la imagen también se transmite por FM. En la actualidad, tanto el sonido como las imágenes se pueden enviar de forma digital a dichas frecuencias.

Antenas

La antena del transmisor no necesita estar unida al propio transmisor. La radiodifusión comercial a frecuencias medias exige normalmente una antena muy grande, cuya ubicación óptima es de forma aislada, lejos de cualquier población, mientras que el estudio de radio suele hallarse en medio de la ciudad. La FM, la televisión y demás emisiones con frecuencias muy elevadas exigen antenas muy altas si se pretende conseguir un cierto alcance y no resulta aconsejable colocarlas cerca del estudio de emisión. En todos estos casos las señales se transmiten a través de cables. Las líneas telefónicas normales suelen valer para la mayoría de las emisiones comerciales de radio; si se precisa obtener alta fidelidad o frecuencias muy altas, se utilizan cables coaxiales.

Receptor

Los componentes fundamentales de un receptor de radio son: 1) una antena para recibir las ondas electromagnéticas y convertirlas en oscilaciones eléctricas; 2) amplificadores para aumentar la intensidad de dichas oscilaciones; 3) equipos para la demodulación; 4) un altavoz para convertir los impulsos en ondas sonoras perceptibles por el oído humano (y en televisión, un tubo de imágenes para convertir la señal en ondas luminosas visibles), y 5) en la mayoría de los receptores, unos osciladores para generar ondas de radiofrecuencia que puedan mezclarse con las ondas recibidas.

La señal que llega de la antena, compuesta por una oscilación de la portadora de radiofrecuencia, modulada por una señal de frecuencia audio o vídeo que contiene los impulsos, suele ser muy débil. La sensibilidad de algunos receptores de radio modernos es tan grande que con que la señal de la antena sea capaz de producir una corriente alterna de unos pocos cientos de electrones, la señal se puede detectar y amplificar hasta producir un sonido inteligible por el altavoz. La mayoría de los receptores pueden funcionar aceptablemente con una entrada de algunas millonésimas de voltio. Sin embargo, el aspecto básico en el diseño del receptor es que las señales muy débiles no se convierten en válidas simplemente amplificando, de forma indiscriminada, tanto la señal deseada como los ruidos laterales (véase Ruido más adelante). Así, el cometido principal del diseñador consiste en garantizar la recepción prioritaria de la señal deseada.

Muchos receptores modernos de radio son de tipo superheterodino, en el que un oscilador genera una onda de radiofrecuencia que se mezcla con la onda entrante, produciendo así una onda de frecuencia menor; esta última se denomina frecuencia media. Para sintonizar el receptor a las distintas frecuencias se modifica la frecuencia de las oscilaciones, pero la media siempre permanece fija (en 455 kHz para la mayoría de los receptores de AM y en 10,7 MHz para los de FM). El oscilador se sintoniza modificando la capacidad del condensador en su circuito oscilador; el circuito de la antena se sintoniza de forma similar mediante un condensador.

En todos los receptores hay una o más etapas de amplificación de frecuencia media; además, puede haber una o más etapas de amplificación de radiofrecuencia. En la etapa de frecuencia media se suelen incluir circuitos auxiliares, como el control automático de volumen, que funciona rectificando parte de la salida de un circuito de amplificación y alimentando con ella al elemento de control del mismo circuito o de otro anterior (véase Rectificación). El detector, denominado a menudo segundo detector (el primero es el mezclador), suele ser un simple diodo que actúa de rectificador y produce una señal de frecuencia audio. Las ondas FM se demodulan o detectan mediante circuitos que reciben el nombre de discriminadores o radiodetectores; transforman las variaciones de la frecuencia en diferentes amplitudes de la señal.

Amplificadores

Los amplificadores de radiofrecuencia y de frecuencia media son amplificadores de voltaje, que aumentan el voltaje de la señal. Los receptores de radio pueden tener una o más etapas de amplificación de voltaje de frecuencia audio. Además, la última etapa antes del altavoz tiene que ser de amplificación de potencia. Un receptor de alta fidelidad contiene los circuitos de sintonía y de amplificación de cualquier radio. Como alternativa, una radio de alta fidelidad puede tener un amplificador y un sintonizador independientes.

Las características principales de un buen receptor de radio son una sensibilidad, una selectividad y una fidelidad muy elevadas y un nivel de ruido bajo. La sensibilidad se consigue en primera instancia mediante muchas etapas de amplificación y factores altos de amplificación, pero la amplificación elevada carece de sentido si no se pueden conseguir una fidelidad aceptable y un nivel de ruido bajo. Los receptores más sensibles tienen una etapa de amplificación de radiofrecuencia sintonizada. La selectividad es la capacidad del receptor de captar señales de una emisora y rechazar otras de emisoras diferentes que limitan con frecuencias muy próximas. La selectividad extrema tampoco resulta aconsejable, ya que se precisa un ancho de banda de muchos kilohercios para recibir los componentes de alta frecuencia de las señales de frecuencia audio. Un buen receptor sintonizado a una emisora presenta una respuesta cero a otra emisora que se diferencia en 20 kHz. La selectividad depende sobre todo de los circuitos en la etapa de la frecuencia intermedia.

Sistemas de alta fidelidad

Fidelidad es la uniformidad de respuesta del receptor a diferentes señales de frecuencia audio moduladas en la portadora. La altísima fidelidad, que se traduce en una respuesta plana (idéntica amplificación de todas las frecuencias audio) a través de todo el rango audible desde los 20 Hz hasta los 20 kHz, resulta extremadamente difícil de conseguir. Un sistema de alta fidelidad es tan potente como su componente más débil, y entre éstos no sólo se incluyen todos los circuitos del receptor, sino también el altavoz, las propiedades acústicas del lugar donde se encuentra el altavoz y el transmisor a que está sintonizado el receptor (véase Acústica). La mayoría de las emisoras AM no reproducen con fidelidad los sonidos por debajo de 100 Hz o por encima de 5 kHz; las emisoras FM suelen tener una gama de frecuencias entre 50 Hz y 15 kilohercios.

Distorsión

En las transmisiones de radio a menudo se introduce una forma de distorsión de amplitud al aumentar la intensidad relativa de las frecuencias más altas de audio. En el receptor aparece un factor equivalente de atenuación de alta frecuencia. El efecto conjunto de estas dos formas de distorsión es una reducción del ruido de fondo o estático en el receptor. Muchos receptores van equipados con controles de tono ajustables por el usuario, de forma que la amplificación de las frecuencias altas y bajas se pueda adaptar a gusto del oyente. Otra fuente de distorsión es la modulación transversal, la transferencia de señales de un circuito a otro por culpa de un apantallamiento defectuoso. La distorsión armónica ocasionada por la transferencia no lineal de señales a través de las etapas de amplificación puede reducirse notablemente utilizando circuitería de realimentación negativa, que anula gran parte de la distorsión generada en las etapas de amplificación.

Ruido

El ruido constituye un problema grave en todos los receptores de radio. Hay diferentes tipos de ruido, como el zumbido, un tono constante de baja frecuencia (unas dos octavas por debajo del do), producido generalmente por la frecuencia de la fuente de alimentación de corriente alterna (por lo común 60 Hz) que se superpone a la señal debido a un filtrado o un apantallamiento defectuoso; el siseo, un tono constante de alta frecuencia, y el silbido, un tono limpio de alta frecuencia producido por una oscilación involuntaria de frecuencia audio, o por un golpeteo. Estos ruidos se pueden eliminar mediante un diseño y una construcción adecuados.

Sin embargo, ciertos tipos de ruidos no se pueden eliminar. El más importante en los equipos normales de AM de baja y media frecuencias es el ruido parásito, originado por perturbaciones eléctricas en la atmósfera. El ruido parásito puede proceder del funcionamiento de un equipo eléctrico cercano (como los motores de automóviles o aviones), pero en la mayoría de los casos proviene de los rayos y relámpagos de las tormentas. Las ondas de radio producidas por estas perturbaciones atmosféricas pueden viajar miles de kilómetros sin sufrir apenas atenuación, y, dado que en un radio de algunos miles de kilómetros respecto del receptor de radio siempre hay alguna tormenta, casi siempre aparecen ruidos parásitos.

Los ruidos parásitos afectan a los receptores FM en menor medida, ya que la amplitud de las ondas intermedias está limitada mediante circuitos especiales antes de la discriminación, lo que elimina los efectos de los ruidos parásitos.

Otra fuente primaria de ruido es la agitación térmica de los electrones. En un elemento conductor a temperatura superior al cero absoluto, los electrones se mueven de forma aleatoria. Dado que cualquier movimiento electrónico constituye una corriente eléctrica, la agitación térmica origina ruido al amplificarlo en exceso. Este tipo de ruido se puede evitar si la señal recibida desde la antena es notablemente más potente que la corriente causada por la agitación térmica; en cualquier caso, se puede reducir al mínimo mediante un diseño adecuado. Un receptor teóricamente perfecto a temperatura ordinaria es capaz de recibir la voz de forma inteligible siempre que la potencia de la señal alcance los 4 × 10-18 W; sin embargo, en los receptores normales se precisa una potencia de señal bastante mayor.

Fuente de alimentación

La radio no tiene componentes móviles excepto el altavoz, que vibra algunas milésimas de centímetro, por lo que la única potencia que requiere su funcionamiento es la corriente eléctrica para hacer circular los electrones por los diferentes circuitos. Cuando aparecieron las primeras radios en la década de 1920, la mayoría iban accionadas por pilas. Aunque se siguen utilizando de forma generalizada en los aparatos portátiles, la fuente de alimentación conectada a la red presenta ciertas ventajas, ya que permite al diseñador una mayor libertad a la hora de seleccionar los componentes de los circuitos.

Si la fuente de alimentación de corriente alterna (CA) es de 120 V, ésta se puede alimentar directamente del arrollamiento primario del transformador, obteniéndose en el secundario el voltaje deseado. Esta corriente secundaria debe rectificarse y filtrarse antes de poder ser utilizada, ya que los transistores requieren corriente continua (CC) para su funcionamiento. Las válvulas utilizan CC como corriente anódica; los filamentos se calientan tanto con CC como con CA, pero en este último caso puede originarse algún zumbido.

Las radios de transistores no necesitan una CC tan alta como las válvulas de antes, pero sigue siendo imprescindible el uso de fuentes de alimentación para convertir la corriente continua (CC) de la red comercial en corriente alterna (CA) y para aumentarla o reducirla al valor deseado mediante transformadores. Los aparatos de los aviones o de los automóviles que funcionan con voltajes entre 12 y 14 voltios CC suelen incluir circuitos para convertir el voltaje CC disponible a CA; tras elevarlo o reducirlo hasta el valor deseado, se vuelve a convertir a CC mediante un rectificado. Los aparatos que funcionan con voltajes entre 6 y 24 voltios CC siempre disponen de un elemento para aumentar el voltaje. La llegada de los transistores, los circuitos integrados y demás dispositivos electrónicos de estado sólido, mucho más reducidos y que consumen muy poca potencia, ha suprimido casi totalmente el uso de las válvulas en los equipos de radio, televisión y otras formas de comunicación.

Historia

Aun cuando fueron necesarios muchos descubrimientos en el campo de la electricidad hasta llegar a la radio, su nacimiento data en realidad de 1873, año en el que el físico británico James Clerk Maxwell publicó su teoría sobre las ondas electromagnéticas (véase Radiación electromagnética: Teoría).

Finales del siglo XIX

La teoría de Maxwell se refería sobre todo a las ondas de luz; quince años más tarde, el físico alemán Heinrich Hertz logró generar eléctricamente tales ondas. Suministró una carga eléctrica a un condensador y a continuación le hizo un cortocircuito mediante un arco eléctrico. En la descarga eléctrica resultante, la corriente saltó desde el punto neutro, creando una carga de signo contrario en el condensador, y después continuó saltando de un polo al otro, creando una descarga eléctrica oscilante en forma de chispa. El arco eléctrico radiaba parte de la energía de la chispa en forma de ondas electromagnéticas. Hertz consiguió medir algunas de las propiedades de estas ondas `hercianas', incluyendo su longitud y velocidad.

La idea de utilizar ondas electromagnéticas para la transmisión de mensajes de un punto a otro no era nueva; el heliógrafo, por ejemplo, transmitía mensajes por medio de un haz de rayos luminosos que se podía modular con un obturador para producir señales en forma de los puntos y las rayas del código Morse (véase Samuel F. B. Morse). A tal fin la radio presenta muchas ventajas sobre la luz, aunque no resultasen evidentes a primera vista. Las ondas de radio, por ejemplo, pueden cubrir distancias enormes, a diferencia de las microondas (usadas por Hertz).

Las ondas de radio pueden sufrir grandes atenuaciones y seguir siendo perceptibles, amplificables y detectadas; pero los buenos amplificadores no se hicieron una realidad hasta la aparición de las válvulas electrónicas. Por grandes que fueran los avances de la radiotelegrafía (por ejemplo, en 1901 Marconi desarrolló la comunicación transatlántica), la radiotelefonía nunca habría llegado a ser útil sin los avances de la electrónica. Desde el punto de vista histórico, los desarrollos en el mundo de la radio y en el de la electrónica han ocurrido de forma simultánea.

Para detectar la presencia de la radiación electromagnética, Hertz utilizó un aro parecido a las antenas circulares. En aquella época, el inventor David Edward Hughes había descubierto que un contacto entre una punta metálica y un trozo de carbón no conducía la corriente, pero si hacía circular ondas electromagnéticas por el punto de contacto, éste se hacía conductor. En 1879 Hughes demostró la recepción de señales de radio procedentes de un emisor de chispas alejado un centenar de metros. En dichos experimentos hizo circular una corriente de una célula voltaica a través de una válvula rellena de limaduras de cinc y plata, que se aglomeraban al ser bombardeadas con ondas de radio.

Este principio lo utilizó el físico británico Oliver Joseph Lodge en un dispositivo llamado cohesor para detectar la presencia de ondas de radio. El cohesor, una vez hecho conductor, se podía volver a hacer aislante golpeándolo y haciendo que se separasen las partículas. Aunque era mucho más sensible que la bocina en ausencia de amplificador, el cohesor sólo daba una única respuesta a las ondas de radio de suficiente potencia de diversas intensidades, por lo que servía para la telegrafía, pero no para la telefonía.

El ingeniero electrotécnico e inventor italiano Guglielmo Marconi está considerado universalmente el inventor de la radio. A partir de 1895 fue desarrollando y perfeccionando el cohesor y lo conectó a una forma primitiva de antena, con el extremo conectado a tierra. Además mejoró los osciladores de chispa conectados a antenas rudimentarias. El transmisor se modulaba mediante una clave ordinaria de telégrafo. El cohesor del receptor accionaba un instrumento telegráfico que funcionaba básicamente como amplificador.

En 1896 consiguió transmitir señales desde una distancia de 1,6 km, y registró su primera patente inglesa. En 1897 transmitió señales desde la costa hasta un barco a 29 km en alta mar. Dos años más tarde logró establecer una comunicación comercial entre Inglaterra y Francia capaz de funcionar con independencia del estado del tiempo; a principios de 1901 consiguió enviar señales a más de 322 km de distancia, y a finales de ese mismo año transmitió una carta entera de un lado a otro del océano Atlántico. En 1902 ya se enviaban de forma regular mensajes transatlánticos y en 1905 muchos barcos llevaban equipos de radio para comunicarse con emisoras de costa. Como reconocimiento a sus trabajos en el campo de la telegrafía sin hilos, en 1909 Marconi compartió el Premio Nobel de Física con el físico alemán Karl Ferdinand Braun.

A lo largo de todos estos años se introdujeron diferentes mejoras técnicas. Para la sintonía se utilizaron circuitos resonantes dotados de inductancia y capacitancia. Las antenas se fueron perfeccionando, descubriéndose y aprovechándose sus propiedades direccionales. Se utilizaron los transformadores para aumentar el voltaje enviado a la antena. Se desarrollaron otros detectores para complementar al cohesor y su rudimentario descohesor. Se construyó un detector magnético basado en la propiedad de las ondas magnéticas para desmagnetizar los hilos de acero, un bolómetro que medía el aumento de temperatura de un cable fino cuando lo atravesaban ondas de radio y la denominada válvula de Fleming, precursora de la válvula termoiónica o lámpara de vacío.

Siglo XX

El desarrollo de la válvula electrónica se remonta al descubrimiento que hizo el inventor estadounidense Thomas Alva Edison al comprobar que entre un filamento de una lámpara incandescente y otro electrodo colocado en la misma lámpara fluye una corriente y que además sólo lo hace en un sentido. La válvula de Fleming apenas difería del tubo de Edison. Su desarrollo se debe al físico e ingeniero eléctrico inglés John Ambrose Fleming en 1904 y fue el primer diodo, o válvula de dos elementos, que se utilizó en la radio. El tubo actuaba de detector, rectificador y limitador.

En 1906 se produjo un avance revolucionario, punto de partida de la electrónica, al incorporar el inventor estadounidense Lee de Forest un tercer elemento, la rejilla, entre el filamento y el cátodo de la válvula. El tubo de De Forest, que bautizó con el nombre de `audión' y que actualmente se conoce por triodo (válvula de tres elementos), en principio sólo se utilizó como detector, pero pronto se descubrieron sus propiedades como amplificador y oscilador; en 1915 el desarrollo de la telefonía sin hilos había alcanzado un grado de madurez suficiente como para comunicarse entre Virginia y Hawai (Estados Unidos) y entre Virginia y París (Francia).

Las funciones rectificadoras de los cristales fueron descubiertas en 1912 por el ingeniero eléctrico e inventor estadounidense Greenleaf Whittier Pickard, al poner de manifiesto que los cristales se pueden utilizar como detectores. Este descubrimiento permitió el nacimiento de los receptores con detector de cristal, tan populares en la década de los años veinte. En 1912, el ingeniero eléctrico estadounidense Edwin Howard Armstrong descubrió el circuito reactivo, que permite realimentar una válvula con parte de su propia salida. Éste y otros descubrimientos de Armstrong constituyen la base de muchos circuitos de los equipos modernos de radio.

En 1902, el ingeniero estadounidense Arthur Edwin Kennelly y el físico británico Oliver Heaviside (de forma independiente y casi simultánea) proclamaron la probable existencia de una capa de gas ionizado en la parte alta de la atmósfera que afectaría a la propagación de las ondas de radio. Esta capa, bautizada en principio como la capa de Heaviside o Kennelly-Heaviside, es una de las capas de la ionosfera. Aunque resulta transparente para las longitudes de onda más cortas, desvía o refleja las ondas de longitudes más largas. Gracias a esta reflexión, las ondas de radio se propagan mucho más allá del horizonte.

La propagación de las ondas de radio en la ionosfera se ve seriamente afectada por la hora del día, la estación y la actividad solar. Leves variaciones en la naturaleza y altitud de la ionosfera, que tienen lugar con gran rapidez, pueden afectar la calidad de la recepción a gran distancia. La ionosfera es también la causa de un fenómeno por el cual se recibe una señal en un punto muy distante y no en otro más próximo. Este fenómeno se produce cuando el rayo en tierra ha sido absorbido por obstáculos terrestres y el rayo propagado a través de la ionosfera no se refleja con un ángulo lo suficientemente agudo como para ser recibido a distancias cortas respecto de la antena.

Radio de onda corta

Aun cuando determinadas zonas de las diferentes bandas de radio, onda corta, onda larga, onda media, frecuencia muy alta y frecuencia ultraalta, están asignadas a muy diferentes propósitos, la expresión `radio de onda corta' se refiere generalmente a emisiones de radio en la gama de frecuencia altas (3 a 30 MHz) que cubren grandes distancias, sobre todo en el entorno de las comunicaciones internacionales. Sin embargo, la comunicación mediante microondas a través de un satélite de comunicaciones, proporciona señales de mayor fiabilidad y libres de error (véase Comunicaciones vía satélite).

Por lo general se suele asociar a los radioaficionados con la onda corta, aunque tienen asignadas frecuencias en la banda de onda media, la de muy alta frecuencia y la de ultraalta, así como en la banda de onda corta. Algunas conllevan ciertas restricciones pensadas para que queden a disposición del mayor número posible de usuarios.

Durante la rápida evolución de la radio tras la I Guerra Mundial, los radioaficionados lograron hazañas tan espectaculares como el primer contacto radiofónico (1921) transatlántico. También han prestado una ayuda voluntaria muy valiosa en caso de emergencias con interrupción de las comunicaciones normales. Ciertas organizaciones de radioaficionados han lanzado una serie de satélites aprovechando los lanzamientos normales de Estados Unidos, la antigua Unión Soviética y la Agencia Espacial Europea (ESA). Estos satélites se denominan normalmente Oscar (Orbiting Satellites Carrying Amateur Radio). El primero de ellos, Oscar 1, colocado en órbita en 1961, fue al mismo tiempo el primer satélite no gubernamental; el cuarto, en 1965, proporcionó la primera comunicación directa vía satélite entre Estados Unidos y la Unión Soviética. A principios de la década de 1980 había en todo el mundo más de 1,5 millones de licencias de radioaficionados, incluidos los de la radio de banda ciudadana.

La radio actual

Los enormes avances en el campo de la tecnología de la comunicación radiofónica a partir de la II Guerra Mundial han hecho posible la exploración del espacio (véase Astronáutica), puesta de manifiesto especialmente en las misiones Apolo a la Luna (1969-1972). A bordo de los módulos de mando y lunar se hallaban complejos equipos de transmisión y recepción, parte del compacto sistema de comunicaciones de muy alta frecuencia. El sistema realizaba simultáneamente funciones de voz y de exploración, calculando la distancia entre los dos vehículos mediante la medición del tiempo transcurrido entre la emisión de tonos y la recepción del eco. Las señales de voz de los astronautas también se transmitían simultáneamente a todo el mundo mediante una red de comunicaciones. El sistema de radio celular es una versión en miniatura de las grandes redes radiofónicas.

Fotografía, procedimiento por el que se consiguen imágenes permanentes sobre superficies sensibilizadas por medio de la acción fotoquímica de la luz o de otras formas de energía radiante.

En la sociedad actual la fotografía desempeña un papel importante como medio de información, como instrumento de la ciencia y la tecnología, como una forma de arte y una afición popular. Es imprescindible en los negocios, la industria, la publicidad, el periodismo gráfico y en muchas otras actividades. La ciencia, que estudia desde el espacio exterior hasta el mundo de las partículas subatómicas, se apoya en gran medida en la fotografía. En el siglo XIX era del dominio exclusivo de unos pocos profesionales, ya que se requerían grandes cámaras y placas fotográficas de cristal. Sin embargo, durante las primeras décadas del siglo XX, con la introducción de la película y la cámara portátil, se puso al alcance del público en general. En la actualidad, la industria ofrece una gran variedad de cámaras y accesorios para uso de fotógrafos aficionados y profesionales. Esta evolución se ha producido de manera paralela a la de las técnicas y tecnologías del cinematógrafo. Véase Historia de la fotografía.

Principios básicos

La luz es el componente esencial en la fotografía, que en casi todas sus formas se basa en las propiedades fotosensibles de los cristales de haluros de plata, compuestos químicos de plata y halógenos (bromuro, cloruro y yoduro). Cuando la película fotográfica, que consiste en una emulsión (capa fina de gelatina) y una base de acetato transparente de celulosa o de poliéster, se expone a la luz, los cristales de haluros de plata suspendidos en la emulsión experimentan cambios químicos para formar lo que se conoce como imagen latente de la película. Al procesar ésta con una sustancia química llamada revelador, se forman partículas de plata en las zonas expuestas a la luz. Cuanto más intensa sea la exposición, mayor número de partículas se crearán. La imagen que resulta de este proceso se llama negativo porque los valores de los tonos del objeto fotografiado se invierten, es decir, que las zonas de la escena que estaban relativamente oscuras aparecen claras y las que estaban claras aparecen oscuras. Los valores de los tonos del negativo se vuelven a invertir en el proceso de positivado, o con las diapositivas en un segundo proceso de revelado.

La fotografía se basa, por lo tanto, en principios físicos y químicos. Los principios físicos se rigen por la óptica, es decir, la física de la luz. El término genérico luz se refiere a la parte visible del espectro electromagnético, que incluye además ondas de radio, rayos gamma, rayos X, infrarrojos y ultravioletas. El ojo humano solamente percibe una estrecha banda de longitudes de onda, el espectro visible. Este espectro comprende toda la gama de colores. La mayor longitud de onda visible corresponde al rojo y la menor al azul.

Película fotográfica

Las películas fotográficas varían en función de su reacción a las diferentes longitudes de onda de la luz visible. Las primeras películas en blanco y negro eran sólo sensibles a las longitudes de onda más cortas del espectro visible, es decir, a la luz percibida como azul. Más tarde se añadieron tintes de color a la emulsión de la película para conseguir que los haluros de plata fueran sensibles a la luz de otras longitudes de onda. Estos tintes absorben la luz de su propio color. La película ortocromática supuso la primera mejora de la película de sensibilidad azul, ya que incorporaba tintes amarillos a la emulsión, que eran sensibles a todas las longitudes de onda excepto a la roja.

A la película pancromática, que fue el siguiente gran paso, se le añadieron en la emulsión tintes de tonos rojos, por lo que resultó sensible a todas las longitudes de onda visibles. Aunque ligeramente menos sensible a los tonos verdes que la ortocromática, reproduce mejor toda la gama de colores. Por eso, la mayoría de las películas utilizadas por aficionados y profesionales en la actualidad son pancromáticas.