Informática

Historia de la Informática

EL ABACO

Quizá fue el primer dispositivo mecánico de contabilidad que existió. Se ha calculado que tuvo su origen hace al menos 5,000 años y su efectividad ha soportado la prueba del tiempo.

LA PASCALINA

El inventor y pintor Leonardo Da Vinci (1452-1519) trazó las ideas para una sumadora mecánica. Siglo y medio después, el filósofo y matemático francés Blaise Pascal (1623-1662) por fin inventó y construyó la primera sumadora mecánica. Se le llamo Pascalina y funcionaba como maquinaria a base de engranes y ruedas. A pesar de que Pascal fue enaltecido por toda Europa debido a sus logros, la Pascalina, resultó un desconsolador fallo financiero, pues para esos momentos, resultaba más costosa que la labor humana para los cálculos aritméticos.

LA LOCURA DE BABBAGE

Charles Babbage (1793-1871), visionario inglés y catedrático de Cambridge, hubiera podido acelerar el desarrollo de las computadoras si él y su mente inventiva hubieran nacido 100 años después. Adelantó la situación del hardware computacional al inventar la "máquina de diferencias", capaz de calcular tablas matemáticas.

En 1834, cuando trabajaba en los avances de la máquina de diferencias Babbage concibió la idea de una "máquina analítica". En esencia, ésta era una computadora de propósitos generales. Conforme con su diseño, la máquina analítica de Babbage podía sumar, substraer, multiplicar y dividir en secuencia automática a una velocidad de 60 sumas por minuto. El diseño requería miles de engranes y mecanismos que cubrirían el área de un campo de fútbol y necesitaría accionarse por una locomotora.

Los escépticos le pusieron el sobrenombre de "la locura de Babbage". Charles Babbage trabajó en su máquina analítica hasta su muerte. Los trazos detallados de Babbage describían las características incorporadas ahora en la moderna computadora electrónica. Si Babbage hubiera vivido en la era de la tecnología electrónica y las partes de precisión, hubiera adelantado el nacimiento de la computadora electrónica por varías décadas.

Irónicamente, su obra se olvidó a tal grado, que algunos pioneros en el desarrollo de la computadora electrónica ignoraron por completo sus conceptos sobre memoria, impresoras, tarjetas perforadas y control de programa secuencial.

LA PRIMERA TARJETA PERFORADA

El telar de tejido, inventado en 1801 por el Francés Joseph-Marie Jackard (1753-1834), usado todavía en la actualidad, se controla por medio de tarjetas perforadas. El telar de Jackard opera e la manera siguiente: las tarjetas se perforan estratégicamente y se acomodan en cierta secuencia para indicar un diseño de tejido en particular.

Charles Babbage quiso aplicar el concepto de las tarjetas perforadas del telar de Jackard en su motor analítico. En 1843 Lady Ada Augusta Lovelace sugirió la idea de que las tarjetas perforadas pudieran adaptarse de manera que propiciaran que el motor de Babbage repitiera ciertas operaciones. Debido a esta sugerencia algunas personas consideran a Lady Lovelace la primera programadora. Herman Hollerit (1860-1929) La oficina de censos estadounidense no terminó el censo de 1880 sino hasta 1888. La dirección de la oficina ya había llegado a la conclusión de que el censo de cada diez años tardaría mas que los mismo 10 años para terminarlo.

La oficina de censos comisionó al estadístico Herman Hollerit para que aplicara su experiencia en tarjetas perforadas y llevara a cabo el censo de 1890. Con el procesamiento de las tarjetas perforadas y el tabulador de tarjetas perforadas de Hollerit, el censo se terminó en sólo 3 años y la oficina se ahorró alrededor de $5,000,000 de dólares. Así empezó el procesamiento automatizado de datos.

Hollerit no tomó la idea de las tarjetas perforadas del invento de Jackard, sino de la "fotografía de perforación" Algunas líneas ferroviarias de la época expedían boletos con descripciones físicas del pasajero; los conductores hacían orificios en los boletos que describían el color de cabello, de ojos y la forma de nariz del pasajero. Eso le dio a Hollerith la idea para hacer la fotografía perforada de cada persona que se iba a tabular.

Hollertih fundó la Tabulating Machine Company y vendió sus productos en todo el mundo. La demanda de sus máquinas se extendió incluso hasta Rusia. El primer censo llevado a cabo en Rusia en 1897, se registró con el Tabulador de Hollerith. En 1911, la Tabulating Machine Company, al unirse con otras Compañías, formó la Computing-Tabulating-Recording-Company.

LAS MAQUINAS ELECTROMECANICAS DE CONTABILIDAD

Los resultados de las máquinas tabuladoras tenían que llevarse al corriente por medios manuales, hasta que en 1919 la Computing-Tabulating-Recording-Company. anunció la aparición de la impresora/listadora. Esta innovación revolucionó la manera en que las Compañías efectuaban sus operaciones. Para reflejar mejor el alcance de sus intereses comerciales, en 1924 la Compañía cambió el nombre por el de international Bussines Machines Corporation (IBM).

Durante décadas, desde mediados de los cincuentas la tecnología de las tarjetas perforadas se perfeccionó con la implantación de más dispositivos con capacidades más complejas. Dado que cada tarjeta contenía en general un registro (Un nombre, dirección, etc) el procesamiento de la tarjeta perforada se conoció también como procesamiento de registro unitario.

La familia de las máquinas electromecánicas de contabilidad (EAM) eloctromechanical accounting machine de dispositivos de tarjeta perforada comprende: la perforadora de tarjetas, el verificador, el reproductor, la perforación sumaria, el intérprete, el clasificador, el cotejador, el calculador y la máquina de contabilidad.

El operador de un cuarto de máquinas en una instalación de tarjetas perforadas tenía un trabajo que demandaba mucho esfuerzo físico. Algunos cuartos de máquinas asemejaban la actividad de una fábrica; las tarjetas perforadas y las salidas impresas se cambiaban de un dispositivo a otro en carros manuales, el ruido que producía eran tan intenso como el de una planta ensambladora de automóviles.

ATANASOFF Y BERRY

Una antigua patente de un dispositivo que mucha gente creyó que era la primera computadora digital electrónica, se invalidó en 1973 por orden de un tribunal federal, y oficialmente se le dio el crédito a John V. Atanasoff como el inventor de la computadora digital electrónica. El Dr. Atanasoff, catedrático de la Universidad Estatal de Iowa, desarrolló la primera computadora digital electrónica entre los años de 1937 a 1942. Llamó a su invento la computadora Atanasoff-Berry, ó solo ABC (Atanasoff Berry Computer). Un estudiante graduado, Clifford Berry, fue una útil ayuda en la construcción de la computadora ABC.

Algunos autores consideran que no hay una sola persona a la que se le pueda atribuir el haber inventado la computadora, sino que fue el esfuerzo de muchas personas.

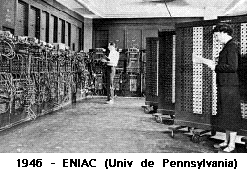

Mauchly y Eckert, después de varias conversaciones con el Dr. Atanasoff, leer apuntes que describían los principios de la computadora ABC y verla en persona, el Dr. John W. Mauchly colaboró con J.Presper Eckert, Jr. para desarrollar una máquina que calculara tablas de trayectoria para el ejército estadounidense. El producto final, una computadora electrónica completamente operacional a gran escala, se terminó en 1946 y se llamó ENIAC (Electronic Numerical Integrator And Computer), ó Integrador numérico y calculador electrónico. La ENIAC construida para aplicaciones de la Segunda Guerra mundial, se terminó en 30 meses por un equipo de científicos que trabajan bajo reloj.

La ENIAC, mil veces más veloz que sus predecesoras electromecánicas, irrumpió como un importante descubrimiento en la tecnología de la computación. Pesaba 30 toneladas y ocupaba un espacio de 450 mts cuadrados, llenaba un cuarto de 6 m x 12 m y contenía 18,000 bulbos, tenía que programarse manualmente conectándola a 3 tableros que contenían más de 6,000 interruptores.

Ingresar un nuevo programa era un proceso muy tedioso que requería días o incluso semanas. A diferencia de las computadoras actuales que operan con un sistema binario (0,1) la ENIAC operaba con uno decimal (0,1,2..9).

La ENIAC requería una gran cantidad de electricidad. La leyenda cuenta que la ENIAC, construida en la Universidad de Pennsilvania, bajaba las luces de Filadelfia siempre que se activaba. La imponente escala y las numerosas aplicaciones generales de la ENIAC señalaron el comienzo de la primera generación de computadoras.

En 1945, John von Neumann, que había trabajado con Eckert y Mauchly en la Universidad de Pennsylvania, publicó un artículo acerca del almacenamiento de programas. El concepto de programa almacenado permitió la lectura de un programa dentro de la memoria de la computadora, y después la ejecución de las instrucciones del mismo sin tener que volverlas a escribir. La primera computadora en usar el citado concepto fue la la llamada EDVAC (Eletronic Discrete-Variable Automatic Computer, es decir computadora automática electrónica de variable discreta), desarrollada por Von Neumann, Eckert y Mauchly.

Los programas almacenados dieron a las computadoras una flexibilidad y confiabilidad tremendas, haciéndolas más rápidas y menos sujetas a errores que los programas mecánicos. Una computadora con capacidad de programa almacenado podría ser utilizada para varias aplicaciones cargando y ejecutando el programa apropiado.

Hasta este punto, los programas y datos podrían ser ingresados en la computadora sólo con la notación binaria, que es el único código que las computadoras "entienden". El siguiente desarrollo importante en el diseño de las computadoras fueron los programas intérpretes, que permitían a las personas comunicarse con las computadoras utilizando medios distintos a los números binarios.

En 1952 Grace Murray Hoper una oficial de la Marina de E.U., desarrolló el primer compilador, un programa que puede traducir enunciados parecidos al inglés en un código binario comprensible para la maquina llamado COBOL (COmmon Business-Oriented Languaje).

Primera Generación (1951 a 1958)

Las computadoras de la primera Generación emplearon bulbos para procesar información. Los operadores ingresaban los datos y programas en código especial por medio de tarjetas perforadas. El almacenamiento interno se lograba con un tambor que giraba rápidamente, sobre el cual un dispositivo de lectura/escritura colocaba marcas magnéticas. Esas computadoras de bulbos eran mucho más grandes y generaban más calor que los modelos contemporáneos.

Eckert y Mauchly contribuyeron al desarrollo de computadoras de la 1era Generación formando una compañía. privada y construyendo UNIVAC I, que el Comité del censo utilizó para evaluar el censo de 1950. La IBM tenía el monopolio de los equipos de procesamiento de datos a base de tarjetas perforadas y estaba teniendo un gran auge en productos como rebanadores de carne, básculas para comestibles, relojes y otros artículos; sin embargo no había logrado el contrato para el Censo de 1950.

Comenzó entonces a construir computadoras electrónicas y su primera entrada fue con la IBM 701 en 1953. Después de un lento pero exitante comienzo la IBM 701 se conviertió en un producto comercialmente viable. Sin embargo en 1954 fue introducido el modelo IBM 650, el cual es la razón por la que IBM disfruta hoy de una gran parte del mercado de las computadoras. La administración de la IBM asumió un gran riesgo y estimó una venta de 50 computadoras. Este número era

mayor que la cantidad de computadoras instaladas en esa época en E.U. De hecho la IBM instaló 1000 computadoras. El resto es historia. Aunque caras y de uso limitado las computadoras fueron aceptadas rápidamente por las Compañias privadas y de Gobierno. A la mitad de los años 50 IBM y Remington Rand se consolidaban como líderes en la fabricación de computadoras.

Segunda Generación (1959-1964)

El invento del transistor hizo posible una nueva Generación de computadoras, más rápidas, más pequeñas y con menores necesidades de ventilación. Sin embargo el costo seguía siendo una porción significativa del presupuesto de una Compañia. Las computadoras de la segunda generación también utilizaban redes de nucleos magnéticos en lugar de tambores giratorios para el almacenamiento primario. Estos núcleos contenían pequeños anillos de material magnético, enlazados entre sí, en los cuales podían almacenarse datos e instrucciones.

Los programas de computadoras también mejoraron. El COBOL desarrollado durante la 1era generación estaba ya disponible comercialmente. Los programas escritos para una computadora podían transferirse a otra con un mínimo esfuerzo. El escribir un programa ya no requería entender plenamente el hardware de la computación. Las computadoras de la 2da Generación eran sustancialmente más pequeñas y rápidas que las de bulbos, y se usaban para nuevas aplicaciones, como en los sistemas para reservación en líneas aéreas, control de tráfico aéreo y simulaciones para uso general . Las empresas comenzaron a aplicar las computadoras a tareas de almacenamiento de registros, como manejo de inventarios, nómina y contabilidad.

La marina de E.U. utilizó las computadoras de la Segunda Generación para crear el primer simulador de vuelo. (Whirlwind I). HoneyWell se colocó como el primer competidor durante la segunda generación de computadoras. Burroughs, Univac, NCR, CDC, HoneyWell, los más grandes competidores de IBM durante los 60s se conocieron como el grupo BUNCH.

Tercera Generación (1964-1971)

Circuitos Integrados, Compatibilidad con Equipo Mayor,

Multiprogramación, Minicomputadora

Las computadoras de la tercera generación emergieron con el desarrollo de los circuitos integrados (pastillas de silicio) en las cuales se colocan miles de componentes electrónicos, en una integración en miniatura. Las computadoras nuevamente se hicieron más pequeñas, más rápidas, desprendían menos calor y eran energeticamente más eficientes.

Antes del advenimiento de los circuitos integrados, las computadoras estaban diseñadas para aplicaciones matemáticas o de negocios, pero no para las dos cosas. Los circuitos integrados permitieron a los fabricantes de computadoras incrementar la flexibilidad de los programas, y

estandarizar sus modelos.

La IBM 360 una de las primeras computadoras comerciales que usó circuitos integrados, podía realizar tanto análisis numéricos como administración ó procesamiento de archivos.

Los clientes podían escalar sus sistemas 360 a modelos IBM de mayor tamaño y podían todavia correr sus programas actuales. Las computadoras trabajaban a tal velocidad que proporcionaban la capacidad de correr más de un programa de manera simultánea (multiprogramación).

Por ejemplo la computadora podia estar calculando la nomina y aceptando pedidos al mismo tiempo. Minicomputadoras, Con la introducción del modelo 360 IBM acaparó el 70% del mercado, para evitar competir directamente con IBM la empresa Digital Equipment Corporation DEC redirigió sus esfuerzos hacia computadoras pequeñas. Mucho menos costosas de comprar y de operar que las computadoras grandes, las minicomputadoras se desarrollaron durante la segunda generación pero alcanzaron su mayor auge entre 1960 y 70.

Cuarta Generación 1971

Microprocesador , Chips de memoria, Microminiaturización

Dos mejoras en la tecnología de las computadoras marcan el inicio de la cuarta generación: el reemplazo de las memorias con núcleos magnéticos, por las de chips de silicio y la colocación de Muchos más componentes en un Chip: producto de la microminiaturización de los circuitos electrónicos. El tamaño reducido del microprocesador y de chips hizo posible la creación de las computadoras personales (PC)

Hoy en dia las tecnologías LSI (Integración a gran escala) y VLSI (integración a muy gran escala) permiten que cientos de miles de componentes electrónicos se almacenen en un chip. Usando VLSI, un fabricante puede hacer que una computadora pequeña rivalice con una computadora de la primera generación que ocupara un cuarto completo.

Quinta Generación.

En vista de la acelerada marcha de la microelectrónica, la sociedad industrial se ha dado a la tarea de poner también a esa altura el desarrollo del software y los sistemas con que se manejan las computadoras. Surge la competencia internacional por el dominio del mercado de la computación, en la que se perfilan dos líderes que, sin embargo no han podido alcanzar el nivel que se desea: la capacidad de comunicarse con la computadora en un lenguaje más cotidiano y no a través de códigos o lenguajes de control especializados.

Japón lanzó en 1983 el llamado "programa de la quinta generación de computadoras", con los objetivos explícitos de producir máquinas innovaciones reales en los criterios mencionados. Y en los Estados Unidos ya está en actividad un programa en desarrollo que persigue objetivos semejantes, que pueden resumirse de la siguiente manera:

-

Procesamiento en paralelo mediante arquitecturas y diseños especiales y circuitos de gran velocidad.

-

Manejo de lenguaje natural y sistemas de inteligencia artificial.

El futuro previsible de la computación es muy interesante, y se puede esperar que esta ciencia siga siendo objeto de atención prioritaria de gobiernos y de la sociedad en su conjunto.

Modelo de Von Neumann.

Las computadoras digitales actuales se ajustan al modelo propuesto por el matemático John Von Neumann. De acuerdo con él, una característica importante de este modelo es que tanto los datos como los programas, se almacenan en la memoria antes de ser utilizados.

Actualidad.

Hoy en día el numero de microprocesadores, así como el de fabricantes de estos se ha incrementado enormemente. Intel, creador del primer micro, conserva solo el liderazgo en la gama de ordenadores "compatibles IBM-PC", estando el mercado profesional dominado por otros fabricantes. He de decir que en el mercado de los PC, también Intel se esta viendo terriblemente acosada, tras el fallo de sus Pentium, en la unidad de coma flotante, las cosas no han ido muy bien. Desde el nacimiento del 8086, para el primer IBM-PC, y su versión recortada, el 8088, Intel a tenido que luchar contra otras empresas, que viendo las carencias de los micros de Intel, se pusieron manos a la obra para el desarrollo de otros dispositivos. Tal es el caso de AMD, la cual, lleva fabricando Coprocesadores para IBM-PC, casi desde el nacimiento de este, con lo que Intel, para evitar posibles competencias, pacto con AMD, para el intercambio de tecnología y creación de un nuevo micro, el 486, con coprocesador matemático incluido en la pastilla del micro, esto trajo mucha tela, ya que AMD, se vio engañada, pues más que intercambio de tecnología, fue copia de sus técnicas de construcción de Coprocesadores, lo que trajo incontables juicios entre ambas empresas, sin un final claro.

A partir de entonces, AMD, que sus vio barbas remojar, se dedico a potenciar la producción de micros compatibles x86, (que ya fabricaba desde el 286), consiguiendo lo que hoy a dado a llamar AMD K6, un micro compatible x86, con una estructura que solo los P2 de Intel incluyen, (algunas ni eso) a un precio ridículo, con una cache de primer orden superior incluso al P2. Entre sus proyectos venideros se incluye, el lanzamiento de una versión mejorada de K6, llamada K6 3D, con aceleración Direct 3D y MPG2, y unas velocidades iniciales de 300, 350, y puede que 400. Esto será para la primera mitad del 1998, pero del futuro de cada casa hablaremos más tarde.

Otra empresa creadora de compatibles x86 es Cyris, que con su 6x86 se acerca a los Intel y AMD, pero no superandolos en rendimiento. Y la sorpresa del verano de 1997, fue el Centaur, un micro, compatible 586 MMX, a un precio ridículo, este ultimo, que cosecho razonables ventas en EE.UU. no llego a España (vete tu a saber porque).

LLegados aquí, retomo el tema de Intel, y su no tan buena situación. El PentumPro, el sustituto de Pentium normal, no llego a implantarse en el mercado de consumo (verdadera fuente de ingresos de Intel) por una razón, al ejecutar instrucciones de 16 Bits, su rendimiento apenas superaba a sus hermanos pequeños. Esto, unido a la situación que presentaba el mercado de los sistemas operativos PC, no convenció al mercado, que no lo implanto como estándar (Se dice que fue la propia Microsoft, la que metió mano, pues no podía permitir que sus sistemas operativos Windows 3.11, y 95, con código de 16 Bits, se vieran marginados frente a los auténticos de 32 Bits, como OS/2 Warp, UNIX, Linux,... que se verían potenciados), pasando a ser "renombrado" como micro para aplicaciones profesional, donde tampoco tiene mucha ventajas, pues por su precio, junto con la de sus placas (recordemos que necesita una placa especial para el), no podía competir con los ALPHA o MIPS. En este momento, al sentirse en una situación de perdida de mercado, Intel saco lo que según el, seria la revolución multimedia, los MMX, micros con un juego de 57 nuevas instrucciones, diseñadas para acelerar la ejecución de aplicaciones multimedia, y alguna mejora más (como el incremento de la cache interna del micro), pero sin el inconveniente de ejecutar mejor código de 32 que de 16 Bits. Lo que permitió a Intel no perder tanto mercado que con el PentiumPro. Este micro, verdadero "parche" para Intel, se ha implantado rápidamente, por no ser un salto tan grande con su generación anterior, y permitir esto, usar las placas con Socket 7 (el conector de 586 normal) para su implementación.

Metiendonos en otros fabricantes, nos encontramos con Motorola, la cual, con su M68000 y familia, a conseguido un éxito más que merecido, este micro, RISC, con solo 7.14 MHz, fue la base para la creación de computadoras rapidísimas (para su época) como los primero MAC, Atari St, y Amiga, tiene un bus de datos de 16 Bits y uno de direcciones de 32 Bits pudiendo direccionar hasta 16 Mb de memoria (todo un récord para aquel entonces), hay van más datos de el. 17 registros de 32 Bits de datos y direcciones, acceso directo a un rango de direcciones de 16Mb, también llamado DMA, (lo que hoy es una novedad en los Pentium), 14 modos de direccionamiento, entrada/salida mapeada en memoria..., esto hace que aun en día se encuentren 68000 en controladoras de disco llamados "inteligentes" y otros dispositivos, pues es muy económico y potente. Pero la familia 680x0 no acabo aquí (es solo el principio), le siguió el 68010, que compartía patillaje con el 68000, pudiendo intercambiarse ambos, y con una mejora del 30% en rendimiento. Ha esto le siguió el 68020, completo micro de 32 Bits, y con una cache interna de 256Kb, esta versión a 14MHz, permitía usar 4Gb de RAM!!!, así como arquitectura segmentada, que permite ejecutar varias instrucciones simultáneamente, y otras maravillas (no olvidemos su compatibilidad con el 68000). El siguiente eslabón fue el... SI!!! 68030 (como lo has sabido ;-), similar al 68020, pero con capacidad para ejecutar instrucciones concurrentemente, esto es, en paralelo y mientras se accede a las caches internas, el copro o el controlador de buses, dos caches independientes para datos e instrucciones a las que puede acceder simultáneamente, control de acceso a BUS, por tres métodos, Síncrono (2 ciclos), Asíncrono, y Burst (1 ciclo). Y continuamos con la familia 680x0, esta vez con el 68040, a 40MHz, con Coprocesador incluido en el micro, dos caches de 4Kb, y un largo etc. Aquí tenemos que pegar un salto de casi dos generaciones de 680x0 pues el 68050 nunca salió a la luz con ese monbre (dicen que se los quedo en exclusiva Ford, para su automóviles), pasando al 68060, un micro realmente impresionante. Incluye dos caches, dos MMU independientes , (una para datos y otra para instrucciones), dos unidades segmentadas de enteros, unidad de calculo en coma flotante, arquitectura Hardvard (replicación de bloques funcionales), con lo que consigue paralelismo de ejecución múltiples buses internos y unidades independientes de ejecución. El manejo del consumo de corriente es gestionado por el propio CHIP, entrando en bajo consumo solo con ejecutar una instrucción (LPSTOP), diseño estático, (cuando un circuito no se esta usando no consume), ya veis, ideal para un portátil. Este micro funciona a 50MHz, y creo que salió una versión a 66MHz, siendo tres veces más rápido que un 68040.

LLegados a este punto la cadena 680x0 se rompe, dando lugar a un nuevo microprocesador, fruto de un acuerdo entre IBM, Motorola y Apple que crearan un nuevo monstruo, el PowerPC.

El PowerPc, nace como una apuesta de futuro para los Mac, y otros equipos que quieran incorporar un micro de alto rendimiento a un precio moderado, fuera del monopolio de Intel. Este microprocesador, con unas cualidades espectaculares como varias caches internas, y capaz de ejecutar varias instrucciones en un solo ciclo de reloj, es un verdadero RISC, y (preparate) solo consume 5 Vatios!!! esto es imprescindible para construir portátiles de alto rendimiento, comparados con los 60 Vatios del PentiumPro a 200MHz (no se lo que consume el P2, pero imaginate, más que el Pro). Esto demuestra la buena construcción del PowerPC, partiendo de una buena base tecnológica. Hay que tener en cuenta que el calor es el pero enemigo de la electrónica, y el que impide miniaturizar y acelerar los micros, y a mayor consumo... mayor disipación de calor, y sino, echale un ojo al ventilador de tu micro ("pequeñito" ¿eh?). Y sino piensa, ¿Quien se compraría un portátil a 333MHz, como un P2, si la batería no daría para más de media hora?

El PowerPc, además de ser el corazón de los PowerMac, también lo es del nuevo PowerUp, un Amiga, con microprocesador M68060 y un PowerPc trabajando en paralelo (alucinante!), y será implementado en los ordenadores de red, o NetComputer.

Una baza muy importante a favor del PowerPC es la cantidad de sistemas operativos que es capaz de correr, UNIX, Linux, MAC-OS, y como no, Windows NT.

Y vamos ahora con los un micro realmente alucinante. El ALPHA, fabricado por DIGITAL, un todopoderoso RISC, capaz de ejecutar hasta 4 instrucciones por ciclo de reloj, con varias caches incluidas en el micro, entre ellas, la de segundo nivel, todo dentro del micro, ademas de una caché de tercer nivel, incluida en la placa base, las caches de datos e instrucciones son de 8 Kb cada una (No tengo datos actualizados, esto es del los ALPHA 21164) y una caché de 96Kb de segundo orden (recuerda, dentro del micro), la caché de tercer nivel, suele ser de unos 4Mb!!!!. Con dos unidades de ejecución de enteros y dos de coma flotante, consigue ejecutar hasta 4 instrucciones por ciclo. Las unidades de enteros son iguales, pero las de coma flotante son distintas, una especializada en sumas, y la otra en operaciones complejas, todos esto, forma uno de los mejores (sino el mejor) de los micro de 64Bit (recordemos que Intel continua con los 32bit, incluido el P2). En cuanto a las frecuencias de trabajo, el ALPHA, fue el primer micro RISC en superar la barrera de los 200MHz, vendiendose hoy a unos "tranquilos" 500MHz, con un consumo de 40 Vatios, y pronto, pero que muy pronto (puede que este año), saldrá una nueva generación de ALPHA, los 21264, trabajando a 1GHZ!!!!! (oséa 1000MHZ HAAaaaaaa!!). Como nota, intentar haceos a la idea de que entre un ALHPA y un Intel a la misma velocidad (en MHz), el ALPHA da cuatro veces más rendimiento que el Intel.

Otro gran desconocido es el PA-RISC 8500, un micro de 64 bit, fabricado por HP, con arquitectura similar a la de un PowerPC, este micro, consigue en su versión a 180 MHz, un rendimiento tal, que para igualarlo, seria necesario hacer un PentiumPro a 900 MHz (toma esa Intel). Pero el futuro de estos micros es incierto, dado que HP e Intel a acordado unir tecnologías para lo que será el Merced, un prototipo de micro de 64 Bit para compatibles IBM-Pc.

Proyectos Futuros.

El futuro se ve de diferentes maneras, según el micro en que pensemos. Hay van algunos proyectos de distintas casas.:

Empezamos por un compatible x86, AMD y sus K series. El futuro más reciente es la aparición de un K6 con aceleración MPG y Direct 3D, el AMD K6 3D, para el primer semestre del año, (ya lo eh dicho) seguido de el AMD K6 3D III, para el segundo semestre del años, llegando hasta los 500MHz (guau!). Y la historia no se acaba aquí, para el 1999, saldrá el K7, un micro que superara los 600MHz, con una caché de segundo orden incluida dentro del propio micro, llegando a incluir hasta 20 Millones de transistores (Recordemos que un Pentium MMX tiene 4,4 Millones de transistores, y el K6, 8,8 Millones, el doble).

Entre los Proyectos más destacados de ALPHA, esta la comercialización de su ALPHA 21264 a 1 GHz, con más de 20 millones de transistores.

Para Intel el futuro pasa por migrar sus actuales micros de 32 Bit a 64 Bit, pero antes de ello, en 1999 veremos el últimos de sus micros de 32 Bit, el Katmai, este micro incorporara lo que Intel a dado en llamar MMX2 (¿otra vez?) con 70 nuevas instrucciones para la aceleración de render y otros apartados gráficos. Después de Katmai (que llegara hasta los 500 MHZ), marcando una separación entre el mercado domestico y el profesional, con la implementación de un nuevo slot para microprocesadores, el SLOT 2 (otro más). A finales de 1999 (o como todo, para el 2000 ;-) saldrá el Merced, primer micro de 64 Bit, basado en lo que Intel y HP han dado a llamar ISA-64, (Instruction Set Architecture 64).

ÚLTIMOS LANZAMIENTOS:

-

Intel lanza al mercado un Pentium II sin cache, llamado Celeron, destinado principalmente al mercado de consumo.

-

AMD presenta su K6-2, también llamado K6 3D, pues incluye un nuevo juego de instrucciones para acelerar procesos 3D. Este nuevo juego recibe el nombre de 3D Now!. Este micro se montara sobre placas Súper 7 (las mismas que para el K6, Cyris, Winchip y Pentium normal o MMX). Las velocidades a las que se entregara este micro son 266, 300, 350, 366, 380, 400 MHz.

-

El juego de instrucciones 3D Now! es incluido en la ultima generación de micros de Cyris y Winchip.

-

Intel Presenta un Pentium Celeron mejorado, con 128K de cache de nivel 2 (L2) llamado 'Mendocino' o también Celeron A.

-

AMD consigue el apoyo de Microsoft para que las DirectX 6 y superiores hagan uso de las 3D Now!, así como de la industria del videojuego, con la optimización de muchos juegos para este tipo de micros (Quake III, Unreal,Via Voice 98, Incoming, etc.).

-

AMD consigue un acuerdo con las empresas fabricantes de tarjetas gráficas para que el driver de estas este optimizado para 3D Now!, repartiendose el trabajo entre las 3D now! y la tarjeta gráfica, según quien sea el más rápido, consiguiendo así un aumento de prestaciones.

-

SAMSUNG compra derechos a DIGITAL para fabricar micros y placas ALPHA, lo que los hará más accesibles al mercado en general.

-

OpenGL 1.2 utilizara también las 3D Now!.

-

Intel Presenta un micro para estaciones de trabajo, llamado Pentium II Xeon, este micro, sustituto del Pentium Pro (si es que queda alguno) se caracteriza por tener una cache de nivel 2 (L2) de 1024 ó 2048, y permite configuraciones de hasta cuatro micros en una sola placa.

-

25 Febrero 1999 - AMD presenta su K6-III, con 256K de cache L2 incluidas dentro del micro (recordar que el Pentium II y III no la llevan dentro, sino al lado, en la misma placa-tarjeta) al estilo de como Intel nos ofreció su Pentium Pro. Este micro se monta sobre las mismas placas que sus predecesores y saldrá en unas velocidades iniciales de 400 y 450 MHz. Cuenta con la ventaja de poder gestionar tres niveles de cache, sumando así la capacidad de la L1 (64k en los K6 I, II y III y 32k en los Pentium II y III) más la L2 (256 en el K6-III a la misma velocidad que el micro y 512 en los Pentium II y III a la mitad de la velocidad del micro) más la incluida en la placa (Pentium II y III no puede gestionar esta memoria) que podrá ser de más de 2 Mb. Segun AMD un K6-III a 450MHz rinde más que un Pentium III a 500MHz. También incluirá 3D Now!.

-

26 Febrero 1999 - Compag saca al mercado los primeros Compag Presario K6-III a 400 y 450 MHz.

-

28 Febrero 1999 - Intel presenta su Pentium III (antes llamados Katmai) y Pentium III Xeon (Tanner) con un nuevo juego de instrucciones al que ya se le conoce como MMX 2. Los micros estarán disponibles en el mercado con unas velocidades iniciales de 400, 450, 500, 550 y 600 MHz para finales de año.

-

Abril 1999 - Por primera vez en las ultimas décadas AMD ha superado en ventas de procesadores a Intel, durante el mes de Enero de 1999. Según PC DAT, una empresa Americana encargada de realizar estadísticas relacionadas con los ordenadores, durante Enero de 1999 AMD vendió el 43.9% de todos los procesadores para PC en Estados Unidos, superando en varios puntos a los micros de Intel.

-

7 Abril 1999 - AMD declara en la 'Windows Hardware Engineering Conference and Exhibition (WINHEX 99) que el lanzamiento de K7 será en JUNIO 1999. A continuación se muestra una imagen de un prototipo

-

Mayo 1999 - Intel lanza los Mendocino (Celeron A) en formato PPGA, para un nuevo conector de placa llamado 'Socket 370', muy similar en apariencia al Socket 7, pero incompatible entre si, evitando así que se monten Celeron 'Overclokeados' en Slot 1 y evitar quitar mercado a sus Pentium II/III.

-

Junio 1999 - AMD lanza el K7, cuyo nombre en final es ATHLON, sale al mercado con unas frecuencias de trabajo de 500, 550 y 600 MHz. Tiene una cache de primer nivel de 128Kb y de segundo nivel de 512Kb ampliable hasta 8 Mb. Por primera vez es capaz de trabajar en multiproceso, en configuraciones de 2, 4, 8 y se espera que 16 microprocesadores en la misma placa. Es el primer micro con un coprocesador Super-escalar, y ofrece un rendimiento superior al Pentium III Xeon.

1

Descargar

| Enviado por: | Cesar Jimenez |

| Idioma: | castellano |

| País: | Colombia |