Informática

Periféricos de un Ordenador

Descripción de los Periféricos

1. INTRODUCCIÓN

Se denominan periféricos tanto a las unidades o dispositivos a través de los cuales el ordenador se comunica con el mundo exterior, como a los sistemas que almacenan o archivan la información, sirviendo de memoria auxiliar de la memoria principal. Se entenderá por periférico a todo conjunto de dispositivos que, sin pertenecer al núcleo fundamental de la CPU-Memoria Central, permitan realizar operaciones de E/S, complementarias al proceso de datos que realiza la CPU (Fig.1).

Figura 1. El PC y sus periféricos

Según la definición, éstos están constituidos por unidades de entrada, unidades de salida y unidades de memoria masiva auxiliar. Estas últimas unidades también pueden considerarse como unidades de E/S, ya que el ordenador central puede escribir (dar salidas) sobre ellas, y la información escrita puede ser leída, es decir, ser dada como entrada. Ahora bien, la información grabadas en estos soportes no es directamente inteligible para el usuario de la ordenador, esto es, no puede haber una intercomunicación directa usuario-ordenador como la que hay a través de un teclado-pantalla.

El ordenador es una máquina que no tendría sentido si no se comunicase con el exterior, es decir, si careciese de periféricos. Por lo que debe disponer de:

- Unidades de entrada, a través de las cuales poderle dar los programas que deseemos que ejecute y los datos correspondientes. Unidades de salida, con las que el ordenador nos dé los resultados de los programas.

- Memoria masiva o auxiliar, que facilite su funcionamiento y utilización.

Los dispositivos de E/S transforman la información externa en señales codificadas, permitiendo su transmisión, detección, interpretación, procesamiento y almacenamiento de forma automática.

2. PERIFÉRICOS INTERACTIVOS CON EL USUARIO

2.1. TECLADO

Permite la introducción de información en el ordenador. Su estructura consiste en una matriz de contactos, estando asociado cada uno de éstos a una tecla determinada (ver fig. 2.2.). La pulsación de una tecla cierra su contacto, lo que se detecta por métodos electrónicos de exploración sistemática de la matriz. Entonces se realiza la conversión de la posición de cierre a su código alfanumérico asociado, enviándose dicho código al ordenador, En la mayoría de los casos se producirá un almacenamiento intermedio de los códigos en un buffer. Los caracteres tecleados se presentarán por pantalla, con objeto de mejorar la comunicación con el usuario.

Figura 2.1. Interfaces del ratón y del teclado

El teclado es un periférico de entrada de comunicación lenta (a lo sumo varios caracteres por segundo). Para este tipo de dispositivos, la estandarización es prácticamente total, aunque existan pequeñas variaciones respecto de la ubicación de algunas teclas.

Figura 2.2. Estructura electrónica del teclado

2.1.1. LA ELECCIÓN DEL TECLADO

En los teclados existen dos tecnologías que controlan la pulsación de las teclas, así tenemos los teclados que funcionan por: contacto capacitivo (de membrana) o por contacto mecánico.

Los teclados mecánicos constan de una serie de teclas con unos interruptores mecánicos colocadas encima de unos muelles, que son los que hacen retornar las teclas a la posición original, de modo que al ser pulsadas éstas hacen contacto con unas terminaciones metálicas del circuito impreso del propio teclado, cerrando así el circuito, y volviendo a abrirlo al dejar de pulsar por el efecto de retorno del muelle. El contacto establecido entre los terminales metálicos de las teclas y el del circuito impreso determina la señal diferenciada.

Los teclados de membrana se componen de cuatro capas: la inferior tiene una serie de pistas conductores impresas; encima de ella, se coloca una capa de separación con agujeros justo debajo de cada una de las teclas; encima de esta se coloca una capa conductora con pequeñas montañitas debajo de cada una de las teclas y en cada montañita un conector metálico; encima de éstas se coloca una capa de goma para producir el efecto de retorno a la posición inicial. Cuando pulsamos una tecla, lo que hacemos es poner en contacto las dos capas conductoras (la primera con el circuito y la tercera con los conectores) haciendo que el circuito se cierre, y la membrana de goma hace que se separen las capas al impulsar la tecla hacia su posición inicial.

Sin embargo, los teclados mecánicos suelen requerir una pulsación más suave y con una fuerza continuada, aunque la profundidad de hundimiento de cada tecla puede hacerlo más o menos agradable dependiendo de la velocidad (pulsaciones por minuto) que queremos alcanzar al escribir. Por el contrario, los teclados de membrana requieren una mayor fuerza en el tramo final de la pulsación para vencer la resistencia de la capa de goma de cubre las capas puramente electrónicas. Esta mayor resistencia no supone un óbice para aquellas personas no acostumbradas a un teclado profesional de máquina de escribir eléctrica, dándoles mayor seguridad y provocando un menor número de errores al pulsar las teclas contiguas. Debemos recordar, sin embargo, que el teclado de membrana aguanta peor el paso del tiempo y el uso continuado, dando lugar a que ciertas teclas más usadas pierdan parte de esa resistencia a la pulsación, con la consiguiente desigualdad que notaremos al escribir e incluso llegando al extremo de que ciertas teclas puedan quedar pulsadas por la pérdida de capacidad de retorno de ciertas zonas de la membrana de goma.

Teclados ergonómicos

Se basan en el principio que dividiendo el teclado principal colocando en ángulo cada una de las mitades, los codos descansan en una posición mucho más natural, y cambiando la curvatura del teclado y añadiendo un pequeño “reposamuñecas”, el ángulo de escritura es mucho más cómodo para el usuario. Pero tienen una desventaja, y es que hace falta acostumbrarse a una disposición de teclas muy diferente, y si por diversos motivos debemos utilizar también teclados normales (en el trabajo, etc.), no acabaremos de habituarnos nunca.

Teclados programables

El propio teclado lleva un microcontrolador interno (que se comunica con la controladora de teclado de la placa base) con un programa integrado que interpreta las señales producidas al cerrarse el circuito cuando dos terminales (tecla y circuito integrado) entran en contacto. Este programa reside en una ROM, la cual puede almacenar muchos otros datos, además del código del teclado (país) y la posición de las teclas, pero para interpretarlos, se ha de instalar un driver o controlador del dispositivo que interprete las señales. Un Driver (conductor) es suministrado por el fabricante y tiene como función asegurar la compatibilidad, el buen funcionamiento y el uso de las características que dicho dispositivo ofrece. Un driver normalmente está desarrollado para un sistema operativo específico y no funcionará bajo otros entornos.

La mayoría de los teclados que se venden actualmente tienen teclas específicas para WINDOWS 9x, que son interpretadas por el propio sistema operativo sin un driver adicional, pero existen teclados desde los cuales podemos manejar parámetros concernientes al sonido, la reproducción de CDs musicales, etc. Recientemente han aparecido en el mercado teclados con teclas adicionales programables sin una función específica, a las que nosotros podremos asignar la ejecución de nuestras aplicaciones favoritas, el guardado de documentos, impresión, etc.

Teclados inalámbricos

Pueden fallar si están mal orientados, pero no existe diferencia con un teclado normal. En vez de enviar la señal mediante cable, lo hacen mediante infrarrojos, y la controladora no reside en el propio teclado, sino en el receptor que se conecta al conector de teclado en el PC.

Si queremos conectar a nuestro equipo un teclado USB, primero debemos tener una BIOS que lo soporte y en segundo lugar debemos tener instalado el sistema operativo con el “Suplemento USB”. Un buen teclado USB debe tener en su parte posterior al menos un conector USB adicional para poderlo aprovechar como HUB y poder conectar a él otros dispositivos USB como ratones, altavoces, etc.

2.2. SISTEMA DE VIDEO

Funcionalmente, el sistema de vídeo de un ordenador es un dispositivo de salida. Actualmente, estos sistemas se han convertido en algo más que los simples circuitos presentadores de textos de los primeros ordenadores personales, incapaces de representar gráficos sobre la pantalla, habiendo experimentado una rápida y constante evolución, lo que ha creado cierta confusión, debido a las diferentes especificaciones de los distintos sistemas de vídeo existentes, que hace que éstos sean incompatibles entre sí a menudo. La evolución de los sistemas de vídeo ha permitido el desarrollo de gran número de aplicaciones gráficas, que permiten una comunicación más amigable y eficiente entre usuario y ordenador.

El sistema de vídeo, por tanto, permite la presentación de información al usuario, tanto alfanumérica como gráfica. A grandes rasgos consta de un controlador, adaptador o tarjeta de vídeo y un monitor. A continuación nos encargaremos de analizar cualitativamente el funcionamiento de estos elementos.

2.2.1. MONITOR

Representa el soporte en el que se suministra la información visual. En general estará constituido por un tubo de rayos catódicos (CRT), monocromo o de color, aunque es normal encontrar monitores con display de cristal líquido, en sistemas portátiles. Las señales generadas por el controlador o adaptador de vídeo son las que se visualizarán por pantalla. El monitor incorpora controles típicos de brillo y contraste.

El funcionamiento del CRT monocromo consiste en la emisión de un haz de electrones de intensidad variable, deflectado en dos direcciones espaciales perpendiculares entre sí y al haz mediante un campo magnético generado por unas bobinas que rodean al eje del haz (ver fig. 2.3.).

La deflexión permite que el haz alcance cualquier punto de una pantalla, perpendicular a su trayectoria, que está revestida de un material fosforescente, sensible al impacto de dicho haz, siendo el grado de iluminación proporcional a la intensidad del mismo. Podemos imaginar a la pantalla dividida en puntos o píxeles (picture elements), cada uno de ellos con capacidad de iluminación independiente. Del número y tamaño de los píxeles dependerá la resolución de la pantalla. La resolución es el numero de píxeles que se pueden presentar en pantalla horizontal y verticalmente manteniendo normalmente una relación 3/4 para compensar el tamaño rectangular de la pantalla para que así el píxel sea cuadrado. Si cada píxel viene representado en memoria por N bits, 2N será el número de tonos de gris que puede adoptar. En realidad la resolución de la pantalla dependerá de las características del cañón de electrones y de las señales que reciba el monitor desde el adaptador de vídeo. Normalmente un monitor soportará varias resoluciones, estando limitado a una máxima.

Figura 2.3. Fundamento del CRT.

En el caso de un monitor en color se tienen tres haces de electrones, constando cada píxel de una tríada de puntos luminiscentes rojo, verde y azul sobre el fósforo de la pantalla. Mediante una máscara se consigue que cada haz ilumine sólo los puntos correspondientes a un color primario. La mezcla de los distintos grados de brillo de cada color primario en cada píxel produce el efecto de color. Si cada punto necesita un almacenamiento en memoria de N bits, M= 2N será el número de tonos de intensidad de color primario por punto, lo que permitirá M3 colores distintos por píxel. A efectos prácticos puede uno imaginarse un único haz electrónico con su propia intensidad y color, incidiendo sobre la pantalla.

El dot pitch o tamaño del punto es la distancia existente entre dos

puntos adyacentes. Cuanto menor sea esa distancia mejor definición

tendrá la imagen. No obstante la forma de medir la distancia entre los puntos

varia en función de la tecnología empleada en el monitor. Un punto 0,25 mm

de Trinitron equivale a un 0,28 mm en un máscara de

sombra. Los tamaños más adecuados será

como mínimo de 0,28 mm para modelos de 14 y 15 pulgadas y de 0,31 mm

para modelos de 17 pulgadas o superiores.

El monitor de un ordenador difiere de un monitor de TV doméstico en que las señales de color y temporización, producidas por el adaptador de vídeo, van por separado, lo que permite una mejor definición de texto y color, respecto de la señal composite (compuesta de sincronización, color y audio) que decodifica el receptor de TV. De todos modos hay adaptadores de vídeo que permiten generar salidas compatibles con monitores de TV, aunque ésta no suele ser la solución adoptada.

Los monitores son dispositivos de barrido por traza (raster scan). La imagen consta de un grupo de líneas horizontales (raster), cada de ellas compuesta de un número determinado de píxeles. La imagen sobre la pantalla se formará al barrer el haz toda su superficie de una forma sistemática. El adaptador de vídeo modulará la intensidad del haz en cada punto en función de la información a presentar, además de generar las señales de sincronismo adecuadas. Esto diferencia a un monitor de barrido por traza de un monitor vectorial, en el que se manipula el haz para formar directamente los gráficos o caracteres deseados sobre la pantalla (por ejemplo, el monitor de un osciloscopio). Este último tipo de monitores ya está en desuso. Los monitores poseen capacidad de scroll o desplazamiento de la información presentada en pantalla (habitualmente será vertical ascendente).

Hoy en día es habitual que los monitores soporten la “norma DDC” (canal de datos de visualización), una extensión de la norma “plug and play” “Conectar y listo”, la cual permite que la tarjeta gráfica se comunique directamente con el monitor, detectándose mutuamente y ajustando las resoluciones y las frecuencias de refresco máximas sin intervención del usuario. Esto facilita la instalación del monitor, pero en caso de no soportar esta norma, debemos instalar los drivers suministrados con el monitor o ajustar manualmente en la configuración de la tarjeta gráfica las frecuencias de refresco soportadas, atendiendo al manual del monitor. Por último, casi todos los monitores actuales soportan los “Modos VESA de ahorro de energía” (Energy Star), que posibilitan el paso del monitor a modo de ahorro de energía o “Standby”de modo automático tras el espacio de tiempo programado en la BIOS o en el sistema operativo.

La alternativa LCD

La tecnología LCD o cristal líquido, a llegado a citarse como posible alternativa de futuro frente al CRT. Ventajas como el ahorro de consumo y de espacio, así como la prácticamente nula emisión de radiaciones, aportan unas ventajas a estos dispositivos. No obstante, su elevado costo unido a los continuos avances en la tecnología CRT hacen que, por el momento, ésta última sea la opción más recomendable.

Los cristales líquidos, básicamente son sustancias transparentes con cualidades propias de líquidos y de sólidos. Al igual que los sólidos, una luz que atraviesa un cristal líquido sigue el alineamiento de las moléculas, pero al igual que los líquidos, aplicando una carga eléctrica a estos cristales, se produce un cambio en la alineación de las moléculas, y por tanto en el modo en que la luz pasa a través de ellas.

Una pantalla LCD está formada por dos filtros polarizantes con filas de cristales líquidos alineadas perpendicularmente entre sí, de modo que al aplicar o dejar de aplicar una corriente eléctrica a los filtros, se consigue que la luz pase o no pase a través de ellos, según el segundo filtro bloquee o no el paso de la luz que ha atravesado el primero. El color se consigue añadiendo 3 filtros adicionales de color (uno rojo, uno verde, uno azul). Sin embargo, para la reproducción de varias tonalidades de color, se deben aplicar diferentes niveles de brillo intermedios entre luz y no-luz, lo cual se consigue con variaciones en el voltaje que se aplica a los filtros.

Al no requerir el uso de un único tubo de imagen, los monitores LCD tienen un tamaño, especialmente un fondo, mucho menor, haciéndolos ideales para ordenadores portátiles o en entornos donde escasea el espacio. El consumo de estos monitores es también mucho menor, de ahí su adecuación al mundo de los portátiles.

El parpadeo en las pantallas LCD queda sumamente reducido por el hecho de que cada celda donde se alojan los cristales líquidos está encendida o apagada, de modo que la imagen no necesita una renovación (refresco) sino que se enciende o se apaga. La geometría perfecta viene dada porque cada celda que contiene un cristal líquido se enciende o apaga individualmente, y por lo tanto no hay problemas de convergencia.

Los LCD tienen ciertas desventajas. El coste de fabricación de los monitores LCD es superior al de las pantallas CRT, no sólo por la tecnología empleada, sino también por su escasa implantación que hace que los volúmenes de fabricación sean pequeños. Puesto que la luz en los LCD's es producida por tubos fluorescentes situados detrás de los filtros, en vez de iluminar la parte anterior como en los monitores CRT, con una visión diagonal la luz pasa a través de los píxeles (cristales) contiguos, por lo que la imagen se distorsiona a partir de un ángulo de visión de 100º.

Las variaciones de voltaje de las pantallas LCD actuales, que es lo que genera los tonos de color, solamente permite 64 niveles por cada color (6 bit) frente a los 256 niveles (8 bit) de los monitores CRT, esta gama de colores es claramente insuficiente para trabajos fotográficos o para reproducción y trabajo con vídeo. Debido al sistema de iluminación con fluorescentes, las pantallas LCD muestran una menor pureza del color, ya que muestran zonas más brillantes que otras, lo que da lugar a que una imagen muy clara o muy oscura afecte a las áreas contiguas de la pantalla.

Un problema adicional que afecta a la calidad de imagen en las pantallas LCD vienen dada por el funcionamiento actual de las tarjetas gráficas y las pantallas LCD: la tarjeta gráfica recibe una señal digital del procesador y la transforma a analógica para enviarla a la salida de señal; por su parte la pantalla LCD recibe esa señal analógica y la debe transformar a señal digital, con la lógica perdida que se produce entre ambas transformaciones. Las pantallas LCD actuales se conectan a puertos analógicos VGA, pero se espera que en un futuro todas las tarjetas gráficas incorporen también una salida digital.

2.2.2. TARJETA DE VÍDEO

Funcionalmente puede considerarse como una interfaz de salida de datos. Un adaptador de vídeo típico para PC's constará de una placa de circuito impreso con un conector de 9 pines al que se conecta el cable del monitor (hay monitores que no cumplen esta característica), y un conector de ranura de 2 x 31 contactos que se inserta en una de las ranuras de expansión (slots) de la placa base del PC.

Adaptador de Video

Figura 2.4. Adaptador de Vídeo

La elección de un subsistema gráfico (actualmente el estándar SVGA), nos permitirá controlar la resolución (numero de píxeles visualizados en una pantalla), la cantidad de colores simultáneos observados. La cantidad de memoria de la tarjeta de vídeo, nos determina la máxima resolución y los colores posibles en los que podemos trabajar (siempre condicionado al tipo de monitor). Un monitor SVGA autentico debería soportar como mínimo 1024x768, si bien hoy en día, lo normal (al menos a partir de 15 pulgadas) es que soportara hasta 1280x1024. En tamaños superiores (17, 19 o 21 pulgadas) resoluciones como 1600x1200 deberían ser soportadas.

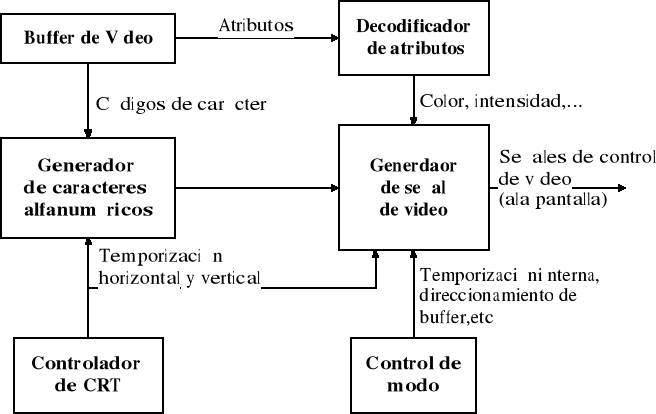

En detalle la tarjeta gráfica sería:

Información de Atributos

Código del Gráfico

Sincronización de la información

Figura 2.5. Diagrama de bloques de una tarjeta gráfica

En lo que sigue nos ocuparemos de describir los componentes de un adaptador, cuya estructura se muestra en la fig. 2.6.

En primer lugar, se dispondrá de un buffer de vídeo o memoria de refresco, en esencia una memoria RAM (VideoRAM) que almacenará la información que va a ser presentada por pantalla. Esta RAM puede direccionarse desde la CPU, por lo que funcionalmente ésta trabaja con aquella de la misma forma que con la Memoria Principal. Actualmente tenemos dos grandes grupos: las tarjetas basadas en VRAM y las basadas en DRAM. Las VRAM son chips de memoria de doble puerto, que permiten al procesador transferir datos a la memoria, mientras simultáneamente la tarjeta de vídeo transfiere información de la memoria al monitor. En contraste, las DRAM son chips de puerto simple por lo que los recursos se deben repartir entre el procesador y la propia tarjeta. Por todo ello podemos concluir que las tarjetas con VRAM alcanzan, generalmente, mayores prestaciones.

La cantidad de memoria que necesitan los datos que constituyen una imagen, depende del numero de bits que sean necesarios para codificar un color, de la resolución en la que estemos trabajando, y del hecho de que la aplicación este trabajando con simple o doble buffer de vídeo.

El controlador del CRT (CRTC) se encargará de actualizar, o refrescar, la información presentada en la pantalla continuamente con los contenidos de la RAM de vídeo, con objeto de producir la apariencia de una imagen estable. Para ello, el CRTC genera las señales de sincronismo de barrido horizontal y vertical, y además incrementa un contador de direcciones de la RAM de vídeo a una velocidad sincronizada con las señales de barrido, para poder actualizar todo el contenido de la pantalla en un único ciclo de refresco, lo cual impone una limitación al tiempo de acceso a la RAM de vídeo. La RAM de vídeo posee dos caminos de acceso para datos, lo que permite simultáneamente el refresco de la pantalla y el acceso del procesador a ésta.

El CRTC realiza además otras funciones. Por ejemplo, determinar el tamaño y posición del cursor que se visualiza en pantalla, seleccionar la parte de la RAM de vídeo que se ha de presentar en pantalla, o detectar las señales producidas por el ratón o lápiz óptico.

Figura 2.6. Componentes del sistema de vídeo de un PC

Los valores de refresco de pantalla suelen oscilar entre 70 y 100 Hz, por lo que una modificación de los contenidos de esta memoria por parte de un programa que esté ejecutándose en la CPU producirá un cambio inmediato de la presentación de la información en el monitor, respecto de la capacidad de percepción humana.

La capacidad del buffer de vídeo dependerá del adaptador de vídeo que manejemos. Suele ser usual disponer de RAM que contengan más de una pantalla, aunque el número de pantallas capaces de ser almacenadas vendrá determinado por la resolución y la escala de tonos o colores. Desde un punto de vista lógico puede considerarse a la RAM de vídeo dividida en planos, conteniendo cada plano un bit por cada píxel de la pantalla. Si P es el número de planos, 2P indicará la gama, número de tonos de gris o de colores por píxel. A medida que se aumenta la paleta de colores y la resolución, aumentarán las necesidades de capacidad de la RAM de vídeo. No es usual disponer de más de 1Mbyte de este tipo de memoria, si bien el abaratamiento de los costes de memorias hace atractivo el usar RAM de vídeo de alta capacidad, lo que provoca un crecimiento en la cantidad de información que debe recibir el sistema de vídeo del ordenador. Esto hará que aumente considerablemente el tiempo que pasa la CPU dedicada a procesamiento gráfico. Para liberar a la CPU de este tipo de tareas, surge la necesidad de incorporar un coprocesador gráfico en el sistema de vídeo, aunque esto encarecerá el coste de éste.

Además del CRTC y la RAM de vídeo, el adaptador de vídeo dispone de hardware que se encarga de realizar tareas complementarias. Así, el generador de caracteres alfanuméricos es una memoria ROM que permite la decodificación de los códigos ASCII de la RAM de vídeo en los patrones de puntos que forman los caracteres en la pantalla. Por último, un decodificador de atributos traduce otros datos almacenados en la RAM de vídeo en las señales que producen color e intensidad.

Cada carácter en pantalla, de forma similar al generado por una impresora matricial, está formado por una matriz de píxeles (character box píxel array), cuyo número varía tanto en horizontal como en vertical, dependiendo del adaptador de vídeo y del modo de resolución. La matriz de píxeles útil para cada carácter se denomina font (resulta al eliminar los píxeles de los márgenes, que no formarán parte del carácter). Un adaptador de vídeo que sólo permita la visualización por pantalla de los caracteres almacenados en su generador de caracteres se denominará alfanumérico, poseyendo una RAM de vídeo reducida. Pueden existir caracteres especiales almacenados en la ROM que permitan la formación de gráficos sencillos por composición los mismos, lo que dará al sistema de vídeo la posibilidad de trabajar en un modo semigráfico, de resolución limitada. Cuando el adaptador de vídeo dispone de RAM suficiente para especificar individualmente el estado de cada píxel, estaremos ante un adaptador de vídeo gráfico, que es lo usual en la actualidad. Este último además permitirá trabajar en modo alfanumérico también.

Por último, toda la información se enviará al monitor a través del generador de señal de vídeo. El rango de frecuencias que el adaptador de vídeo es capaz de enviar al monitor se conoce como ancho de banda, y es uno de los factores que determinan la nitidez de la imagen (normalmente será superior a 20 MHz). La información enviada puede ser digital o analógica, existiendo adaptadores de vídeo que pueden generar los dos tipos de señal.

Los programas diseñados para trabajar con adaptadores de vídeo pueden utilizar el conjunto de rutinas BIOS (Basic Input/Output System) de vídeo incluidas en la ROM del sistema, rutinas que proporcionan una interfaz con el hardware de vídeo, y que comprenden una serie de herramientas simples para realizar las tareas básicas de programación del vídeo: escribir cadenas de caracteres en pantalla, borrar la misma, visualizar un color determinado, etc. Los programas que utilizan estas rutinas se denominan compatibles a nivel del BIOS, por utilizar el mismo código máquina que éstas. Este tipo de compatibilidad confiere portabilidad a los programas que hacen uso de ella (si hablamos de PC's, claro), si bien puede producir lentitud en la ejecución de éstos, puesto que las rutinas del BIOS pueden ser poco rápidas y simples. Sin embargo, en determinados adaptadores será posible que el software no utilice las rutinas del BIOS y que tome control directamente sobre el hardware del adaptador, lo que redundará en beneficio del rendimiento de la aplicación gráfica. Esto se denomina compatibilidad en el ámbito de registros.

En la siguiente tabla una tabla se puede comprobar la cantidad de memoria necesaria para mostrar en pantalla los colores y resoluciones que se desea, junto con el tamaño de monitor recomendado para verlo.

| Resolución | 1 Mb | 2 Mb | 4 Mb | Tamaño Monitor |

| 1600x1200 | -- | 256 | 65.536 | 21" |

| 1280x1024 | 16 | 256 | 16´7 millones | 19/21" |

| 1152x882 | 256 | 65.536 | 16´7 millones | 19/21" |

| 1024x768 | 256 | 65.536 | 16´7 millones | 17" |

| 800x600 | 65.536 | 16´7 millones | 16´7 millones | 15" |

| 640x480 | 16´7 millones | 16´7 millones | 16´7 millones | 13/14" |

En realidad el ojo humano no puede distinguir 16´7 millones de colores, pero es sólo una cifra que indica el número de bits que estamos manejando. Por ejemplo, para 65.536 necesitaremos 16 bits (2 elevado a 16 es 65.536) . También podemos tener imágenes en 32 bits: 24 bits para los 16´7 millones de color y otros 8 para el canal alfa (para las transparencias). Pero apenas se percibe el cambio de 16 a 24 bits más que en una diferencia de velocidad en el refresco de los gráficos.

2.2.3. CICLO DE REFRESCO DE LA PANTALLA

Ya hemos dicho que la imagen de vídeo se refresca de una manera cíclica, con una frecuencia de 60 a 140 Hz. dependiendo de la configuración del sistema de vídeo. Durante cada ciclo de refresco, el haz de electrones barre la pantalla en forma de zig-zag, como se muestra en la fig.2.7., comenzando en el lado izquierdo de la línea horizontal más alta del raster. Después de barrer una línea de izquierda a derecha, el haz se sitúa en el comienzo de la siguiente línea, hasta que toda la pantalla ha sido barrida; entonces, el haz vuelve a la esquina superior izquierda de la pantalla y el ciclo se repite. Se denominará frecuencia horizontal a la inversa del tiempo requerido para que el haz trace una línea horizontal sobre la pantalla. Frecuencia vertical, o tasa de refresco, será la inversa del tiempo que se necesita para llenar la pantalla de líneas. Ambas se expresan habitualmente en KHz. Los monitores están diseñados para una o más frecuencias específicas tanto en horizontal como en vertical. También los adaptadores de vídeo están diseñados para frecuencias específicas, por lo que ambos deben ser compatibles.

Figura 2.7. Trayectoria del haz de electrones en un barrido completo

La tasa de refresco deberá tener en cuenta la persistencia o duración de la luminiscencia de los puntos de fósforo excitados por el haz de electrones. Una lenta tasa de refresco relativa a una pantalla de persistencia determinada producirá el efecto de parpadeo (flicker), con el que da la impresión de observar una intermitencia rápida en la pantalla, lo que se solucionará, lógicamente, aumentando la tasa de refresco. Los fósforos de larga persistencia reducen el parpadeo de la imagen, pero causan imágenes fantasma, visibles hasta un cierto tiempo después de oscurecerse la zona afectada de la pantalla. Además, los fósforos de alta persistencia son menos brillantes que los de baja persistencia, generando imágenes con poco contraste.

Al principio de cada línea el haz se activa como respuesta a la señal de activación de pantalla (Display Enable) que genera el CRTC. Cuando el haz barre de izquierda a derecha, a través de la línea, el hardware de vídeo utiliza el contador de direcciones del CRTC para leer una secuencia de bytes de la RAM de vídeo. Se decodifican los datos y se utilizan para controlar las señales de color y brillo enviadas al monitor. Cuando el haz barre a través de la pantalla, su color y brillo varían como respuesta a estas señales. Cerca del borde derecho de la pantalla, el CRTC desactiva la señal de activación de pantalla, dejándose de visualizar datos y de leer en la RAM de vídeo. Entonces el CRTC genera una señal de sincronismo horizontal que hace que el haz se desvíe hacia la izquierda y abajo hasta el comienzo de la siguiente línea horizontal. Nuevamente se pone en ON la señal de activación de pantalla y se repite el proceso para la nueva línea. Una vez que se han barrido todas las líneas horizontales, la señal de activación de pantalla se pone en OFF y el CRTC genera una señal de sincronismo vertical que desvía el haz hasta el borde superior izquierdo de la pantalla.

Al comienzo y final de cada línea, así como en los bordes inferior y superior de la pantalla hay un cierto margen sin iluminar, con objeto de proporcionar un margen de error en el raster, de tal forma que no se pierdan datos en los bordes de la pantalla (ver fig. 2.8.). Hay sistemas que permiten al usuario variar estos márgenes desde el propio monitor.

Figura 2.8. Márgenes

La técnica de formación de la imagen en la pantalla expuesta hasta ahora se denomina modo no entrelazado (non interlaced), dibujándose toda la pantalla en una sola pasada. Otra alternativa consiste en utilizar modo entrelazado (interlaced), con se dibuja la pantalla en dos pasadas. En la primera, se dibujan las líneas impares y en la segunda las pares, lo que aparentemente doblaría la tasa de refresco. Dependiendo del tipo de monitor, de la luz ambiente, y de la percepción individual, este entrelazado a menudo provoca sensación de parpadeo, sobre todo a corta distancia (efecto de falso parpadeo), por lo que sería deseable utilizar un modo de vídeo no entrelazado, si bien esto último representa una solución más cara (comparando dos sistemas de vídeo equivalentes en las demás características). Si bien este parpadeo no tiene nada que ver con la frecuencia de barrido vertical que soporte como máximo el monitor, a más frecuencia menos parpadeo, aunque por mucha frecuencia el efecto de un monitor entrelazado persistirá. El entrelazado permite una mayor resolución de pantalla con un ancho de banda menor, y tener un ancho de banda menor suele ser deseable.

Ahora bien el modo entrelazado o no entrelazado, por propia definición, es un aspecto que no afecta a resoluciones iguales o inferiores a las 600 líneas verticales, por lo que los modos 640x480 y 800x600 no se ven influidos. Si a estas resoluciones parpadea el monitor es que dicho monitor es de mala calidad. El primer modo que si se ve influido es el 1024x768. Aquí es cuando uno debe plantearse las diferencias entre monitor entrelazado o no. Hoy en día casi todos los monitores son no entrelazados. El problema es que lo de entrelazado o no entrelazado, no es una característica que englobe a todas las resoluciones de un monitor. Así, puede ser que un monitor sea no entrelazado para resoluciones como la 1024x768 pero si lo sea para la 1280x1024 o la 1600x1200. Por lo tanto lo ideal es que sea no entrelazado para todas las resoluciones que soporte superiores a la 800x600.

Haz que tener en cuenta, es que lo de entrelazado o no, no solo afecta al monitor, sino también a la tarjeta gráfica. Una tarjeta puede ser que a ciertas frecuencias altas (por ejemplo 75 Hz) en ciertas resoluciones sólo pueda trabajar en modo entrelazado.

2.2.4. TARJETAS DE VÍDEO PARA PC's

Cuando se introdujo el PC en 1981, IBM ofrecía dos tipos de adaptadores de vídeo: el adaptador de pantalla monocromo (MDA) y el "Color Graphics Adapter" (CGA). MDA se diseñó para utilizar un monitor monocromo alfanumérico de 80 x 25 caracteres de texto, con una matriz de 720 x 350 píxeles, disponiendo de una RAM de vídeo de tan sólo 4K (4.000 caracteres). CGA soporta un monitor RGB o de televisión, permitiendo visualizar tanto información gráfica (640 x 200 píxel, con posibilidad de usar 2 colores, ó 320 x 200, con 4 colores) como alfanumérica (40 x 25 ó 80 x 25 caracteres) y disponiendo de una RAM de vídeo de 16K, lo que permitía almacenar 8 ó 4 pantallas según el submodo alfanumérico con el que trabajásemos; esto permitía una capacidad alta de scroll. Un carácter en MDA está formado por una matriz de 9 x 14 píxeles (su font es de 7 X 11), mientras que en CGA es de 8 x 8. Por eso era preferible la utilización de MDA cuando se trabajaba en modo texto, aunque las posibilidades de representación de caracteres en ésta eran limitadas, al no disponer más que de 256 caracteres fijos almacenados en su ROM de vídeo, sin permitir al usuario definirse su propio juego de caracteres. Como las señales de vídeo generadas por ambos adaptadores son incompatibles, no se podía hacer uso de las ventajas de éstos simultáneamente (mayor resolución en modo texto de MDA y capacidad de generar gráficos en color de CGA), a menos que se instalasen dos sistemas de vídeo completos (incluido monitor) sobre la misma CPU.

Para resolver el problema de visualizar texto de buena calidad y gráficos en el mismo monitor, en 1982 se presentó el adaptador “Hercules Graphics Card” (HGC), que permitía el uso de texto y gráficos en el mismo monitor monocromo compatible con MDA y con resolución de 720 x 348 píxeles, lo que representaba una solución económica y relativamente eficiente. Actualmente se dispone de una gran cantidad de software para este adaptador. HGC era capaz de emular mediante software especial a un adaptador CGA. MDA y HGC sólo disponían de un juego de caracteres predefinido en su ROM de vídeo, y cómo los caracteres alfanuméricos se pueden presentar en pantalla mucho más rápidamente que los caracteres gráficos, era deseable disponer de un adaptador que dispusiera de varios juegos de caracteres. El adaptador Hercules Graphics Card (HGC+), aparecido en 1986, disponía ya de varios juegos de caracteres en su RAM de vídeo.

Una solución diferente al problema de visualizar texto nítido y gráficos de alta resolución fue aportada por la aparición de los adaptadores “Professional Graphics Controller” (PGC) y “Enhanced Graphics Adapter” (EGA), en 1985. PGC fue orientado hacia el mercado del CAD, intentando competir con los adaptadores diseñados para work- stations, proporcionando una relación de aspecto de 4:3 sobre una resolución de 640 x 480 y generando hasta 256 colores. Sin embargo, PGC era un adaptador caro que no llegó a popularizarse, sobre todo después de la introducción del adaptador VGA, que veremos más adelante. Por otra parte, el adaptador EGA puede configurarse para emular a los adaptadores MDA y CGA, con capacidad de generar gráficos en un monitor monocromo, aumentando la resolución de CGA al permitir imágenes gráficas o alfanuméricas de 16 colores con resolución de 640 x 350. EGA incorpora una RAM de vídeo de 64K, con posibilidad de instalar 192K más, para aprovechar todas sus prestaciones. También usa una matriz de caracteres de 8 x 14 píxeles, cercana a los 9 x 14 de MDA y bastante superior a los 8 x 8 de CGA. Así, por primera vez se disponía de textos legibles en modo gráfico. Esto ha hecho de EGA un estándar del hardware de vídeo, sobre todo después de la aparición del adaptador EGA Plus en 1988, que permite 640 x 480 píxeles y hasta modos superiores de resolución. Utiliza una matriz de caracteres de 9 x 14, dispone de una RAM de vídeo de 256K, y emulación de los estándares anteriores, MDA, CGA y Hércules.

En 1987 apareció el adaptador “Hercules InColor”, versión en 16 colores de la HGC+ con su misma resolución, y naturalmente compatible con ésta. Permite además conectarse a un monitor de color compatible con EGA, ya que presenta las mismas capacidades de color que ésta (16 colores de una paleta de 64).

Los anteriores adaptadores, salvo PGC, generan señales de vídeo RGB o monocromas digitales. Los adaptadores de vídeo diseñados posteriormente generan señales analógicas, lo que permite utilizar una gama de colores mucho mayor, o bien ambos tipos de señales, para poder utilizar distintos tipos de monitores. El adaptador “Multicolor Graphics Array” o MCGA (integrado en los modelos 25 y 30 de la serie PS/2 de IBM) sólo puede utilizar monitores analógicos; tiene una resolución máxima de 640 x 480 en el modo de 2 colores, y capacidad de visualizar 256 colores de una paleta de 262.144 (256K colores), trabajando con la más baja resolución, 300 x 200. También puede trabajar con un monitor monocromo analógico, pudiendo presentar hasta 64 tonos de grises. Es compatible parcialmente con CGA, al disponer de un modo de emulación de ésta.

El adaptador “Video Graphics Array” (VGA), integrado en los modelos 50, 60 y 80 de la serie PS/2, alcanza resoluciones de 720 x 400 en modo texto y 640 x 480 en modo gráfico (el modo gráfico de baja resolución es de 320 x 200). Dispone de 17 modos de funcionamiento, teniendo una interfaz de programación que la hace compatible con EGA casi totalmente. Como en el caso de MCGA, puede generar al mismo tiempo 256 colores de una paleta de 262.144. Puede utilizar los monitores analógicos en color o monocromos compatibles con MCGA, pues genera la misma señal RGB que ésta. Tiene una RAM de vídeo de 256K, lo que permite mantener en memoria hasta 8 pantallas, ya que los caracteres se construyen con una matriz de 9 x 16 píxeles en modo texto, o bien 8 x 16 en el modo gráfico. VGA puede emular todas las tarjetas estándar anteriores. Algunas mejoras sobre el estándar VGA han llevado a la realización del adaptador Super VGA, compatible con el anterior y con una resolución máxima de 800 x 600 con 16 colores. El estándar Super VGA es la recomendación actual de VESA (Video Electronics Standard Association), agrupación de fabricantes formada para establecer y mantener una normativa para la realización de adaptadores de vídeo y monitores.

En 1987 se introdujo un nuevo estándar por IBM para su serie PS/2. Se trata del adaptador 8514/A, que ofrece 256 colores con una resolución de 640 x 480 de una paleta de 256.000, o bien 16 ó 256 colores con resolución de 1.024 x 768. Dispone además de coprocesador gráfico. De todos modos, IBM está intentando sustituir este estándar por la última implementación de adaptador de vídeo, el “Extended Graphics Array” (XGA), introducido a finales de 1990 en los modelos 90 y 95 de la serie PS/2. XGA es compatible con VGA y estándares anteriores, añadiendo a los modos de resolución VGA los siguientes: 1.024 x 768 píxeles con 256 colores en pantalla y 640 x 480 con 65.536 colores simultáneos. XGA incorpora 1M de RAM de vídeo y coprocesador gráfico. IBM propuso, durante 1991, la norma XGA a VESA.

Actualmente existen chips para tarjetas gráficas muy potentes, la mayoría de las veces con potencia de cálculo superior a la del procesador principal, pero también muy diferentes entre sí. Hace algunos años, no se le prestaba en absoluto atención a la calidad de la tarjeta VGA. Después, tras la aparición de la SVGA, fue el punto de partida a la hora de mejorar estas tarjetas, ya que, junto con la evolución de la tecnología en los monitores, cada vez soportaban mayores resoluciones al incorporar memorias entre 1 y 3 Mb.

Pero la auténtica revolución gráfica fue en el sector tridimensional, el 3D, donde se necesitan potencias de cálculo muy superiores que el microprocesador central no puede soportar. Fundamentalmente, lo que hace un chip 3D es quitar la labor del procesador de generar los triángulos y el relleno de texturas, haciendo que la tarjeta gráfica lo haga sola liberando al procesador de otras tareas. Con esto, se obtiene una mejora muy grande en lo que se refiere a la velocidad, y además se han incorporado multitud de efectos gráficos fáciles de usar por los programadores que mejoran sustancialmente la calidad de los gráficos.

Las placas de video se fabrican hoy día para buses PCI y AGP (estos buses permiten características como Plug and Play y Bus Mastering, ésta última para optimizar las operaciones de transferencia de la tarjeta). Estas tarjetas se suelen usar en ordenadores Pentium y equivalentes (como el K6 de AMD). Actualmente también para el bus USB.

2.2.5. TARJETAS ACELERADORAS

La tarjeta aceleradora es una placa de circuito impreso que amplía las capacidades del microprocesador principal de un equipo o lo sustituye por otro más rápido. La tarjeta aceleradora permite al usuario ampliar un sistema dotándolo de un microprocesador más rápido sin necesidad de sustituir las tarjetas, unidades, teclado o caja. Esto reduce sustancialmente el precio total del sistema

Las tarjetas gráficas con aceleración 3D son, básicamente, una unidad de proceso periférica que se encarga de realizar los cálculos necesarios para la representación tridimensional. De este modo, la CPU está libre para encargarse de otras tareas menos específicas, acelerando el conjunto. Estas tarjetas se componen generalmente de unos procesadores de tipo CISC (aquellos que no usan un conjunto reducido de instrucciones, como los RISC) conectados a un BUS y a unas memorias de alta velocidad. Los procesadores se encargan del trabajo de cálculo, utilizando las memorias de la tarjeta para almacenar los datos necesarios (como las texturas) y el BUS para comunicarse con la CPU. Son unas tarjetas específicas para la generación de gráficos en tres dimensiones.

Figura 2.9. Diagrama de bloques de una tarjeta aceleradora

Su funcionamiento es igual al de una tarjeta gráfica 3D en cuanto a la transmisión de datos del procesador principal al procesador gráfico, el almacenamiento en memoria de los datos y la transmisión al monitor por medio de la RAM de video, pero el procesamiento de los datos por el chip gráfico es mucho más complejo, pues al contrario que en las tarjetas gráficas 3D el proceso de representación no lo realiza el procesador principal.

Durante el proceso de representación, el procesador gráfico 3D aplica a la imagen una serie de texturas que se almacenan en la memoria de vídeo y realiza básicamente las siguientes operaciones sobre una imagen generada por el procesador:

-

Buffer de ocultación: se utiliza para ocultar las partes de la imagen que no están visibles por estar tapadas por otras. Este efecto se puede conseguir por software o por hardware, siendo más rápido por hardware.

-

Sombreado Gouraud: se utiliza para evitar el aspecto cuadrado de los objetos y dando así más sensación de profundidad.

-

Corrección de perspectiva: orienta adecuadamente las texturas sobre los polígonos

-

Mapeado MIP: pega las texturas sobre los polígonos y evita que al aumentar o disminuir el tamaño de la imagen, se ganen detalles. Para ello se almacenan texturas en varias resoluciones que luego se recuperan de la memoria gráfica en tiempo real.

-

Filtrado Bilineal: evita el aspecto difuso en las uniones de texturas y polígonos al acercar la imagen (el proceso que más recursos consume al procesador gráfico).

-

Filtrado Trilineal: tiene la misma función que el anterior pero mejora los resultados del anterior.

-

Alpha Blending: crea efectos de transparencias.

Al ser chips específicos, estos periféricos pueden encargarse de los gráficos de modo mucho más eficiente y con mejores resultados que las CPUs, aunque sean menos potentes. Mejor calidad de imagen, mejores efectos especiales, más suavidad y mayor precisión en la representación son algunas de las principales ventajas, pero no las únicas. Las tarjetas aceleradoras vienen siendo utilizadas en el campo profesional desde mucho antes que en el del entretenimiento, lo que nos da una pista de las posibilidades que este hardware ofrece.

El rendimiento de una tarjeta es, por decirlo de algún modo, su velocidad. Los fotogramas por segundo (fps) que nos puede ofrecer en pantalla. Esta velocidad es vital, pues un ratio inferior a 25 fps nos dará una imagen poco suave, a saltos y muy incómoda de observar. A una tarjeta 3D se le suele pedir un ratio de en torno a los 50-60 fps. Hay que fijarse muy bien en las velocidades que la tarjeta obtiene en las aplicaciones que nosotros queremos usar. El análisis del comportamiento de los distintos chips gráficos en distintas resoluciones es el más significativo a la hora de mirar su resolución. Por ejemplo, partamos de que el trabajo fundamental de una tarjeta es el generado y el rellenado o texturado de polígonos. Si vemos que un chip gráfico da rendimientos muy parecidos en resoluciones distintas, significa que su limitación o “cuello de botella” está en el cálculo de polígonos, mientras que en el rellenado de éstos puede ser buena. Si por el contrario el rendimiento va disminuyendo notablemente a medida que aumentamos la resolución, significa que la limitación de esa tarjeta viene dada por el rellenado de los polígonos y no en su generado. De ahí que tarjetas sin problemas a la hora de rellenar polígonos sean ideales para equipos muy potentes (de modo que la mayor parte de la generación de polígonos la soporte el micro) y que las que tienen su mayor potencial a la hora de generar polígonos sean las ideales para equipos con micros poco potentes que apenas puedan prestar ayuda.

Las tarjetas aceleradoras precisan una programación para aprovechar sus características. Por lo tanto, si un programa de ordenador no da las ordenes pertinentes, la aceleración no sirve de nada. Dado que cada fabricante quiere que esas aplicaciones le sean ordenadas de distinta manera, dicho fabricante normalmente proporciona un driver (un programa que actúa de interfaz entre la aplicación y la tarjeta) para facilitar el trabajo del programador. Dado que el fabricante no va a programar los drivers para las distintas aplicaciones del mercado, proporciona únicamente drivers para aquellos sistemas operativos que engloban aplicaciones (Windows, OS/2, etc...).

El termino aceleradora no engloba en si mismo ninguna especificación de los programas que acelera o no, es decir, dependiendo del chip acelerador, nuestra tarjeta acelerara más o menos cosas y más o menos rápidamente. Debemos disponer de un programa que sea capaz de decir que aplicación acelera y cual no.

Actualmente, en el mercado de consumo, existen 2 tipos de aceleradoras gráficas:

-

Las propias aceleradoras 3D, tarjetas independientes que sólo entran en funcionamiento cuando se ejecuta algún juego que necesite su funcionamiento. Estas tarjetas requieren una tarjeta 2D que se encargue de las tareas normales, con un único requisito de tener un mínimo 2 Mb. de memoria. Además, ambas suelen estar unidas con un cable externo.

-

Y luego están las tarjetas "híbridas" 2D/3D, que consisten en un único chip que se encarga tanto de las funciones 2D como de las funciones 3D de una aceleradora. Los últimos modelos que están apareciendo estos meses son realmente buenos y no tienen nada que envidiar a las aceleradoras 3D puras.

Las tarjetas gráficas tradicionales 2D son capaces de procesar imágenes 3D por emulación por software, aunque con resultados de baja calidad y con una desesperante lentitud, de modo que el cálculo y la generación de las imágenes en 3D las realiza el propio procesador, estando por tanto este demasiado ocupado para realizar otras operaciones, ralentizando todo el equipo.

Memoria: En las tarjetas 2D, la cantidad de memoria sólo influye en la resolución y el número de colores que dicha tarjeta es capaz de reproducir. Lo habitual suele ser 1 ó 2 Megas.

| Relación entre memoria y Resoluciones máximas | ||||

| Memoria | Máximas resoluciones y colores | |||

| 512 Kb. | 1024x768-16 colores | 800x600-256 colores |

|

|

| 1 Mb. | 1280x1024-16 colores | 1024x768-256 colores | 800x600-64k colores | 640x480-16,7M col. |

| 2 Mb. | 1280x1024-256 colores | 1024x768-64K colores | 800x600-16,7M colores | ídem |

16 colores = 4 bits.

256 colores = 8 bits.

64k = 65.536 colores = 16 bits

16,7 M = 16.777.216 colores = 24 bits.

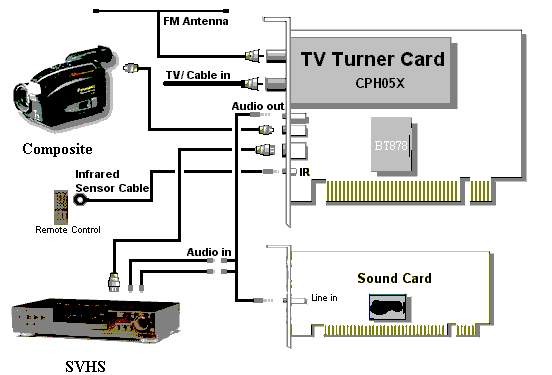

2.2.6. TARJETAS DE TELEVISIÓN

Consiste en un tarjeta que, colocada en un slot del ordenador, nos permite disfrutar de la televisión en una ventana de nuestro ordenador. Las aplicaciones que podremos darle a nuestro equipo son múltiples: desde captura de imágenes de la TV, hasta edición y salida a vídeo de nuestro producto retocado.

La tarjeta gráfica que se tenga ha de ser compatible con la tarjeta receptora de televisión. Por otra parte la tarjeta debe conectarse a una toma de antena, para poder sintonizar con claridad los canales.

Un esquema de las conexiones de una tarjeta de televisión sería la siguiente figura:

2.2.7. CÁMARAS DE VÍDEO

Las cámaras de vídeo han cobrado una gran importancia a raíz del boom de Internet. Una cámara de este estilo nos permitirá, desde mantener conferencias con nuestros amigos a mostrar nuestra vida a medio mundo a través de Internet.

Parámetros de importancia:

-

Resolución. Es el número de puntos que capta la cámara. Cuanto mayor sea, mejor. Una resolución habitual es la de 320x240 píxeles. Es posible que nos den dos resoluciones: para imagen fija y para vídeo.

-

“Frame rate”: Es el número de imágenes captadas por segundo. Existe una relación clara entre la forma de comunicar la cámara con el ordenador y el número de fps. Así, existen cámaras que se comunican vía puerto paralelo y solamente capturan 3 fps. Las cámaras que usan la conexión USB alcanzan entre 8 y 14 fps.

Es importante saber para qué se va a usar la cámara. El uso más habitual suele ser para mantener vídeo-conferencias. Debido a la lentitud de Internet, podemos estar casi seguros de que poco importa la calidad de las imágenes o los fps. De nada sirve poder mostrar 30 fps si solamente podemos transmitir 5 fps. En este caso, no es necesario disponer de una vídeo cámara excelente, puesto que no podremos usarla al límite de sus posibilidades. Si lo que queremos, por contra, es una captura de alta calidad, es conveniente invertir una cantidad de dinero superior para conseguir nuestros objetivos.

La conexión con nuestro ordenador, en el ámbito de compatibilidad y facilidad, es muy importante, la conexión USB la más aconsejable. Son interesantes también otras posibilidades tales como poder conectar nuestra cámara a una televisión o vídeo.

2.3. SISTEMA DE AUDIO

2.3.1. TARJETA DE SONIDO

La tarjeta de sonido es la encargada de convertir la información digital procesada por nuestro equipo (1s y 0s) en datos analógicos, o sonidos, para que sean reproducidos por unos altavoces conectados a la propia tarjeta de sonido.

El sonido es una señal analógica; puede tomar cualquier valor en un intervalo continuo. Los ordenadores son digitales; parece que trabajan con valores discretos. Las tarjetas de sonido usan un dispositivo conocido como convertidor analógico a digital (A/D o ADC) para convertir los voltajes correspondientes a las ondas de sonido analógico en valores digitales o numéricos los cuales pueden ser guardados en memoria. Similarmente un convertidor digital analógico (D/A o DAC) convierte valores numéricos en un voltaje analógico el cual puede ser reconducido a un altavoz, produciendo sonido.

Se encargan de digitalizar las ondas sonoras introducidas a través del micrófono, o convertir los archivos sonoros almacenados en forma digital en un formato analógico para que puedan ser reproducidos por los altavoces. Los sonidos que puede percibir el oído humano abarcan las frecuencias de 20 a 20.000 Hz.

La tarjeta de sonido recorre estas ondas tomando muestras del tipo de onda (de su frecuencia), esta operación se realiza con valores variables de muestreo, desde 8.000 hasta 44.100 Hz, a mayor frecuencia de muestreo mayor será la calidad de la grabación. Y del nivel sonoro de esta onda, esta información se guarda en 8 bits (28 = 256 niveles de sonido) o en 16 bits (216 = 65.536 niveles de sonido). Y en un canal o Mono o dos canales o Estéreo.

La calidad telefónica correspondería a 11.025 Hz, 8bits y Mono. La calidad de la radio a 22.050 Hz, 8 bits y Mono, ocupando el archivo el doble que el primero. Y la calidad del CD a 44.100 Hz, 16 bits y Estéreo, ocupando el archivo 16 veces más que el primero. El proceso de conversión de analógico a digital, conocido como muestreo (sampling), introduce algunos errores. Dos factores son fundamentales en determinar con qué fidelidad la señal de muestra representa a la original.

La frecuencia de muestreo (sampling rate) es el número de muestras hechas por unidad de tiempo (generalmente expresado en muestras por segundo o hertzios). Una frecuencia de muestreo baja genera una representación de menos calidad de la señal analógica. El tamaño de muestreo (sample size) es el rango de valores usados para representar cada muestra, generalmente expresado en bits. Cuanto mayor sea el tamaño de muestra de mayor calidad será la señal digital. Las tarjetas de sonido usan comúnmente muestras de 8 o de 16 bits y frecuencias de muestreo desde 4000 hasta 44000 muestras por segundo. Las muestras pueden estar contenidas en un canal (mono) o en dos (estéreo).

El proceso de reproducción sigue los mismos pasos pero en sentido contrario.

Muchas tarjetas de sonido poseen capacidades MIDI; esto significa que en un chip de la tarjeta, sintetizador, se encuentran almacenadas las características de diferentes instrumentos musicales, y la grabación o reproducción de un sonido se hace en referencia a éstos y las notas musicales correspondientes.

Igualmente, los sonidos analógicos introducidos por medio de un micrófono, un equipo de música conectado a LINE-IN, o un instrumento musical conectado al puerto MIDI, son transformados en información digital para que sea reconocida y procesada por el equipo. Además la tarjeta de sonido es la encargada de reproducir, por medio de los altavoces conectados a ella, las pistas musicales de un Compact Disc de música insertado en nuestra unidad de CD-ROM. Para ello, el CD-ROM y la tarjeta de sonido deben estar conectados por un cable.

Una tarjeta de sonido necesita una dirección por donde recibe las órdenes (

puerto), una interrupción para llamar la atención al microprocesador (IRQ

) y un camino (canal) por donde transferir datos (DMA).

La síntesis de FM es una técnica antigua para producir sonido. Se basaba en combinar diferentes formas de onda (por ejemplo sinusoidal, triangular, cuadrada). La síntesis de FM es más fácil de implementar en hardware que la conversión D/A, pero es más difícil de programar y menos flexible. Algunas tarjetas de sonido traen la síntesis de FM para conservar la compatibilidad con otras tarjetas y software anteriores.

La síntesis de tabla de onda (WaveTable) combina la flexibilidad de la conversión D/A con la capacidad de múltiples canales de la síntesis de FM. Con este esquema las voces digitalizadas pueden ser cargadas en una memoria dedicada, y después reproducidas, combinadas, y modificadas con pocos recursos de la CPU. La mayoría de las tarjetas de sonido proporcionan la capacidad de mezclar, combinar señales de diferentes fuentes de entrada y controlar los niveles de ganancia.

MIDI significa Musical Intrument Digital Interface (interfase digital para instrumentos musicales), y es el hardware estándar y el protocolo software que permite a los instrumentos musicales comunicarse con cualquier otro. Los eventos enviados a través de un bus MIDI también pueden ser guardados como ficheros MIDI para editarlos más tarde y reproducirlos. Algunas tarjetas de sonido traen un interfase MIDI. Las que todavía no pueden reproducir ficheros MIDI usan las capacidades de la placa de la tarjeta de sonido.

Una tarjeta de sonido también es capaz de manipular las formas de onda definidas; para ello emplea un chip DSP (Digital Signal Processor), que le permite obtener efectos de eco, reverberación, coros, etc. Las más avanzadas incluyen funciones ASP (Advanced Signal Processor), que amplía considerablemente la complejidad de los efectos. Por lo que a mayor variedad de efectos, más posibilidades ofrecerá la tarjeta.

![]()

Figura 2.10. Diagrama de bloques de la Tarjeta de Sonido

Haciendo un repaso por la historia de las tarjetas de sonido, nos damos cuenta que muchos consideran a la Empresa “Creative Labs” como la más avanzada en el campo del sonido, pero no es así. Todo, probablemente, comenzó con la aparición en el mercado de una tarjeta casi olvidada: AdLib. Esta tarjeta disponía de síntesis FM, es decir, síntesis por modulación de frecuencias, una tecnología inventada por el MIT en los años 60. Con esa capacidad, sólo se podía reproducir música desde secuenciadores MIDI, o reproducir la música y efectos de los juegos.

Tras la aparición de la tarjeta AdLib, vino la tarjeta Sound Blaster (SB) de la casa “Creative Labs”, totalmente compatible con la anterior, pero que además de la síntesis FM, incorporaba la posibilidad de grabar y reproducir audio digital (en 8 bits). Esto permitía a los programadores de juegos usar sonidos reales (voces, ruidos, etc) como efectos especiales de sus juegos. Esta espectacularidad está subrayada por su pomposo nombre (en inglés-americano). Creative se hizo con el mercado, consiguiendo desde entonces ser el estándar de hecho: todas las tarjetas que se precien deben ser compatibles con la Sound Blaster, ya que todos los fabricantes de juegos y otros software programan para este sistema. La Sound Blaster Pro ya funcionaba en estéreo.

En 1989 “Turtle Beach” (TB) sacó al mercado su Turtle Beach Multisound. Este no era un producto orientado al mercado doméstico, como los anteriores, sino que su elevado precio (unas 140.000 Pts.), y sus avanzadas características (incorporaba un chip DSP “Motorola” 56000 a 20 Mips) la dirigían hacia un mercado de audio profesional. Entre sus mejores características destacan que no usaba la lamentable síntesis FM, sino una excelente síntesis PCM (wavetable) incorporando un Chip de la empresa “EMU Systems”, una de las mejores empresas de sintetizadores y samplers para el mercado musical profesional. Pero si el sonido MIDI era inmejorable, en cuanto al audio tampoco se quedaba corta, ya que permitía la grabación y reproducción de audio a 16 bits, con unos buenos conversores DAC y DCA, proporcionando por lo tanto un bajísimo nivel de ruido y poca distorsión armónica. De lo que no se preocuparon fue de proveer compatibilidad con los juegos que usaban síntesis FM.

La famosa “Gravis Ultrasound” (GUS) fue el primer intento de fabricar un sampler para el mercado doméstico. Los usuarios de Sound Blaster que escuchaban una GUS se arrepentían de su compra. Para mejorar el sonido, la GUS disponía de una memoria RAM de 256 Kb que permitía almacenar grabaciones de instrumentos reales (sistema Wavetable). Pero esta tarjeta tenía un problema: aunque podía reproducir sonido de 16 bits, sólo podía grabarlo a 8 bits. Por ello, no era utilizable para la grabación de audio digital de calidad, aunque en el campo MIDI estaba entre la SB y la Multisound. Este defecto fue subsanado varios años después, con las versiones posteriores Ultrasound Max y Ultrasound Ace., que además traían ya 1 Mb de RAM.

Con la Sound Blaster 16, el mercado del audio a 16 bits se popularizó, haciéndolo asequible al mercado doméstico, pero sin ofrecer la alta calidad de la Multisound (lógico si se desea abaratar costes). Por otro lado, la SB 16 mantenía la misma síntesis FM de la SB Pro, por lo que musicalmente, su valor seguía siendo escaso. Antes de la Sound Blaster, “Media Vision” había fabricado la Pro Audio Spectrum (PAS), con sonido de 16 bits, aunque fue la primera la que dominó el mercado. Creative sacó una versión ASP de la Sound Blaster, que contenía un chip de proceso digital de señal (Avanced Signal Processor), que aún no se atrevían a llamar DSP (Digital Sound Processor, como la Multisound). Este ASP permitía cierta mejora al añadir efectos de Reverberación y 3D, además de aportar compresión de ficheros de audio (wav).

La fidelidad de reproducción MIDI que aportaba la GUS motivó que, con el tiempo, varias marcas se plantearan sacar al mercado tarjetas con tecnología similar. La Orchid Wave 32 entre otras, y las empresas de instrumentos musicales ya habían desarrollado tarjetas de alta calidad (especialmente la excelente Roland RAP-10 y la Ensoniq Soundscape). La tecnología wavetable de las demás tarjetas usaban sonidos (formas de onda) grabados en memoria ROM, en lugar de usar memoria RAM como la Gravis, con lo cual no se podía modificar los sonidos a voluntad del usuario. Sin embargo, implementaban los 128 sonidos del General MIDI (GM) y el General Standard (GS), incluyendo varios bancos de sonidos de batería y percusión. Con estas tarjetas, escuchar un buen fichero MIDI es ya una delicia.

En otro nivel más avanzado, la Digidesign Sample Cell ofrece la calidad de los samplers profesionales, e incluso mejores prestaciones. La diferencia está en el precio (más de 230.000 pts), a diferencia del medio millón que costaba un sampler en esa época. Aunque ahora hay algunos samplers de 150.000 pts, la Sample Cell aporta mayor calidad: 8 salidas de sonido independientes, edición súper completa y sofisticada de las muestras de onda, 8 Mb de RAM ampliables a 32, trae 2 CD-ROM de muestras de altísima calidad... en fin, un producto totalmente profesional.

Para presupuestos más limitados en la tarjeta de sonido, la Turtle Beach Maui ofrece por unas 40.000 pts el mismo sistema, trae 2 Mb de ROM con los sonidos General MIDI y permite llegar a 4 Mb de RAM, con casi 200 parámetros para edición de los bancos de sonidos. Se puede adquirir un puñado de CD-ROMs de muestras de calidad especialmente preparadas para Maui. Tiene la salida estéreo habitual, pero no dispone de entrada para digitalizar sonido. Así pues, debe usarse en combinación con otra tarjeta de 16 bits.

Creative también quiso copar el segmento doméstico de este mercado, y fabricó, entre otras, la tarjeta Sound Blaster 32 PnP, que disponía de sonido wavetable en 1 Mb de ROM, con el sintetizador de la EMU 8000, de la famosa empresa “EMU Systems”, que acabó comprada por Creative. Además, de la síntesis FM, efectos de reverberación y coro, polifonía de 32 voces, compatible General Midi, y añade 2 zócalos para añadir RAM en SIMMs de 30 contactos (hasta 28 Mb), con la tecnología de sampling que denomina “Sound Fonts”. Asimismo, admite grabación y reproducción simultánea de audio a disco duro, es decir, son Full Duplex. Esto es importante para usar programas de audio multipista, ya que mientras grabas una toma nueva, puedes escuchar lo que habías grabado antes.

Después vino la Sound Blaster AWE (Avanced Wave Effects ) 32 PnP, que añade a la SB 32 sonido 3D, y 512 Kb de RAM para Sound Fonts, para lo que incluye software, además del secuenciador MIDI Orchestrator Plus.

En el mundo de los ordenadores compatibles el estándar en sonido lo ha marcado la empresa “Creative Labs” y su saga de tarjetas Sound Blaster. Si escogemos una tarjeta que no sea de esta marca, y queremos ejecutar todo tipo de software es importante comprobar que sea SB compatible a nivel de hardware, y si así es, informarnos de con que modelo es compatible.

Otro factor a tener en cuenta es si la tarjeta admite la modalidad full duplex, es decir si admite grabar y reproducir a la vez, o lo que es lo mismo, si puede procesar una señal de entrada y otra de salida al mismo tiempo. Esto es importante si queremos trabajar con algún programa de videoconferencia.

También es importante el soporte de MIDI. Este es el estándar en la comunicación de instrumentos musicales electrónicos, y nos permitirá reproducir la partitura generada por cualquier sintetizador y a la vez que nuestra tarjeta sea capaz de atacar cualquier instrumento que disponga de dicha entrada. Hay que tener claro que el formato MIDI realmente no graba el sonido generado por un instrumento, sino sólo información referente a que instrumento estamos tocando, que nota, y que características tiene de volumen, velocidad, efectos, etc..., con lo que el sonido final dependerá totalmente de la calidad de la tarjeta.

Otro punto importante es la memoria. Esta suele ser de tipo ROM, y es utilizada para almacenar los sonidos en las tarjetas de tipo “síntesis por tabla de ondas”. Este tipo de tarjetas nos permiten almacenar el sonido real obtenido por el instrumento, con lo que la reproducción gana mucho en fidelidad. Cuanta más memoria tengamos, más instrumentos será capaz de guardar en ella y mayor será la calidad obtenida. En las tarjetas de síntesis FM este dato no es importante.

Es habitual leer que una tarjeta marcada como “32”, por ejemplo, la Sound Blaster 32, esta tarjeta no es de 32 bits, sino de 16 bits, es decir, pueden reproducir y grabar sonido digitalizado a 16 bits. El número 32 se refiere a la polifonía, es decir, el número de notas musicales que puede tocar simultáneamente el sintetizador interno. Por lo tanto las tarjetas marcadas como 64 no son tarjetas de 64 bits. De hecho, los estudios de grabación profesionales no usan más de 20 bits en sus equipos de mayor calidad. Sólo una de las tarjetas de sonido descritas tiene más de 16 bits: la Turtle Beach Pinnacle, con 20 bits.

Haciendo una tabla de las diferentes tarjetas podemos ver su polifonía y el número de bits que poseen:

| Tipo de tarjeta | Polifonía | Número de bits |

| Típica FM (compatible SB 16) | 20 | 8 ó 16 |

| Estándar GM (General MIDI) | 24 | 16 |

| Tipo Wavetable (estilo SB 32) | 32 | 16 |

| Maxi Sound Home Studio, SB AWE 64 | 64 | 16 |

| Turtle Beach Pinnacle | 64 | 20 |

También es falso que una tarjeta etiquetada con 32 signifique que pueda reproducir 32 instrumentos simultáneos. Lo que quiere decir es que puede tocar 32 notas simultáneas. Un piano, por ejemplo, puede estar sonando con 8 notas a la vez (un acorde complejo), la guitarra tiene 6 cuerdas que pueden sonar todas a la vez, y la percusión puede llevar 4, 6 u 8 notas simultáneas. Así una composición interpretada por piano, batería, bajo, guitarra, y sección de metales puede ocupar más de 24 voces de polifonía. Lo que sí es cierto es que pueden usarse hasta 16 instrumentos diferentes a la vez, repartiéndose entre ellos la polifonía disponible. En un equipo General MIDI, éstos 16 instrumentos pueden elegirse de un banco de 128 sonidos de todo tipo, mientras que la percusión dispone de 10 kits diferentes.

El sonido 3D que ofrecen algunas tarjetas intenta dar al oyente la impresión de sonido envolvente. En el cine, el Sistema Surround está basado en el uso de varios altavoces situados en diferentes puntos de la sala. Sin embargo, obtener este efecto con sólo dos altavoces es mucho más complejo.

En un estudio de grabación, cuando se quiere “situar” unos sonidos en el frente y otros en el fondo, se juega con dos parámetros: el volumen (cuanto más alto, más cerca), y la reverberación (una especie de eco), que se produce cuando los sonidos están más alejados del oyente. Así se intenta distinguir entre sonidos cercanos y sonidos lejanos. De un modo similar, algunos receptores de TV estéreo, cuando reproducen un programa grabado en mono, simulan el estéreo retrasando ligeramente la señal de uno de los dos canales. Esto da un efecto pseudo-estéreo que resulta más agradable que el sonido mono.

En los años 70, después del desarrollo del sonido de alta fidelidad (hi-fi), se intentó dar un paso más con la cuadrafonía: se trataba de usar cuatro altavoces (con sus cuatro amplificadores correspondientes), colocados en las esquinas de un cuadrado, con el oyente en el centro. Con este sistema, podíamos “situar” un sonido en cualquier lugar de la habitación, manipulando su volumen independientemente en cada uno de los 4 canales. Sin embargo, este efecto resulta muy caro: no sólo se necesitan 4 altavoces y 4 amplificadores, sino que también la fuente de sonido (cassette, disco compacto...) tenía que estar grabado en cuadrofónico en vez de estéreo.

Algunos programas de grabación de audio multipista, permiten usar a la vez hasta 4 tarjetas de sonido en un mismo ordenador. Con ello, se obtienen hasta 8 canales de sonido simultáneos (4 estéreo), por lo que podíamos colocar altavoces en las 8 esquinas de un cubo tridimensional (4 arriba y 4 abajo). Todo ello, con 4 tarjetas de sonido normales, de 16 bits, cada una con su pareja de altavoces auto amplificados.

Gracias a la revolución de las tarjetas de sonido (y a la de los procesadores), ya están en el mercado los primeros reconocedores de voz fiables, ya sean procesadores de texto (VoiceType de IBM), como cursillos de idiomas, programas de intercambio de audio a través de la red, o sonidos de videojuegos con calidad de CD. En definitiva, a una mayor comodidad por parte del usuario.

Los Altavoces

La gran mayoría de las tarjetas de sonido incluyen un amplificador interno de 4W por canal, lo que nos permite conectar a la salida “speakers” de la tarjeta unos altavoces sencillos como los utilizados en los walkman. Pero si queremos obtener una calidad de sonido mayor, deberemos conectar unos altavoces auto-amplificados. Para hacer una buena elección de los altavoces hay que tener en cuenta:

-

El número de controles: para obtener una buena calidad, además del control de encendido/apagado y volumen, deben incluir controles independientes para graves y para agudos, e incluso una tecla para acentuar el “efecto surround”.

-

Para una óptima calidad, la mejor solución es un Subwoofer, que se coloca en el suelo, y dos, o mejor cuatro, altavoces que se colocan a la altura de la cabeza.

La solución más económica y la que proporciona mayor calidad de sonido es conectar la salida LINE OUT de la tarjeta de sonido a la entrada LINE IN de una cadena de sonido. Esto proporcionará una amplificación potente y un sonido tan bueno como en la propia cadena ya que la salida LINE OUT de la tarjeta de sonido proporciona 44,1KHz, es decir, calidad de sonido digital, como el de un reproductor de CD.

2.3.2. RECONOCEDORES DE VOZ

Uno de los campos de investigación actual más relevantes relacionados con la Informática es el reconocimiento de la voz. Se pretende una comunicación directa del hombre con el ordenador, sin necesidad de transcribir la información a través de un teclado u otros soportes intermedios de información.

Normalmente los dispositivos de reconocimiento de la voz o de la palabra tratan de identificar fonemas o palabras dentro de un repertorio o vocabulario muy limitado. Un fonema es un sonido simple o unidad del lenguaje hablado. Un sistema capaz de reconocer 7 palabras, lo que hace al detectar un sonido es extraer características o parámetros físicos inherentes a dicho sonido, y compararlos con los parámetros (previamente memorizados) de las 7 palabras que es capaz de reconocer. Si, como resultado de la comparación, se identifica como correspondiente a una de las 7 palabras, se transmite a la memoria intermedia del dispositivo el código binario identificador de la palabra. Si el sonido no se identifica, se indica esta circunstancia al usuario (iluminándose una luz, por ejemplo) para que el usuario vuelva a emitir el sonido. Existen dos tipos de unidades de reconocimiento de la voz:

Dependientes del usuario: En estos sistemas es necesario someter al dispositivo a un período de aprendizaje o programación, al cabo del cual puede reconocer ciertas palabras del usuario. En el período de aprendizaje el sistema retiene o memoriza las características o peculiaridades de los sonidos emitidos por el locutor, y que luego tendrá que identificar.

Independientes del usuario: Estos sistemas están más difundidos, pero el vocabulario que reconocen suele ser muy limitado. Los parámetros de las palabras que identifican vienen ya memorizados. Son utilizados, por ejemplo, para definir el movimiento de cierto tipo de robots. En este caso el operador da verbalmente órdenes elegidas de un repertorio muy limitado, como para, anda, arriba, abajo,... La unidad cuando capta un sonido comprueba si corresponde a uno de los del repertorio. En caso de identificación se transmite al ordenador central la información necesaria para la ejecución del programa que pone en marcha y controla la acción requerida.

2.4. RATONES Y TRACKBALLS

2.4.1. RATÓN

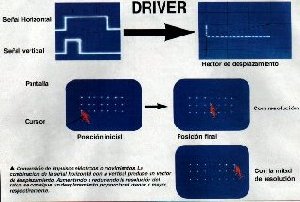

La función principal del ratón es transmitir los movimientos de nuestra mano sobre una superficie plana hacia el ordenador. Allí, el software denominado driver (Fig.2.10) se encarga realmente de transformarlo a un movimiento del puntero por la pantalla dependiendo de varios parámetros.

Figura 2.11. Driver del Ratón

En el momento de activar el ratón, se asocia su posición con la del cursor en la pantalla. Si desplazamos sobre una superficie el ratón, el cursor seguirá dichos movimientos. Es casi imprescindible en aplicaciones dirigidas por menús o entornos gráficos, como por ejemplo Windows, ya que con un pulsador adicional en cualquier instante se pueden obtener en programa las coordenadas (x,y) donde se encuentra el cursor en la pantalla, seleccionando de esta forma una de las opciones de un menú.

Hay cuatro formas de realizar la transformación y por tanto cuatro tipos de ratones:

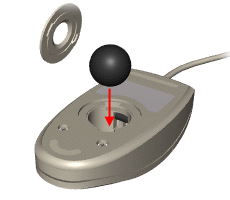

1.- Mecánicos: Son los más utilizados por su sencillez y bajo coste. Se basan en una bola de silicona que gira en la parte inferior del ratón a medida que desplazábamos éste. Dicha bola hace contacto con dos rodillos, uno perpendicular al ratón y otro transversal, de forma que uno recoge los movimientos de la bola en sentido horizontal y el otro en sentido vertical (Figura 2.12).

En cada extremo de los ejes donde están situados los rodillos, existe una pequeña rueda conocida como “codificador”, que gira en torno a cada rodillo. Estas ruedas poseen en su superficie, y a modo de radios, una serie de contactos de metal, que a medida que gira la rueda toca con dos pequeñas barras fijas conectadas al circuito integrado en el ratón.

Cada vez que se produce contacto entre el material conductor de la rueda y las barras, se origina una señal eléctrica. Así, el número de se señales indicará la cantidad de puntos que han pasado éstas, lo que implica que, a mayor número de señales, mayor distancia habrá recorrido el ratón. Tras convertir el movimiento en señales eléctricas, se enviaban al software del ordenador por medio del cable. (Fig. 2.13.)

Figura 2.12. Bola y zonas de contacto con los rodillos

Los botones son simples interruptores. Debajo de cada uno de ellos se encuentra un microinterruptor que en estado de “reposo” interrumpe un pequeño circuito. En cuanto se ejerce una ligera presión sobre estos, se activa el circuito, dejando pasar una señal eléctrica que será única en caso de que sólo se haga “clic” con el botón, o continua en caso de dejarlo pulsado.

Por último las señales se dan cita en el pequeño chip que gobierna el ratón, y son enviadas al ordenador a través del cable con los une. Allí el controlador del ratón decidirá, en función del desplazamiento vertical y horizontal detectado, el movimiento final que llevará el cursor. También será capaz de aumentar o disminuir ese movimiento, dependiendo de factores como la resolución que se le haya especificado al ratón.

Figura 2.13. Esquema general de un ratón mecánico.

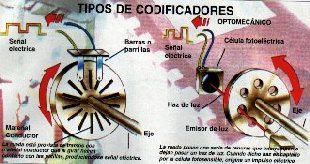

2.- Los ratones opto-mecánicos trabajan según el mismo principio que los mecánicos, pero aquí los cilindros están conectados a codificadores ópticos que emplean pulsos luminosos al ordenador, en lugar de señales eléctricas. El modo de capturar el movimiento es distinto. Los tradicionales rodillos que giran una rueda radiada ahora pueden girar una rueda ranurada, de forma que un haz de luz las atraviesa. De esta forma, el corte intermitente del haz de luz por la rueda es recogido en el otro lado por una célula fotoeléctrica que decide hacia donde gira el ratón y a que velocidad (figura 2.14).

Figura 2.14. Codificadores del ratón.

3.- Los ratones de ruedas sustituyen la bola giratoria por unas ruedas de material plástico, perpendiculares entre sí, dirigiendo así a los codificadores directamente.

4.- Los ratones ópticos carecen de bola y rodillos, y poseen unos foto-sensores o sensores ópticos que detectan los cambios en los patrones de la superficie por la que se mueve el ratón. Antiguamente, estos ratones necesitaban una alfombrilla especial, pero actualmente no. Microsoft ha denominado a este sistema IntelliEye en su ratón IntelliMouse y es capaz de explorar el escritorio 1500 veces por segundo, sobre multitud de superficies distintas como madera plástico o tela. La ventaja de estos ratones estriba en su precisión y en la carencia de partes móviles, aunque son lógicamente algo más caros que el resto.