Tecnología de la Información

Fuente de alimentación

LA FUENTE DE ALIMENTACION

La fuente de alimentación (Power supply en ingés) es como su nombre indica, la encargada de suministrar energía eléctrica a los distintos elementos que componen nuestro sistema informático.

La electricidad que llega hasta nuestros hogares u oficinas es del tipo conocido como "corriente alterna" y nos es suministrada habitualmente con una tensión (o voltaje) que suele ser de alrededor de 115 o 230 voltios. Este tipo de corriente no es en absoluto adecuada para alimentar equipos electrónicos, y más concretamente dispositivos informáticos, en dónde es necesario trabajar con "corriente continua" y voltajes mucho más bajos...

Por tanto, este dispositivo es el que se encarga de "reducir" el voltaje (mediante un transformador) y posteriormente convertir la corriente alterna en continua (con un puente de diodos) para finalmente filtrarla (mediante condensadores electrolíticos).

Evidentemente el esquema es mucho más complejo que el comentado, ya que en su interior se encuentran muchos otros componentes

Uno de los aspectos mesurables de una fuente de alimentación es su potencia. Esta viene expresada en vatios e indica la capacidad para alimentar más dispositivos o de mayor consumo. Suele ser habitual encontrar modelos entre 200 y 300 w (vatios), aunque también existen otros, sobretodo los que siguen el estándar MicroATX o FlexATX que ofrecen potencias menores.

Otra característica bastante obvia es la tensión soportada, así como la frecuencia de la misma. Existen modelos que sólo funcionan con un tipo determinado, y otros, normalmente bitensión que permiten ser utilizados prácticamente en cualquier zona del mundo. De éstos, la mayoría incluyen un pequeño conmutador para pasar de una a otra o incluso algunos más sofisticados realizan esta misma tarea automáticamente.

Es muy importante que si compramos un modelo en una zona geográfica que no sea la nuestra tengamos mucha precaución con este aspecto, ya que conectar un equipo a una tensión más alta de la permitida puede ocasionar grandes daños en él.

Otros aspectos a tener en cuenta son la protección contra cortocircuitos y subidas de tensión, aunque en la práctica, sin un buen estabilizador de tensión es dificil obtener una buena protección.

En la parte trasera encontraremos el típico conector que utilizaremos para enchufar la fuente a la red eléctrica, y también es corriente encontrar otro del mismo tipo pero "hembra" al que podemos conectar el monitor en el caso de que tengamos el cable adecuado (no es lo habitual). En todo caso, siempre podremos adquirir uno (ver foto). La principal ventaja es que al apagar el ordenador (y en las placas ATX esto se puede hacer por software) también cortamos la alimentación del monitor.

También encontraremos los cables de alimentación para las unidades de almacenamiento tales como discos, CD-ROM, etc. En general suelen ser 4 conectores. También encontraremos uno o dos para la disquetera y por último el que alimenta la placa base, que en las placas ATX es un único conector y en las AT son dos conectores, normalmente marcados como P8 y P9. En este último caso es muy importante no confundirse, pues ambos son físicamente iguales. Una forma de comprobar que los estamos conectando de forma correcta es comprobar que los cables de color negro estén juntos y en el centro de ambos.

En los modelos para máquinas AT es también imprescindible que incorporen un interruptor para encender y apagar la máquina, no así en las basadas en ATX, pues la orden de encendido le llegará a través de una señal desde la propia placa base. Todo y así es bastante habitual encontrar uno para "cortar" el fluido eléctrico a su interior, pues los ordenadores basados en éste estándar están permanentemente alimentados, aun cuando están apagados. Es por ello que siempre que trasteemos en su interior es IMPRESCINDIBLE que o bien utilicemos el interruptor comentado o bien desenchufemos el cable de alimentación.

Por último comentar que para poder probar una de estas fuentes sin necesidad de conectarlas a un ordenador (seguimos hablando de las ATX) es necesario cortocircuitar los pines 14 y 15 del conector de alimentación de la placa base (ver esquema del mismo en enlace inferior) durante unos segundos, con lo que conseguiremos simular la señal que arranque que envía la placa base. Acto seguido hemos de ver como el ventilador se pone en marcha. Para apagarla, procederemos de nuevo a efectuar el cortocircuito o simplemente quitaremos la alimentación.

Uno de los aspectos más importantes de las fuentes de alimentación es su capacidad para evacuar el calor generado por los distintos componentes electrónicos que se encuentran dentro de la caja. A pesar de que en las cajas "ATX" está prevista la incorporación de ventiladores que se encarguen de esta función, no suele ser lo habitual, dejando normalmente todo el trabajo a nuestra sufrida fuente de alimentación.

En las de tipo "AT" el esquema seguido normalmente siempre es el mismo. Un ventilador colocado en la parte más externa de la misma evacua el calor que genera dicha fuente y de paso, mediante unas aberturas que le comunican con el interior de la caja la propia corriente de aire generada aspira el aire caliente que en ella se encuentra.

En las que son de tipo ATX, el esquema utilizado varía bastante, pudiendo encontrar modelos que siguen el mismo método que el comentado para las AT o alguna variación que incorpora unas ranuras situadas justo encima del procesador.

Otro esquema utilizado es el que el ventilador se coloca justo encima del procesador, ya que éste es uno de los focos de calor más importantes. Esta disposición además tiene otra ventaja que es la de poder colocar un ventilador más grande (ver foto, pero pensar que está colocada justo al revés para que se vea el ventilador)

Sin embargo son muchos los fabricantes que utilizan esta disposición para "soplar" aire al procesador en vez de expulsarlo, lo que no siempre permite una buena refrigeración de nuestro sistema debido a que el aire caliente no es expulsado al exterior, sino que por el contrario estamos introduciendo en él aire ya caliente provinente de la fuente de alimentación.

Además, el propio procesador ya incorpora su radiador y ventilador, por lo que lo único que logramos es remover el aire caliente que se encuentra en el interior de nuestra caja y que éste sea cada vez más caliente.

En el caso de que nuestro sistema adolezca de ese problema, podemos desmontar la misma e intentar darle la vuelta.

PUERTOS

Las computadoras personales actuales aún conservan prácticamente todos los puertos heredados desde que se diseñó el primer PC de IBM. Por razones de compatibilidad aún seguiremos viendo este tipo de puertos, pero poco a poco irán apareciendo nuevas máquinas en las que no contaremos con los típicos conectores serie, paralelo, teclado, etc... y en su lugar sólo encontraremos puertos USB, Fireware (IEE 1394) o SCSI

SERIE

El puerto serie de una computadora es un adaptador asíncrono utilizado para poder intercomunicar varias computadoras entre sí.

Un puerto serie recibe y envía información fuera de la computadora mediante un determinado software de comunicación o un driver del puerto serie.

El software envía la información al puerto carácter a carácter, conviertiéndolo en una señal que puede ser enviada por un cable serie o un módem.

Cuando se ha recibido un carácter, el puerto serie envía una señal por medio de una interrupción indicando que el carácter está listo. Cuando la computadora ve la señal, los servicios del puerto serie leen el carácter.

PARALELO

Tras la acentuada falta de estandarización del interfaz paralelo, surgió Centronics como un standard en este tipo de conexión, debido a la facilidad de uso y la comodidad a la hora de trabajar con él.

A raíz de este interfaz, posteriormente apareció una norma standard (IEEE 1284) para el interfaz paralelo en las computadoras personales, en la cual se tratan varios tipos de protocolos los cuales se verán a lo largo de este trabajo.

La transmisión en paralelo entre una computadora y un periférico, se basa en la transmisión de datos simultáneamente por varios canales, generalmente 8 bits. Por esto se necesitan 8 cables para la transmisión de cada bit, mas otros tantos cables para controles del dispositivo, el numero de estos dependerá del protocolo de transmisión utilizado.

Usb ( Universal Serial Bus)

Desde que nació el PC de la mano de I.B.M., por motivos de compatibilidad, algunas de sus características han permanecido inalterables al paso del tiempo.

Conectores como el de la salida paralelo (o Centronics), la salida serie (RS-232) o el conector del teclado han sufrido muy pocas variaciones.

Si bien es cierto que estos conectores todavía hoy cumplen su función correctamente en casos como la conexión de un teclado, un ratón o un módem, se han quedado ya desfasados cuando tratamos de conectar dispositivos más rápidos como por ejemplo una cámara de video digital.

USB nace como un estándar de entrada/salida de velocidad media-alta que va a permitir conectar dispositivos que hasta ahora requerían de una tarjeta especial para sacarles todo el rendimiento, lo que ocasionaba un encarecimiento del producto además de ser productos propietarios ya que obligaban a adquirir una tarjeta para cada dispositivo.

Pero además, USB nos proporciona un único conector para solventar casi todos los problemas de comunicación con el exterior, pudiéndose formar una auténtica red de periféricos de hasta 127 elementos.

Mediante un par de conectores USB que ya hoy en día son estándar en todas las placas base, y en el espacio que hoy ocupa un sólo conector serie de 9 pines nos va a permitir conectar todos los dispositivos que tengamos, desde el teclado al módem, pasando por ratones, impresoras, altavoces, monitores, scaners, cámaras digitales, de video, plotters, etc... sin necesidad de que nuestro PC disponga de un conector dedicado para cada uno de estos elementos, permitiendo ahorrar espacio y dinero.

Al igual que las tarjeta ISA tienden a desaparecer, todos los conectores anteriormente citados también desaparecerán de nuestra computadora, eliminando además la necesidad de contar en la placa base o en una tarjeta de expansión los correspondientes controladores para dispositivos serie, paralelo, ratón PS/2, joystick, etc...

Como puedes ver, realmente es un estándar que es necesario para facilitarnos la vida, ya que además cuenta con la famosa característica PnP (Plug and Play) y la facilidad de conexión "en caliente", es decir, que se pueden conectar y desconectar los periféricos sin necesidad de reiniciar la computadora.

Otras características que también deberemos saber son:

Dos velocidades de acceso, una baja de 1,5 Mbps para dispositivos lentos como pueden ser joysticks o teclados y otra alta de 12 Mbps para los dispositivos que necesiten mayor ancho de banda.

Topología en estrella, lo que implica la necesidad de dispositivos tipo "hub" que centralicen las conexiones, aunque en algunos dispositivos como teclados y monitores ya se implementa esta característica, lo que permite tener un sólo conector al PC, y desde estos dispositivos sacar conexiones adicionales.

Por ejemplo en los teclados USB se suele implementar una conexión adicional para el ratón, o incluso otras para joystick, etc.. y en los monitores varias salidas para el módem, los altavoces...

Permite suministrar energía eléctrica a dispositivos que no tengan un alto consumo y que no estén a más de 5 metros, lo que elimina la necesidad de conectar dichos periféricos a la red eléctrica, con sus correspondientes fuentes de alimentación, como ahora ocurre por ejemplo con los módems externos.

DISQUETERA

Por malo y anticuado que sea un ordenador, siempre dispone de al menos uno de estos aparatos. Su capacidad es totalmente insuficiente para las necesidades actuales, pero cuentan con la ventaja que les dan los muchos años que llevan como estándar absoluto para almacenamiento portátil.

¿Estándar? Bien, quizá no tanto. Desde aquel lejano 1.981, el mundo del PC ha conocido casi diez tipos distintos de disquetes y de lectores para los mismos. Originariamente los disquetes eran flexibles y bastante grandes, unas 5,25 pulgadas de ancho. La capacidad primera de 160 Kb se reveló enseguida como insuficiente, por lo que empezó a crecer y no paró hasta los 1,44 MB, ya con los disquetes actuales, más pequeños (3,5"), más rígidos y protegidos por una pestaña metálica.

Incluso existe un modelo de 2,88 MB y 3,5" que incorporaban algunos ordenadores IBM, pero no llegó a cuajar porque los discos resultaban algo caros y seguían siendo demasiado escasos para aplicaciones un tanto serias; mucha gente opina que hasta los 100 MB de un Zip son insuficientes. De cualquier forma, los tipos más comunes de disquetes aparecen en la siguiente tabla:

Las disqueteras son compatibles "hacia atrás"; es decir, que en una disquetera de 3,5" de alta densidad (de 1,44 MB) podemos usar discos de 720 Kb o de 1,44 MB, pero en una de doble densidad, más antigua, sólo podemos usarlos de 720 Kb.

Por cierto, para distinguir a primera vista un disco de 3,5" de alta densidad de otro de doble, basta con observar el número de agujeros que presenta en su parte inferior. Si tiene sólo uno, situado en el lado izquierdo de la imagen y generalmente provisto de una pestaña móvil, se trata de un disco de doble densidad; si tiene dos agujeros, no hay duda de que se trata de un disco de alta densidad. Si el primero de los agujeros está al descubierto el disco estará protegido contra escritura; el segundo sólo sirve para diferenciar ambos tipos de disquetes.

De cualquier forma, el disquete deberá estar formateado a la capacidad correcta, para lo cual podemos usar la orden FORMAT del DOS o bien los menús de Windows (personalmente, prefiero la orden de DOS). Debe tenerse en cuenta que si no especificamos nada, el disco intentará ser formateado a la capacidad nominal de la disquetera, lo que con un disco de capacidad inferior puede ser un error desastroso. Por ejemplo, a continuación aparecen algunas órdenes de formateado comunes:

Los ordenadores normales disponen de un puerto para dos disqueteras, que irán conectadas a un único cable de datos. La que esté conectada en el extremo del mismo será la primera (la "A" en DOS) y la que esté en el segundo conector, entre el ordenador y la anterior disquetera, será la segunda (la "B").

Resulta común tener un ordenador que resulta suficiente para las tareas que le pedimos, pero que tiene una disquetera de un modelo anticuado, bien de 5,25" o de 3,5" de doble densidad, para las que incluso puede ser difícil encontrar discos apropiados (especialmente en el caso de las de 5,25"). En tal caso, merece la pena instalar una disquetera moderna de 3,5" y 1,44 MB, ya que cuestan menos de 5.000 pts y es una de las tareas más sencillas de hacer

Los disquetes tienen fama de ser unos dispositivos muy poco fiables en cuanto al almacenaje a largo plazo de la información; y en efecto, lo son. Les afecta todo lo imaginable: campos magnéticos, calor, frío, humedad, golpes, polvo... Hace un tiempo verifiqué unos 25 disquetes de diferentes marcas de un antiguo 286, que estaban guardados en una caja de plástico para disquetes, y casi la mitad no funcionaba, lo que no me sorprendió en absoluto.

DISCO DURO

Son otro de los elementos habituales en los ordenadores, al menos desde los tiempos del 286. Un disco duro está compuesto de numerosos discos de material sensible a los campos magnéticos, apilados unos sobre otros; en realidad se parece mucho a una pila de disquetes sin sus fundas y con el mecanismo de giro y el brazo lector incluido en la carcasa.

Los discos duros han evolucionado mucho desde los modelos primitivos de 10 ó 20 MB. Actualmente los tamaños son del orden de varios gigabytes, el tiempo medio de acceso es muy bajo (menos de 20 ms) y su velocidad de transferencia es tan alta que deben girar a más de 5.000 rpm (revoluciones por minuto), lo que desgraciadamente hace que se calienten como demonios, por lo que no es ninguna tontería instalarles un ventilador para su refrigeración.

Una diferencia fundamental entre unos y otros discos duros es su interfaz de conexión. Antiguamente se usaban diversos tipos, como MFM, RLL o ESDI, aunque en la actualidad sólo se emplean dos: IDE y SCSI

Discos IDE

El interfaz IDE (más correctamente denominado ATA, el estándar de normas en que se basa) es el más usado en PCs normales, debido a que tiene un balance bastante adecuado entre precio y prestaciones. Los discos duros IDE se distribuyen en canales en los que puede haber un máximo de 2 dispositivos por canal; en el estándar IDE inicial sólo se disponía de un canal, por lo que el número máximo de dispositivos IDE era 2.

El estándar IDE fue ampliado por la norma ATA-2 en lo que se ha dado en denominar EIDE (Enhanced IDE o IDE mejorado). Los sistemas EIDE disponen de 2 canales IDE, primario y secundario, con lo que pueden aceptar hasta 4 dispositivos, que no tienen porqué ser discos duros mientras cumplan las normas de conectores ATAPI; por ejemplo, los CD-ROMs y algunas unidades SuperDisk se presentan con este tipo de conector.

En cada uno de los canales IDE debe haber un dispositivo Maestro (master) y otro Esclavo (slave). El maestro es el primero de los dos y se suele situar al final del cable, asignándosele generalmente la letra "C" en DOS. El esclavo es el segundo, normalmente conectado en el centro del cable entre el maestro y la controladora, la cual muchas veces está integrada en la propia placa base; se le asignaría la letra "D".

Los dispositivos IDE o EIDE como discos duros o CD-ROMs disponen de unos microinterruptores (jumpers), situados generalmente en la parte posterior o inferior de los mismos, que permiten seleccionar su carácter de maestro, esclavo o incluso otras posibilidades como "maestro sin esclavo". Las posiciones de los jumpers vienen indicadas en una pegatina en la superficie del disco, o bien en el manual o serigrafiadas en la placa de circuito del disco duro, con las letras M para designar "maestro" y S para "esclavo"

Aunque en este terreno se barajan las cifras de transferencia máxima teóricas entre el disco duro y el PC, no las que físicamente puede alcanzar el disco internamente; los 66,6 MB/s son absolutamente inalcanzables para cualquier disco duro actual. En realidad, llegar a 25 MB/s con un disco duro UltraDMA es algo bastante difícil de conseguir, actualmente las cifras habituales están más bien por unos 10 a 20 MB/s.

Los modos PIO se habilitan generalmente mediante la BIOS y dan pocos problemas, aunque en discos duros no actuales a veces la autodetección del modo PIO da un modo un grado superior al que realmente puede soportar con fiabilidad, pasa mucho por ejemplo con discos que se identifican como PIO-4 pero que no son fiables más que a PIO-3.

Los modos DMA tienen la ventaja de que liberan al microprocesador de gran parte del trabajo de la transferencia de datos, encargándoselo al chipset de la placa (si es que éste tiene esa capacidad, como ocurre desde los tiempos de los Intel Tritón), algo parecido a lo que hace la tecnología SCSI. Sin embargo, la activación de esta característica (conocida como bus mastering) requiere utilizar los drivers adecuados y puede dar problemas con el CD-ROM, por lo que en realidad el único modo útil es el UltraDMA (y ni siquiera he comentado los muy desfasados modos DMA singleword).

Se debe tener en cuenta que la activación o no de estas características es opcional y la compatibilidad hacia atrás está garantizada; podemos comprar un disco duro UltraDMA y usarlo en modo PIO-0 sin problemas, sólo estaremos tirando el dinero. Así que si quiere un disco para un 486 que no soporta bus mastering, no se preocupe: compre un disco UltraDMA y seleccione el modo PIO-4, apenas apreciará la diferencia de rendimiento y la instalación será incluso más sencilla.

Discos SCSI

la ventaja de estos discos no está en su mecánica, que puede ser idéntica a la de uno IDE (misma velocidad de rotación, mismo tiempo medio de acceso...) sino en que la transferencia de datos es más constante y casi independiente de la carga de trabajo del microprocesador.

Esto hace que la ventaja de los discos duros SCSI sea apreciable en ordenadores cargados de trabajo, como servidores, ordenadores para CAD o vídeo, o cuando se realiza multitarea de forma intensiva, mientras que si lo único que queremos es cargar Word y hacer una carta la diferencia de rendimiento con un disco UltraDMA será inapreciable.

En los discos SCSI resulta raro llegar a los 20 MB/s de transferencia teórica del modo Ultra SCSI, y ni de lejos a los 80 MB/s del modo Ultra-2 Wide SCSI, pero sí a cifras quizá alcanzables pero nunca superables por un disco IDE. De lo que no hay duda es que los discos SCSI son una opción profesional, de precio y prestaciones elevadas, por lo que los fabricantes siempre escogen este tipo de interfaz para sus discos de mayor capacidad y velocidad. Resulta francamente difícil encontrar un disco duro SCSI de mala calidad, pero debido a su alto precio conviene proteger nuestra inversión buscando uno con una garantía de varios años, 3 ó más por lo que pueda pasar... aunque sea improbable

TARJETA DE VIDEO

De manera resumida, es lo que transmite al monitor la información gráfica que debe presentar en la pantalla. Con algo más de detalle, realiza dos operaciones:

-

Interpreta los datos que le llegan del procesador, ordenándolos y calculando para poder presentarlos en la pantalla en forma de un rectángulo más o menos grande compuesto de puntos individuales de diferentes colores (pixels).

-

Coge la salida de datos digitales resultante de ese proceso y la transforma en una señal analógica que pueda entender el monitor.

Estos dos procesos suelen ser realizados por uno o más chips: el microprocesador gráfico (el cerebro de la tarjeta gráfica) y el conversor analógico-digital o RAMDAC, aunque en ocasiones existen chips accesorios para otras funciones o bien se realizan todas por un único chip.

El microprocesador puede ser muy potente y avanzado, tanto o más que el propio micro del ordenador; por eso algunos tienen hasta nombre propio: Virge, Rage Pro, Voodoo, TNT2... Incluso los hay con arquitecturas de 256 bits, el cuádruple que los Pentium.

En el principio, los ordenadores eran ciegos; todas las entradas y salidas de datos se realizaban mediante tarjetas de datos perforadas, o mediante el teclado y primitivas impresoras. Un buen día, alguien pensó que era mucho más cómodo acoplar una especie de televisor al ordenador para observar la evolución del proceso y los datos, y surgieron los monitores, que debían recibir su información de cierto hardware especializado: la tarjeta de vídeo.

MDA

En los primeros ordenadores, los gráficos brillaban... por su ausencia. Las primeras tarjetas de vídeo presentaban sólo texto monocromo, generalmente en un agradable tono ámbar o verde fosforito que dejaba los ojos hechos polvo en cuestión de minutos. De ahí que se las denominase MDA, Monochrome Display Adapter.

CGA

Luego, con la llegada de los primeros PCs, surgió una tarjeta de vídeo capaz de presentar gráficos: la CGA (Computer Graphics Array, dispositivo gráfico para ordenadores).

Lo cual, aunque parezca increíble, resultó toda una revolución. Aparecieron multitud de juegos que aprovechaban al máximo tan exiguas posibilidades, además de programas más serios, y los gráficos se instalaron para siempre en el PC.

Hércules

Se trataba ésta de una tarjeta gráfica de corte profundamente profesional. Su ventaja, poder trabajar con gráficos a 720x348 puntos de resolución, algo alucinante para la época; su desventaja, que no ofrecía color. Es por esta carencia por la que no se extendió más, porque jugar sin color no es lo mismo, y el mundo PC avanza de la mano de los diseñadores de juegos (y va muy en serio).

EGA

Otro inventito exitoso de IBM.

Estas cifras hacían ya posible que los entornos gráficos se extendieran al mundo PC (los Apple llevaban años con ello), y aparecieron el GEM, el Windows y otros muchos. Sobre las posibilidades de las pantallas EGA, una curiosidad: los drivers EGA de Windows 3.1 funcionan sobre Windows 95, y resulta curioso (y sumamente incómodo, la verdad) ver dicha combinación...

VGA

El estándar, la pantalla de uso obligado desde hace ya 10 años. Tiene multitud de modos de vídeo posibles, aunque el más común es el de 640x480 puntos con 256 colores, conocido generalmente como "VGA estándar" o "resolución VGA".

SVGA, XGA y superiores

El éxito del VGA llevó a numerosas empresas a crear sus propias ampliaciones del mismo, siempre centrándose en aumentar la resolución y/o el número de colores disponibles. De cualquier manera, la frontera entre unos estándares y otros es sumamente confusa, puesto que la mayoría de las tarjetas son compatibles con más de un estándar, o con algunos de sus modos. Además, algunas tarjetas ofrecen modos adicionales al añadir más memoria de vídeo.

En el contexto que nos ocupa, la resolución es el número de puntos que es capaz de presentar por pantalla una tarjeta de vídeo, tanto en horizontal como en vertical. Así, "800x600" significa que la imagen está formada por 600 rectas horizontales de 800 puntos cada una. Para que nos hagamos una idea, un televisor (de cualquier tamaño) tiene una resolución equivalente de 800x625 puntos.

En cuanto al número de colores, resulta casi evidente: los que puede presentar a la vez por pantalla la tarjeta. Así, aunque las tarjetas EGA sólo representan a la vez 16 colores, los eligen de una paleta (sí, como las de pintor) de 64 colores.

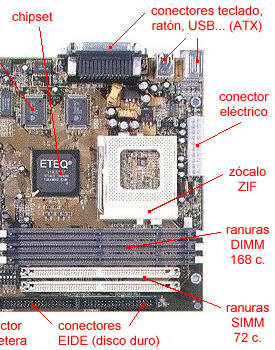

PLACA BASE

La "placa base" (mainboard), o "placa madre" (motherboard), es el elemento principal de todo ordenador, en el que se encuentran o al que se conectan todos los demás aparatos y dispositivos.

Físicamente, se trata de una "oblea" de material sintético, sobre la cual existe un circuito electrónico que conecta diversos elementos que se encuentran anclados sobre ella; los principales son:

-

el microprocesador, "pinchado" en un elemento llamado zócalo;

-

la memoria, generalmente en forma de módulos;

-

los slots o ranuras de expansión donde se conectan las tarjetas;

-

diversos chips de control, entre ellos la BIOS.

Las placas base existen en diferentes formas y con diversos conectores para periféricos. Para abaratar costes permitiendo la intercambiabilidad entre placas base, los fabricantes han ido definiendo varios estándares que agrupan recomendaciones sobre su tamaño y la disposición de los elementos sobre ellas.

De cualquier forma, el hecho de que una placa pertenezca a una u otra categoría no tiene nada que ver, al menos en teoría, con sus prestaciones ni calidad. Los tipos más comunes son:

ATX

Se las supone de más fácil ventilación y menos maraña de cables que las Baby-AT, debido a la colocación de los conectores. Para ello, el microprocesador suele colocarse cerca del ventilador de la fuente de alimentación y los conectores para discos cerca de los extremos de la placa.

La diferencia "a ojo descubierto" con las AT se encuentra en sus conectores, que suelen ser más (por ejemplo, con USB o con FireWire), están agrupados y tienen el teclado y ratón en clavijas mini-DIN Además, reciben la electricidad mediante un conector formado por una sola pieza (ver foto superior).

Baby-AT

Fue el estándar absoluto durante años. Define una placa de unos 220x330 mm, con unas posiciones determinadas para el conector del teclado, los slots de expansión y los agujeros de anclaje a la caja, así como un conector eléctrico dividido en dos piezas.

Estas placas son las típicas de los ordenadores "clónicos" desde el 286 hasta los primeros Pentium. Con el auge de los periféricos (tarjeta sonido, CD-ROM, discos extraíbles...) salieron a la luz sus principales carencias: mala circulación del aire en las cajas (uno de los motivos de la aparición de disipadores y ventiladores de chip) y, sobre todo, una maraña enorme de cables que impide acceder a la placa sin desmontar al menos alguno.

Para identificar una placa Baby-AT, lo mejor es observar el conector del teclado, que casi seguro que es una clavija DIN ancha, como las antiguas de HI-FI; o bien mirar el conector que suministra la electricidad a la placa, que deberá estar dividido en dos piezas, cada una con 6 cables, con 4 cables negros (2 de cada una) en el centro.

LPX

Estas placas son de tamaño similar a las Baby-AT, aunque con la peculiaridad de que los slots para las tarjetas de expansión no se encuentran sobre la placa base, sino en un conector especial en el que están pinchadas, la riser card.

De esta forma, una vez montadas, las tarjetas quedan paralelas a la placa base, en vez de perpendiculares como en las Baby-AT; es un diseño típico de ordenadores de sobremesa con caja estrecha (menos de 15 cm de alto), y su único problema viene de que la riser card no suele tener más de dos o tres slots, contra cinco en una Baby-AT típica.

Diseños propietarios

Pese a la existencia de estos estándares, los grandes fabricantes de ordenadores (IBM, Compaq, Hewlett-Packard...) suelen sacar al mercado placas de tamaños y formas peculiares, bien porque estos diseños no se adaptan a sus necesidades o por oscuros e ignotos motivos.

Si usted se está planteando actualizar un ordenador "de marca", tenga en cuenta que quizá tenga que gastarse otras 5.000 ptas en una caja nueva, a veces por motivos tan irritantes como que los taladros o el conector de teclado estén a medio centímetro de las posiciones normales.

De cualquier forma, hasta los grandes de la informática usan cada vez menos estas placas "a medida", sobre todo desde la llegada de las placas ATX.

MICROPROCESADOR

El microprocesador, o simplemente el micro, es el cerebro del ordenador. Es un chip, un tipo de componente electrónico en cuyo interior existen miles (o millones) de elementos llamados transistores, cuya combinación permite realizar el trabajo que tenga encomendado el chip.

Los micros, como los llamaremos en adelante, suelen tener forma de cuadrado o rectángulo negro, y van o bien sobre un elemento llamado zócalo (socket en inglés) o soldados en la placa o, en el caso del Pentium II, metidos dentro de una especie de cartucho que se conecta a la placa base (aunque el chip en sí está soldado en el interior de dicho cartucho).

A veces al micro se le denomina "la CPU" (Central Process Unit, Unidad Central de Proceso), aunque este término tiene cierta ambigüedad, pues también puede referirse a toda la caja que contiene la placa base, el micro, las tarjetas y el resto de la circuitería principal del ordenador.

La velocidad de un micro se mide en megahertzios (MHz) o gigahertzios (1 GHz = 1.000 MHz), aunque esto es sólo una medida de la fuerza bruta del micro; un micro simple y anticuado a 500 MHz puede ser mucho más lento que uno más complejo y moderno (con más transistores, mejor organizado...) que vaya a "sólo" 400 MHz. Es lo mismo que ocurre con los motores de coche: un motor americano de los años 60 puede tener 5.000 cm3, pero no tiene nada que hacer contra un multiválvula actual de "sólo" 2.000 cm3.

Debido a la extrema dificultad de fabricar componentes electrónicos que funcionen a las inmensas velocidades de MHz habituales hoy en día, todos los micros modernos tienen 2 velocidades:

-

Velocidad interna: la velocidad a la que funciona el micro internamente (200, 333, 450... MHz).

-

Velocidad externa o del bus: o también "velocidad del FSB"; la velocidad a la que se comunican el micro y la placa base, para poder abaratar el precio de ésta. Típicamente, 33, 60, 66, 100 ó 133 MHz.

La cifra por la que se multiplica la velocidad externa o de la placa para dar la interna o del micro es el multiplicador; por ejemplo, un Pentium III a 450 MHz utiliza una velocidad de bus de 100 MHz y un multiplicador 4,5x.

En un micro podemos diferenciar diversas partes:

-

el encapsulado: es lo que rodea a la oblea de silicio en sí, para darle consistencia, impedir su deterioro (por ejemplo por oxidación con el aire) y permitir el enlace con los conectores externos que lo acoplarán a su zócalo o a la placa base.

-

la memoria caché: una memoria ultrarrápida que emplea el micro para tener a mano ciertos datos que previsiblemente serán utilizados en las siguientes operaciones sin tener que acudir a la memoria RAM, reduciendo el tiempo de espera.

Todos los micros "compatibles PC" desde el 486 poseen al menos la llamada caché interna de primer nivel o L1; es decir, la que está más cerca del micro, tanto que está encapsulada junto a él. Los micros más modernos (Pentium III Coppermine, Athlon Thunderbird, etc.) incluyen también en su interior otro nivel de caché, más grande aunque algo menos rápida, la caché de segundo nivel o L2. -

el coprocesador matemático: o, más correctamente, la FPU (Floating Point Unit, Unidad de coma Flotante). Parte del micro especializada en esa clase de cálculos matemáticos; antiguamente estaba en el exterior del micro, en otro chip.

-

el resto del micro: el cual tiene varias partes (unidad de enteros, registros, etc.) que no merece la pena detallar aquí

![]()

LA MEMORIA RAM

La memoria principal o RAM (acrónimo de Random Access Memory, Memoria de Acceso Aleatorio) es donde el ordenador guarda los datos que está utilizando en el momento presente; son los "megas" famosos en número de 32, 64 ó 128 que aparecen en los anuncios de ordenadores.

Físicamente, los chips de memoria son rectángulos negros que suelen ir soldados en grupos a unas plaquitas con "pines" o contactos, algo así:

La diferencia entre la RAM y otros tipos de memoria de almacenamiento, como los disquetes o los discos duros, es que la RAM es mucho (mucho) más rápida, y que se borra al apagar el ordenador, no como éstos.

![]()

-

DRAM: Dinamic-RAM, o RAM a secas, ya que es "la original", y por tanto la más lenta (aunque recuerde: siempre es mejor tener la suficiente memoria que tener la más rápida, pero andar escasos).

Usada hasta la época del 386, su velocidad de refresco típica es de 80 ó 70 nanosegundos (ns), tiempo éste que tarda en vaciarse para poder dar entrada a la siguiente serie de datos. Por ello, es más rápida la de 70 ns que la de 80 ns.

Físicamente, aparece en forma de DIMMs o de SIMMs, siendo estos últimos de 30 contactos. -

Fast Page (FPM): a veces llamada DRAM (o sólo "RAM"), puesto que evoluciona directamente de ella, y se usa desde hace tanto que pocas veces se las diferencia. Algo más rápida, tanto por su estructura (el modo de Página Rápida) como por ser de 70 ó 60 ns.

Usada hasta con los primeros Pentium, físicamente aparece como SIMMs de 30 ó 72 contactos (los de 72 en los Pentium y algunos 486). -

EDO: o EDO-RAM, Extended Data Output-RAM. Evoluciona de la Fast Page; permite empezar a introducir nuevos datos mientras los anteriores están saliendo (haciendo su Output), lo que la hace algo más rápida (un 5%, más o menos).

Muy común en los Pentium MMX y AMD K6, con refrescos de 70, 60 ó 50 ns. Se instala sobre todo en SIMMs de 72 contactos, aunque existe en forma de DIMMs de 168. -

SDRAM: Sincronic-RAM. Funciona de manera sincronizada con la velocidad de la placa (de 50 a 66 MHz), para lo que debe ser rapidísima, de unos 25 a 10 ns. Sólo se presenta en forma de DIMMs de 168 contactos; es usada en los Pentium II de menos de 350 MHz y en los Celeron.

-

PC100: o SDRAM de 100 MHz. Memoria SDRAM capaz de funcionar a esos 100 MHz, que utilizan los AMD K6-2, Pentium II a 350 MHz y micros más modernos; teóricamente se trata de unas especificaciones mínimas que se deben cumplir para funcionar correctamente a dicha velocidad, aunque no todas las memorias vendidas como "de 100 MHz" las cumplen...

-

PC133: o SDRAM de 133 MHz. La más moderna (y recomendable).

MEMORIA ROM

Su nombre vienen del inglés Read Only Memory que significa Memoria de Solo Lectura ya que la información que contiene puede ser leída pero no modificada. En ella se encuentra toda la información que el sistema necesita para poder funcionar correctamente ya que los fabricantes guardan allí las instrucciones de arranque y el funcionamiento coordinado de la computadora. no son volátiles, pero se pueden deteriorar a causa de campos magnéticos demasiados potentes.

Al encender nuestra computadora automáticamente comienza a funcionar la memoria ROM. por supuesto, aunque se apague, esta memoria no se borra.

El BIOS de una PC (Basic Input Operative System) es una memoria ROM, pero con la facultad de configurarse según las características particulares de cada máquina. esta configuración se guarda en la zona de memoria RAM que posee este BIOS y se mantiene sin borrar cuando se apaga la PC gracias a una pila que hay en la placa principal.

Cuando la pila se agota se borra la configuración provocando, en algunos equipos, que la máquina no arranque

Algunas PC tienen la pila soldada a la placa principal por lo que el cambio de la misma lo debe realizar personal técnico, ya que sino se corre el riesgo de arruinar otros componentes.

Descargar

| Enviado por: | Ninfaa |

| Idioma: | catalán |

| País: | España |